Что такое корреляция и что означает коррелировать — простыми словами о сложном

Здравствуйте, уважаемые читатели блога KtoNaNovenkogo.ru. Когда некоторые люди слышат слово «корреляция», то зачастую просто впадают в ступор. Оно и понятно: жуткий термин из мира высшей математики и статистики.

Сразу представляются унылые графики, многоэтажные формулы, при взгляде на которые хочется забиться в угол и плакать. На самом деле все гораздо проще.

Потратив несколько минут на прочтение этой статьи, вы узнаете, что такое корреляция и как ее использовать в повседневной жизни.

Определение корелляции — что это

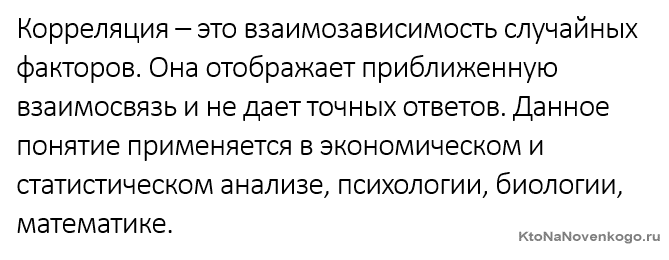

Простыми словами корреляция – это взаимосвязь двух или нескольких случайных параметров. Когда одна величина растет или уменьшается, другая тоже изменяется.

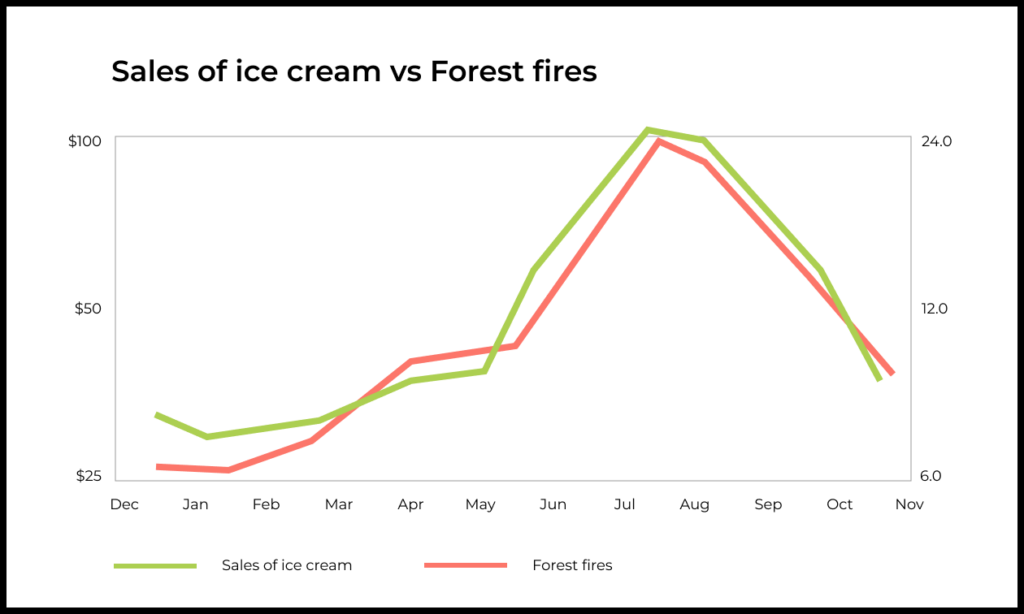

Объясним на примере: существует корреляция между температурой воздуха и потреблением мороженого. Чем жарче погода, тем больше холодного лакомства покупают люди. И наоборот.

Такие закономерности устанавливаются путем исследования больших объемов статистических данных. Собираем информацию о потреблении мороженого за несколько лет и сведения о колебаниях температуры за тот же период. А дальше сопоставляем и ищем зависимость.

Коррелировать – это значит быть взаимосвязанным с чем-то. Существует положительная и отрицательная корреляции.

При положительной чем больше один параметр, тем больше и другой. Например, чем масштабнее траты фермера на удобрения, тем обильнее урожай. При обратной корреляции рост одной величины сопровождается уменьшением другой. Чем выше здание, тем хуже оно противостоит землетрясениям.

Корреляция — это взаимосвязь без гарантий

Рассмотрим пример прямой корреляции: чем выше уровень благосостояния человека, тем больше его продолжительность жизни. Обеспеченные люди питаются качественной пищей и своевременно получают врачебную помощь. В отличие от бедняков.

Однако нельзя с уверенностью сказать, что определенный олигарх проживет дольше вот этого нищего.

Это лишь статистическая вероятность, которая может не сработать для одного конкретного случая. Этим корреляция отличается от линейной зависимости, где исход известен со 100-процентной вероятностью.

Но если мы возьмем выборку из сотни тысяч богачей и такого же числа малоимущих, сравним их продолжительность жизни, то общая тенденция будет верна.

Коэффициент корреляции

Это число, которое обозначается как «r». Оно находится в промежутке от -1 до 1. Отражает силу и полюс взаимосвязи величин. Посмотрим на примере:

| Значение коэффициента | Какая корреляция? | О чем это говорит? |

|---|---|---|

| r=1 | Сильная положительная корреляция | Люди, которые едят чернику, обладают острым зрением. Ешьте чернику! |

| r меньше 0,5 | Слабая положительная корреляция | Некоторые люди, которые любят чернику, обладают острым зрением. Но это не точно. Короче, ничего не пока понятно. Но лучше есть чернику на всякий случай. |

| r=0 | Корреляция отсутствует | Черника и зрение никак не связаны. |

| r меньше -0,5 | Слабая отрицательная корреляция | Бывают случаи ухудшения зрения из-за черники. Не стоит рисковать. |

| r=-1 | Сильная отрицательная корреляция | Практически все, кто ел чернику, ослепли. Берегитесь черники! |

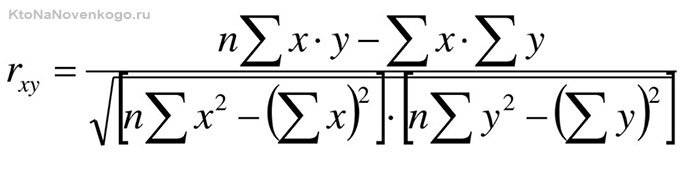

Величина коэффициента корреляции рассчитывается по формуле:

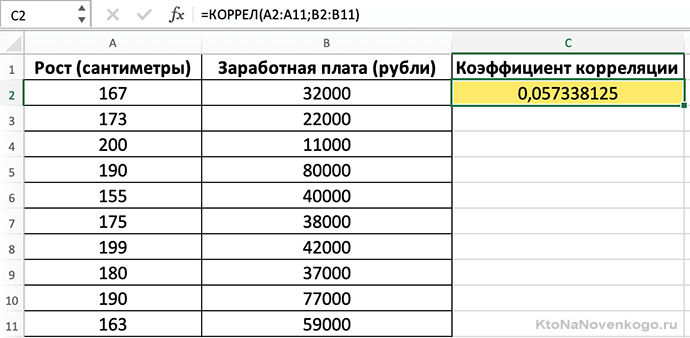

Если внезапно потемнело в глазах и возникло непреодолимое желание закрыть статью (синдром гуманитария), то есть вариант попроще. Microsoft Exel все выполнит сам при помощи функции «КОРРЕЛ». Делается это так:

Судя по расчетам, рост человека практически никак не влияет на уровень зарплаты.

Реальные причины корреляции и возможные гипотезы

Курс доллара и стоимость нефти отрицательно коррелируют. Можем выдвинуть гипотезу: повышение цен на черное золото вызывает падение стоимости американской валюты. Но почему так происходит? Откуда взялась связь между этими явлениями?

Определение причины корреляции – это очень сложная задача. Переплетаются тысячи различных факторов, часть из которых скрыта.

Возможно, дело в том, что США – крупнейший потребитель нефти в мире. Каждый день они импортируют около 7,2 миллиона баррелей. Снижение цены на черное золото – хорошо для американской экономики, ведь позволяет тратить меньше денег. Следовательно, доллар растет.

Корреляция предоставляет возможность сделать вывод из статистических данных.

Например, мы выяснили, что существует отрицательная взаимосвязь между доходом персонала и его эффективностью в работе. Наша гипотеза: «Лентяи и бездельники получают больше, чем ответственные сотрудники». Тогда мы пересмотрим систему мотивации и избавимся от бесполезных людей.

Гипотеза – это лишь статистический вывод, предположение. Она вполне может оказаться ошибочной.

Согласно статистике, чем больше пожарных участвует в тушении огня, тем существенней размер ущерба. Какую гипотезу можем сделать отсюда? Пожарные приносят вред, давайте сократим их! Но если разобраться, то настоящая причина повреждения – это огонь. А увеличение числа лиц, задействованных в его тушении, – следствие масштаба пожара.

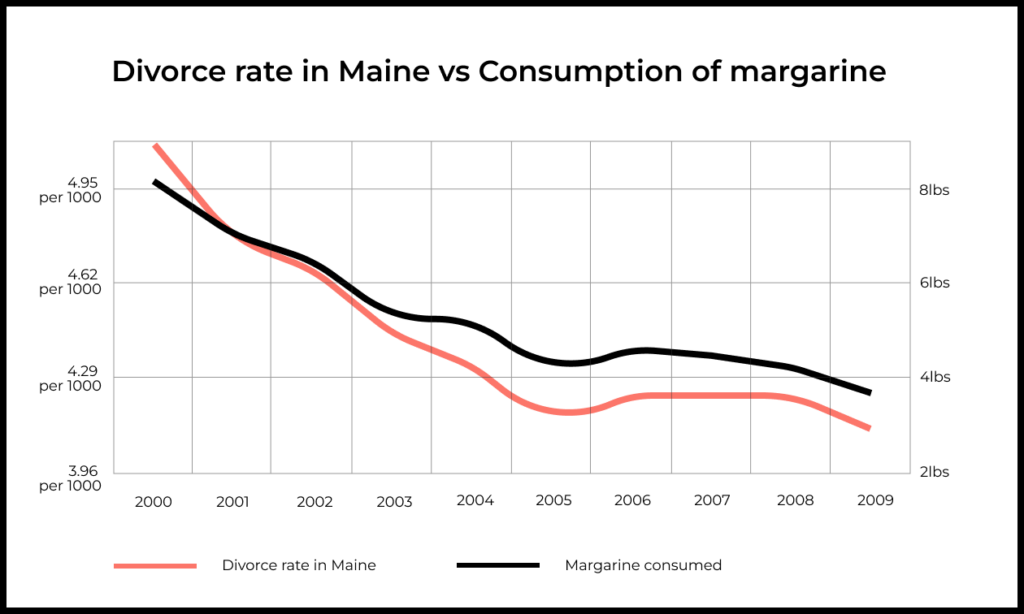

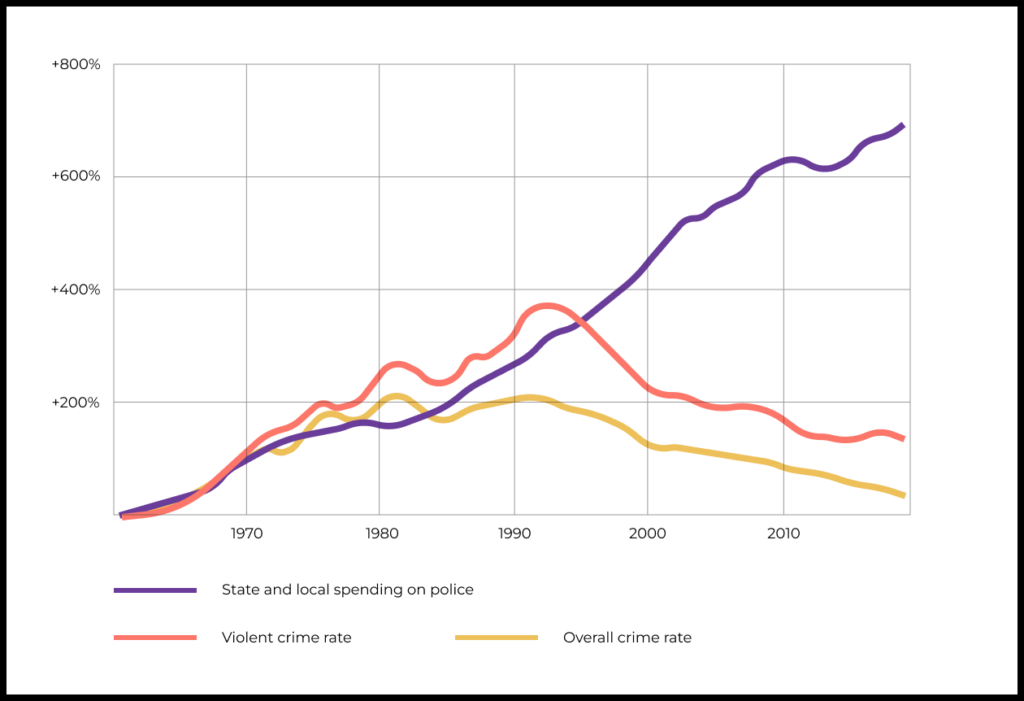

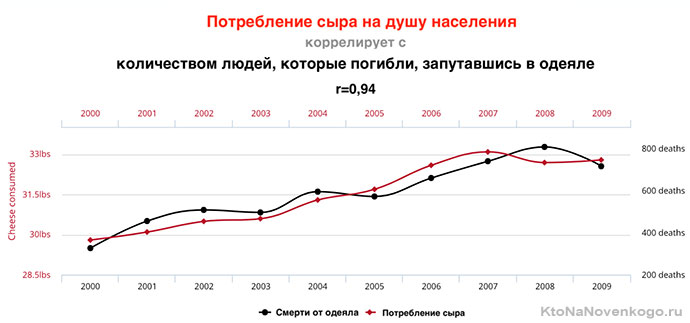

Наша вселенная бесконечна, а значит всегда можно найти несколько переменных, которые будут коррелировать между собой, несмотря на полное отсутствие причинно-следственных связей. Даже самое буйное воображение не сможет объяснить, что объединяет сыр и одеяло-убийцу:

Более подробно на эту тему смотрите в видео:

Как при помощи корреляции люди становятся богаче

Главное правило любого инвестора: не класть все яйца в одну корзину. Вложения рекомендуется диверсифицировать (что это?) – распределять. Поэтому люди покупают акции не одной компании, а десятка разных, формируя инвестиционные портфели. Если котировки какой-то фирмы упадут, то оставшиеся девять смогут отыграть падение или хотя бы уменьшить убытки.

Но это в теории, а на практике все портит корреляция. Проблема в том, что стоимости акций разных компаний внутри отрасли или даже всей страны могут сильно коррелировать. Проблемы огромной корпорации провоцируют панику на рынке, снижают стоимость иных активов, на первый взгляд не связанных между собой. В 2008 году случился крах Lehman Brothers, который вызвал цепную реакцию и обвал на мировых рынках.

Поэтому при инвестировании нужно стараться выбирать направления, которые не связаны между собой (r стремится к 0).

Например, пара «золото – облигации США» = -0,13. Если собрать портфель из совершенно независимых частей, риски финансовых потерь сократятся.

Территориальное приближение активов друг к другу усиливает корреляцию. Значит, нужно рассматривать варианты в разных точках мира, максимально удаленных друг от друга.

В жизни этот принцип тоже действует. Если ваши навыки и знания позволяют трудиться программистом, таксистом, сантехником и журналистом – вы хорошо защищены от риска безработицы.

Памятка

- Корреляция – это соотношение, взаимозависимость нескольких переменных.

- Связь бывает положительной и отрицательной.

- Коэффициент корреляции определяет степень взаимозависимости одной переменной от другой.

- На основании корреляции люди выдвигают гипотезы (часто ошибочные).

- Истинная причина корреляции порою скрыта под множеством факторов и внешних сил.

- Бывает ложная корреляционная зависимость.

- Раскладывая яйца по корзинам, помните о том, что они не должны коррелироваться друг с другом.

This article is about correlation and dependence in statistical data. For other uses, see Correlation (disambiguation).

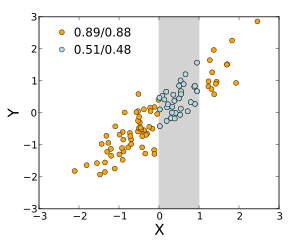

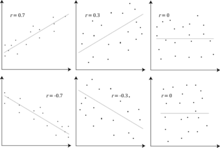

Several sets of (x, y) points, with the Pearson correlation coefficient of x and y for each set. The correlation reflects the noisiness and direction of a linear relationship (top row), but not the slope of that relationship (middle), nor many aspects of nonlinear relationships (bottom). N.B.: the figure in the center has a slope of 0 but in that case, the correlation coefficient is undefined because the variance of Y is zero.

In statistics, correlation or dependence is any statistical relationship, whether causal or not, between two random variables or bivariate data. Although in the broadest sense, «correlation» may indicate any type of association, in statistics it usually refers to the degree to which a pair of variables are linearly related.

Familiar examples of dependent phenomena include the correlation between the height of parents and their offspring, and the correlation between the price of a good and the quantity the consumers are willing to purchase, as it is depicted in the so-called demand curve.

Correlations are useful because they can indicate a predictive relationship that can be exploited in practice. For example, an electrical utility may produce less power on a mild day based on the correlation between electricity demand and weather. In this example, there is a causal relationship, because extreme weather causes people to use more electricity for heating or cooling. However, in general, the presence of a correlation is not sufficient to infer the presence of a causal relationship (i.e., correlation does not imply causation).

Formally, random variables are dependent if they do not satisfy a mathematical property of probabilistic independence. In informal parlance, correlation is synonymous with dependence. However, when used in a technical sense, correlation refers to any of several specific types of mathematical operations between the tested variables and their respective expected values. Essentially, correlation is the measure of how two or more variables are related to one another. There are several correlation coefficients, often denoted

Pearson’s product-moment coefficient[edit]

Example scatterplots of various datasets with various correlation coefficients.

The most familiar measure of dependence between two quantities is the Pearson product-moment correlation coefficient (PPMCC), or «Pearson’s correlation coefficient», commonly called simply «the correlation coefficient». It is obtained by taking the ratio of the covariance of the two variables in question of our numerical dataset, normalized to the square root of their variances. Mathematically, one simply divides the covariance of the two variables by the product of their standard deviations. Karl Pearson developed the coefficient from a similar but slightly different idea by Francis Galton.[4]

A Pearson product-moment correlation coefficient attempts to establish a line of best fit through a dataset of two variables by essentially laying out the expected values and the resulting Pearson’s correlation coefficient indicates how far away the actual dataset is from the expected values. Depending on the sign of our Pearson’s correlation coefficient, we can end up with either a negative or positive correlation if there is any sort of relationship between the variables of our data set.

The population correlation coefficient

where

Correlation and independence[edit]

It is a corollary of the Cauchy–Schwarz inequality that the absolute value of the Pearson correlation coefficient is not bigger than 1. Therefore, the value of a correlation coefficient ranges between −1 and +1. The correlation coefficient is +1 in the case of a perfect direct (increasing) linear relationship (correlation), −1 in the case of a perfect inverse (decreasing) linear relationship (anti-correlation),[5] and some value in the open interval

If the variables are independent, Pearson’s correlation coefficient is 0, but the converse is not true because the correlation coefficient detects only linear dependencies between two variables.

For example, suppose the random variable

Even though uncorrelated data does not necessarily imply independence, one can check if random variables are independent if their mutual information is 0.

Sample correlation coefficient[edit]

Given a series of

where

Equivalent expressions for

where

If

Example[edit]

Consider the joint probability distribution of X and Y given in the table below.

-

y

x

−1 0 1 0 0 1/3 0 1 1/3 0 1/3

For this joint distribution, the marginal distributions are:

This yields the following expectations and variances:

Therefore:

Rank correlation coefficients[edit]

Rank correlation coefficients, such as Spearman’s rank correlation coefficient and Kendall’s rank correlation coefficient (τ) measure the extent to which, as one variable increases, the other variable tends to increase, without requiring that increase to be represented by a linear relationship. If, as the one variable increases, the other decreases, the rank correlation coefficients will be negative. It is common to regard these rank correlation coefficients as alternatives to Pearson’s coefficient, used either to reduce the amount of calculation or to make the coefficient less sensitive to non-normality in distributions. However, this view has little mathematical basis, as rank correlation coefficients measure a different type of relationship than the Pearson product-moment correlation coefficient, and are best seen as measures of a different type of association, rather than as an alternative measure of the population correlation coefficient.[7][8]

To illustrate the nature of rank correlation, and its difference from linear correlation, consider the following four pairs of numbers

- (0, 1), (10, 100), (101, 500), (102, 2000).

As we go from each pair to the next pair

Other measures of dependence among random variables[edit]

The information given by a correlation coefficient is not enough to define the dependence structure between random variables.[9] The correlation coefficient completely defines the dependence structure only in very particular cases, for example when the distribution is a multivariate normal distribution. (See diagram above.) In the case of elliptical distributions it characterizes the (hyper-)ellipses of equal density; however, it does not completely characterize the dependence structure (for example, a multivariate t-distribution’s degrees of freedom determine the level of tail dependence).

Distance correlation[10][11] was introduced to address the deficiency of Pearson’s correlation that it can be zero for dependent random variables; zero distance correlation implies independence.

The Randomized Dependence Coefficient[12] is a computationally efficient, copula-based measure of dependence between multivariate random variables. RDC is invariant with respect to non-linear scalings of random variables, is capable of discovering a wide range of functional association patterns and takes value zero at independence.

For two binary variables, the odds ratio measures their dependence, and takes range non-negative numbers, possibly infinity: ![{displaystyle [0,+infty ]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f32245981f739c86ea8f68ce89b1ad6807428d35)

![[-1, 1]](https://wikimedia.org/api/rest_v1/media/math/render/svg/51e3b7f14a6f70e614728c583409a0b9a8b9de01)

The correlation ratio, entropy-based mutual information, total correlation, dual total correlation and polychoric correlation are all also capable of detecting more general dependencies, as is consideration of the copula between them, while the coefficient of determination generalizes the correlation coefficient to multiple regression.

Sensitivity to the data distribution[edit]

The degree of dependence between variables X and Y does not depend on the scale on which the variables are expressed. That is, if we are analyzing the relationship between X and Y, most correlation measures are unaffected by transforming X to a + bX and Y to c + dY, where a, b, c, and d are constants (b and d being positive). This is true of some correlation statistics as well as their population analogues. Some correlation statistics, such as the rank correlation coefficient, are also invariant to monotone transformations of the marginal distributions of X and/or Y.

Pearson/Spearman correlation coefficients between X and Y are shown when the two variables’ ranges are unrestricted, and when the range of X is restricted to the interval (0,1).

Most correlation measures are sensitive to the manner in which X and Y are sampled. Dependencies tend to be stronger if viewed over a wider range of values. Thus, if we consider the correlation coefficient between the heights of fathers and their sons over all adult males, and compare it to the same correlation coefficient calculated when the fathers are selected to be between 165 cm and 170 cm in height, the correlation will be weaker in the latter case. Several techniques have been developed that attempt to correct for range restriction in one or both variables, and are commonly used in meta-analysis; the most common are Thorndike’s case II and case III equations.[13]

Various correlation measures in use may be undefined for certain joint distributions of X and Y. For example, the Pearson correlation coefficient is defined in terms of moments, and hence will be undefined if the moments are undefined. Measures of dependence based on quantiles are always defined. Sample-based statistics intended to estimate population measures of dependence may or may not have desirable statistical properties such as being unbiased, or asymptotically consistent, based on the spatial structure of the population from which the data were sampled.

Sensitivity to the data distribution can be used to an advantage. For example, scaled correlation is designed to use the sensitivity to the range in order to pick out correlations between fast components of time series.[14] By reducing the range of values in a controlled manner, the correlations on long time scale are filtered out and only the correlations on short time scales are revealed.

Correlation matrices[edit]

The correlation matrix of

Thus the diagonal entries are all identically one. If the measures of correlation used are product-moment coefficients, the correlation matrix is the same as the covariance matrix of the standardized random variables

The correlation matrix is symmetric because the correlation between

A correlation matrix appears, for example, in one formula for the coefficient of multiple determination, a measure of goodness of fit in multiple regression.

In statistical modelling, correlation matrices representing the relationships between variables are categorized into different correlation structures, which are distinguished by factors such as the number of parameters required to estimate them. For example, in an exchangeable correlation matrix, all pairs of variables are modeled as having the same correlation, so all non-diagonal elements of the matrix are equal to each other. On the other hand, an autoregressive matrix is often used when variables represent a time series, since correlations are likely to be greater when measurements are closer in time. Other examples include independent, unstructured, M-dependent, and Toeplitz.

In exploratory data analysis, the iconography of correlations consists in replacing a correlation matrix by a diagram where the “remarkable” correlations are represented by a solid line (positive correlation), or a dotted line (negative correlation).

Nearest valid correlation matrix[edit]

In some applications (e.g., building data models from only partially observed data) one wants to find the «nearest» correlation matrix to an «approximate» correlation matrix (e.g., a matrix which typically lacks semi-definite positiveness due to the way it has been computed).

In 2002, Higham[15] formalized the notion of nearness using the Frobenius norm and provided a method for computing the nearest correlation matrix using the Dykstra’s projection algorithm, of which an implementation is available as an online Web API.[16]

This sparked interest in the subject, with new theoretical (e.g., computing the nearest correlation matrix with factor structure[17]) and numerical (e.g. usage the Newton’s method for computing the nearest correlation matrix[18]) results obtained in the subsequent years.

Uncorrelatedness and independence of stochastic processes[edit]

Similarly for two stochastic processes

Common misconceptions[edit]

Correlation and causality[edit]

The conventional dictum that «correlation does not imply causation» means that correlation cannot be used by itself to infer a causal relationship between the variables.[20] This dictum should not be taken to mean that correlations cannot indicate the potential existence of causal relations. However, the causes underlying the correlation, if any, may be indirect and unknown, and high correlations also overlap with identity relations (tautologies), where no causal process exists. Consequently, a correlation between two variables is not a sufficient condition to establish a causal relationship (in either direction).

A correlation between age and height in children is fairly causally transparent, but a correlation between mood and health in people is less so. Does improved mood lead to improved health, or does good health lead to good mood, or both? Or does some other factor underlie both? In other words, a correlation can be taken as evidence for a possible causal relationship, but cannot indicate what the causal relationship, if any, might be.

Simple linear correlations[edit]

The Pearson correlation coefficient indicates the strength of a linear relationship between two variables, but its value generally does not completely characterize their relationship.[21] In particular, if the conditional mean of

The adjacent image shows scatter plots of Anscombe’s quartet, a set of four different pairs of variables created by Francis Anscombe.[22] The four

These examples indicate that the correlation coefficient, as a summary statistic, cannot replace visual examination of the data. The examples are sometimes said to demonstrate that the Pearson correlation assumes that the data follow a normal distribution, but this is only partially correct.[4] The Pearson correlation can be accurately calculated for any distribution that has a finite covariance matrix, which includes most distributions encountered in practice. However, the Pearson correlation coefficient (taken together with the sample mean and variance) is only a sufficient statistic if the data is drawn from a multivariate normal distribution. As a result, the Pearson correlation coefficient fully characterizes the relationship between variables if and only if the data are drawn from a multivariate normal distribution.

Bivariate normal distribution[edit]

If a pair

where

The empirical correlation

where

See also[edit]

- Autocorrelation

- Canonical correlation

- Coefficient of determination

- Cointegration

- Concordance correlation coefficient

- Cophenetic correlation

- Correlation function

- Correlation gap

- Covariance

- Covariance and correlation

- Cross-correlation

- Ecological correlation

- Fraction of variance unexplained

- Genetic correlation

- Goodman and Kruskal’s lambda

- Iconography of correlations

- Illusory correlation

- Interclass correlation

- Intraclass correlation

- Lift (data mining)

- Mean dependence

- Modifiable areal unit problem

- Multiple correlation

- Point-biserial correlation coefficient

- Quadrant count ratio

- Spurious correlation

- Statistical arbitrage

- Subindependence

References[edit]

- ^ Croxton, Frederick Emory; Cowden, Dudley Johnstone; Klein, Sidney (1968) Applied General Statistics, Pitman. ISBN 9780273403159 (page 625)

- ^ Dietrich, Cornelius Frank (1991) Uncertainty, Calibration and Probability: The Statistics of Scientific and Industrial Measurement 2nd Edition, A. Higler. ISBN 9780750300605 (Page 331)

- ^ Aitken, Alexander Craig (1957) Statistical Mathematics 8th Edition. Oliver & Boyd. ISBN 9780050013007 (Page 95)

- ^ a b Rodgers, J. L.; Nicewander, W. A. (1988). «Thirteen ways to look at the correlation coefficient». The American Statistician. 42 (1): 59–66. doi:10.1080/00031305.1988.10475524. JSTOR 2685263.

- ^ Dowdy, S. and Wearden, S. (1983). «Statistics for Research», Wiley. ISBN 0-471-08602-9 pp 230

- ^ Francis, DP; Coats AJ; Gibson D (1999). «How high can a correlation coefficient be?». Int J Cardiol. 69 (2): 185–199. doi:10.1016/S0167-5273(99)00028-5. PMID 10549842.

- ^ a b Yule, G.U and Kendall, M.G. (1950), «An Introduction to the Theory of Statistics», 14th Edition (5th Impression 1968). Charles Griffin & Co. pp 258–270

- ^ Kendall, M. G. (1955) «Rank Correlation Methods», Charles Griffin & Co.

- ^ Mahdavi Damghani B. (2013). «The Non-Misleading Value of Inferred Correlation: An Introduction to the Cointelation Model». Wilmott Magazine. 2013 (67): 50–61. doi:10.1002/wilm.10252.

- ^ Székely, G. J. Rizzo; Bakirov, N. K. (2007). «Measuring and testing independence by correlation of distances». Annals of Statistics. 35 (6): 2769–2794. arXiv:0803.4101. doi:10.1214/009053607000000505. S2CID 5661488.

- ^ Székely, G. J.; Rizzo, M. L. (2009). «Brownian distance covariance». Annals of Applied Statistics. 3 (4): 1233–1303. arXiv:1010.0297. doi:10.1214/09-AOAS312. PMC 2889501. PMID 20574547.

- ^ Lopez-Paz D. and Hennig P. and Schölkopf B. (2013). «The Randomized Dependence Coefficient», «Conference on Neural Information Processing Systems» Reprint

- ^ Thorndike, Robert Ladd (1947). Research problems and techniques (Report No. 3). Washington DC: US Govt. print. off.

- ^ Nikolić, D; Muresan, RC; Feng, W; Singer, W (2012). «Scaled correlation analysis: a better way to compute a cross-correlogram». European Journal of Neuroscience. 35 (5): 1–21. doi:10.1111/j.1460-9568.2011.07987.x. PMID 22324876. S2CID 4694570.

- ^ Higham, Nicholas J. (2002). «Computing the nearest correlation matrix—a problem from finance». IMA Journal of Numerical Analysis. 22 (3): 329–343. CiteSeerX 10.1.1.661.2180. doi:10.1093/imanum/22.3.329.

- ^ «Portfolio Optimizer». portfoliooptimizer.io/. Retrieved 2021-01-30.

- ^ Borsdorf, Rudiger; Higham, Nicholas J.; Raydan, Marcos (2010). «Computing a Nearest Correlation Matrix with Factor Structure» (PDF). SIAM J. Matrix Anal. Appl. 31 (5): 2603–2622. doi:10.1137/090776718.

- ^ Qi, HOUDUO; Sun, DEFENG (2006). «A quadratically convergent Newton method for computing the nearest correlation matrix». SIAM J. Matrix Anal. Appl. 28 (2): 360–385. doi:10.1137/050624509.

- ^ Park, Kun Il (2018). Fundamentals of Probability and Stochastic Processes with Applications to Communications. Springer. ISBN 978-3-319-68074-3.

- ^ Aldrich, John (1995). «Correlations Genuine and Spurious in Pearson and Yule». Statistical Science. 10 (4): 364–376. doi:10.1214/ss/1177009870. JSTOR 2246135.

- ^ Mahdavi Damghani, Babak (2012). «The Misleading Value of Measured Correlation». Wilmott Magazine. 2012 (1): 64–73. doi:10.1002/wilm.10167. S2CID 154550363.

- ^ Anscombe, Francis J. (1973). «Graphs in statistical analysis». The American Statistician. 27 (1): 17–21. doi:10.2307/2682899. JSTOR 2682899.

- ^ Taraldsen, Gunnar (2021). «The Confidence Density for Correlation». Sankhya A. doi:10.1007/s13171-021-00267-y. ISSN 0976-8378. S2CID 244594067.

- ^ Taraldsen, Gunnar (2020). «Confidence in Correlation». doi:10.13140/RG.2.2.23673.49769.

Further reading[edit]

- Cohen, J.; Cohen P.; West, S.G. & Aiken, L.S. (2002). Applied multiple regression/correlation analysis for the behavioral sciences (3rd ed.). Psychology Press. ISBN 978-0-8058-2223-6.

- «Correlation (in statistics)», Encyclopedia of Mathematics, EMS Press, 2001 [1994]

- Oestreicher, J. & D. R. (February 26, 2015). Plague of Equals: A science thriller of international disease, politics and drug discovery. California: Omega Cat Press. p. 408. ISBN 978-0963175540.

External links[edit]

- MathWorld page on the (cross-)correlation coefficient/s of a sample

- Compute significance between two correlations, for the comparison of two correlation values.

- «A MATLAB Toolbox for computing Weighted Correlation Coefficients». Archived from the original on 24 April 2021.

- Proof that the Sample Bivariate Correlation has limits plus or minus 1

- Interactive Flash simulation on the correlation of two normally distributed variables by Juha Puranen.

- Correlation analysis. Biomedical Statistics

- R-Psychologist Correlation visualization of correlation between two numeric variables

This article is about correlation and dependence in statistical data. For other uses, see Correlation (disambiguation).

Several sets of (x, y) points, with the Pearson correlation coefficient of x and y for each set. The correlation reflects the noisiness and direction of a linear relationship (top row), but not the slope of that relationship (middle), nor many aspects of nonlinear relationships (bottom). N.B.: the figure in the center has a slope of 0 but in that case, the correlation coefficient is undefined because the variance of Y is zero.

In statistics, correlation or dependence is any statistical relationship, whether causal or not, between two random variables or bivariate data. Although in the broadest sense, «correlation» may indicate any type of association, in statistics it usually refers to the degree to which a pair of variables are linearly related.

Familiar examples of dependent phenomena include the correlation between the height of parents and their offspring, and the correlation between the price of a good and the quantity the consumers are willing to purchase, as it is depicted in the so-called demand curve.

Correlations are useful because they can indicate a predictive relationship that can be exploited in practice. For example, an electrical utility may produce less power on a mild day based on the correlation between electricity demand and weather. In this example, there is a causal relationship, because extreme weather causes people to use more electricity for heating or cooling. However, in general, the presence of a correlation is not sufficient to infer the presence of a causal relationship (i.e., correlation does not imply causation).

Formally, random variables are dependent if they do not satisfy a mathematical property of probabilistic independence. In informal parlance, correlation is synonymous with dependence. However, when used in a technical sense, correlation refers to any of several specific types of mathematical operations between the tested variables and their respective expected values. Essentially, correlation is the measure of how two or more variables are related to one another. There are several correlation coefficients, often denoted

Pearson’s product-moment coefficient[edit]

Example scatterplots of various datasets with various correlation coefficients.

The most familiar measure of dependence between two quantities is the Pearson product-moment correlation coefficient (PPMCC), or «Pearson’s correlation coefficient», commonly called simply «the correlation coefficient». It is obtained by taking the ratio of the covariance of the two variables in question of our numerical dataset, normalized to the square root of their variances. Mathematically, one simply divides the covariance of the two variables by the product of their standard deviations. Karl Pearson developed the coefficient from a similar but slightly different idea by Francis Galton.[4]

A Pearson product-moment correlation coefficient attempts to establish a line of best fit through a dataset of two variables by essentially laying out the expected values and the resulting Pearson’s correlation coefficient indicates how far away the actual dataset is from the expected values. Depending on the sign of our Pearson’s correlation coefficient, we can end up with either a negative or positive correlation if there is any sort of relationship between the variables of our data set.

The population correlation coefficient

where

Correlation and independence[edit]

It is a corollary of the Cauchy–Schwarz inequality that the absolute value of the Pearson correlation coefficient is not bigger than 1. Therefore, the value of a correlation coefficient ranges between −1 and +1. The correlation coefficient is +1 in the case of a perfect direct (increasing) linear relationship (correlation), −1 in the case of a perfect inverse (decreasing) linear relationship (anti-correlation),[5] and some value in the open interval

If the variables are independent, Pearson’s correlation coefficient is 0, but the converse is not true because the correlation coefficient detects only linear dependencies between two variables.

For example, suppose the random variable

Even though uncorrelated data does not necessarily imply independence, one can check if random variables are independent if their mutual information is 0.

Sample correlation coefficient[edit]

Given a series of

where

Equivalent expressions for

where

If

Example[edit]

Consider the joint probability distribution of X and Y given in the table below.

-

y

x

−1 0 1 0 0 1/3 0 1 1/3 0 1/3

For this joint distribution, the marginal distributions are:

This yields the following expectations and variances:

Therefore:

Rank correlation coefficients[edit]

Rank correlation coefficients, such as Spearman’s rank correlation coefficient and Kendall’s rank correlation coefficient (τ) measure the extent to which, as one variable increases, the other variable tends to increase, without requiring that increase to be represented by a linear relationship. If, as the one variable increases, the other decreases, the rank correlation coefficients will be negative. It is common to regard these rank correlation coefficients as alternatives to Pearson’s coefficient, used either to reduce the amount of calculation or to make the coefficient less sensitive to non-normality in distributions. However, this view has little mathematical basis, as rank correlation coefficients measure a different type of relationship than the Pearson product-moment correlation coefficient, and are best seen as measures of a different type of association, rather than as an alternative measure of the population correlation coefficient.[7][8]

To illustrate the nature of rank correlation, and its difference from linear correlation, consider the following four pairs of numbers

- (0, 1), (10, 100), (101, 500), (102, 2000).

As we go from each pair to the next pair

Other measures of dependence among random variables[edit]

The information given by a correlation coefficient is not enough to define the dependence structure between random variables.[9] The correlation coefficient completely defines the dependence structure only in very particular cases, for example when the distribution is a multivariate normal distribution. (See diagram above.) In the case of elliptical distributions it characterizes the (hyper-)ellipses of equal density; however, it does not completely characterize the dependence structure (for example, a multivariate t-distribution’s degrees of freedom determine the level of tail dependence).

Distance correlation[10][11] was introduced to address the deficiency of Pearson’s correlation that it can be zero for dependent random variables; zero distance correlation implies independence.

The Randomized Dependence Coefficient[12] is a computationally efficient, copula-based measure of dependence between multivariate random variables. RDC is invariant with respect to non-linear scalings of random variables, is capable of discovering a wide range of functional association patterns and takes value zero at independence.

For two binary variables, the odds ratio measures their dependence, and takes range non-negative numbers, possibly infinity: ![{displaystyle [0,+infty ]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f32245981f739c86ea8f68ce89b1ad6807428d35)

![[-1, 1]](https://wikimedia.org/api/rest_v1/media/math/render/svg/51e3b7f14a6f70e614728c583409a0b9a8b9de01)

The correlation ratio, entropy-based mutual information, total correlation, dual total correlation and polychoric correlation are all also capable of detecting more general dependencies, as is consideration of the copula between them, while the coefficient of determination generalizes the correlation coefficient to multiple regression.

Sensitivity to the data distribution[edit]

The degree of dependence between variables X and Y does not depend on the scale on which the variables are expressed. That is, if we are analyzing the relationship between X and Y, most correlation measures are unaffected by transforming X to a + bX and Y to c + dY, where a, b, c, and d are constants (b and d being positive). This is true of some correlation statistics as well as their population analogues. Some correlation statistics, such as the rank correlation coefficient, are also invariant to monotone transformations of the marginal distributions of X and/or Y.

Pearson/Spearman correlation coefficients between X and Y are shown when the two variables’ ranges are unrestricted, and when the range of X is restricted to the interval (0,1).

Most correlation measures are sensitive to the manner in which X and Y are sampled. Dependencies tend to be stronger if viewed over a wider range of values. Thus, if we consider the correlation coefficient between the heights of fathers and their sons over all adult males, and compare it to the same correlation coefficient calculated when the fathers are selected to be between 165 cm and 170 cm in height, the correlation will be weaker in the latter case. Several techniques have been developed that attempt to correct for range restriction in one or both variables, and are commonly used in meta-analysis; the most common are Thorndike’s case II and case III equations.[13]

Various correlation measures in use may be undefined for certain joint distributions of X and Y. For example, the Pearson correlation coefficient is defined in terms of moments, and hence will be undefined if the moments are undefined. Measures of dependence based on quantiles are always defined. Sample-based statistics intended to estimate population measures of dependence may or may not have desirable statistical properties such as being unbiased, or asymptotically consistent, based on the spatial structure of the population from which the data were sampled.

Sensitivity to the data distribution can be used to an advantage. For example, scaled correlation is designed to use the sensitivity to the range in order to pick out correlations between fast components of time series.[14] By reducing the range of values in a controlled manner, the correlations on long time scale are filtered out and only the correlations on short time scales are revealed.

Correlation matrices[edit]

The correlation matrix of

Thus the diagonal entries are all identically one. If the measures of correlation used are product-moment coefficients, the correlation matrix is the same as the covariance matrix of the standardized random variables

The correlation matrix is symmetric because the correlation between

A correlation matrix appears, for example, in one formula for the coefficient of multiple determination, a measure of goodness of fit in multiple regression.

In statistical modelling, correlation matrices representing the relationships between variables are categorized into different correlation structures, which are distinguished by factors such as the number of parameters required to estimate them. For example, in an exchangeable correlation matrix, all pairs of variables are modeled as having the same correlation, so all non-diagonal elements of the matrix are equal to each other. On the other hand, an autoregressive matrix is often used when variables represent a time series, since correlations are likely to be greater when measurements are closer in time. Other examples include independent, unstructured, M-dependent, and Toeplitz.

In exploratory data analysis, the iconography of correlations consists in replacing a correlation matrix by a diagram where the “remarkable” correlations are represented by a solid line (positive correlation), or a dotted line (negative correlation).

Nearest valid correlation matrix[edit]

In some applications (e.g., building data models from only partially observed data) one wants to find the «nearest» correlation matrix to an «approximate» correlation matrix (e.g., a matrix which typically lacks semi-definite positiveness due to the way it has been computed).

In 2002, Higham[15] formalized the notion of nearness using the Frobenius norm and provided a method for computing the nearest correlation matrix using the Dykstra’s projection algorithm, of which an implementation is available as an online Web API.[16]

This sparked interest in the subject, with new theoretical (e.g., computing the nearest correlation matrix with factor structure[17]) and numerical (e.g. usage the Newton’s method for computing the nearest correlation matrix[18]) results obtained in the subsequent years.

Uncorrelatedness and independence of stochastic processes[edit]

Similarly for two stochastic processes

Common misconceptions[edit]

Correlation and causality[edit]

The conventional dictum that «correlation does not imply causation» means that correlation cannot be used by itself to infer a causal relationship between the variables.[20] This dictum should not be taken to mean that correlations cannot indicate the potential existence of causal relations. However, the causes underlying the correlation, if any, may be indirect and unknown, and high correlations also overlap with identity relations (tautologies), where no causal process exists. Consequently, a correlation between two variables is not a sufficient condition to establish a causal relationship (in either direction).

A correlation between age and height in children is fairly causally transparent, but a correlation between mood and health in people is less so. Does improved mood lead to improved health, or does good health lead to good mood, or both? Or does some other factor underlie both? In other words, a correlation can be taken as evidence for a possible causal relationship, but cannot indicate what the causal relationship, if any, might be.

Simple linear correlations[edit]

The Pearson correlation coefficient indicates the strength of a linear relationship between two variables, but its value generally does not completely characterize their relationship.[21] In particular, if the conditional mean of

The adjacent image shows scatter plots of Anscombe’s quartet, a set of four different pairs of variables created by Francis Anscombe.[22] The four

These examples indicate that the correlation coefficient, as a summary statistic, cannot replace visual examination of the data. The examples are sometimes said to demonstrate that the Pearson correlation assumes that the data follow a normal distribution, but this is only partially correct.[4] The Pearson correlation can be accurately calculated for any distribution that has a finite covariance matrix, which includes most distributions encountered in practice. However, the Pearson correlation coefficient (taken together with the sample mean and variance) is only a sufficient statistic if the data is drawn from a multivariate normal distribution. As a result, the Pearson correlation coefficient fully characterizes the relationship between variables if and only if the data are drawn from a multivariate normal distribution.

Bivariate normal distribution[edit]

If a pair

where

The empirical correlation

where

See also[edit]

- Autocorrelation

- Canonical correlation

- Coefficient of determination

- Cointegration

- Concordance correlation coefficient

- Cophenetic correlation

- Correlation function

- Correlation gap

- Covariance

- Covariance and correlation

- Cross-correlation

- Ecological correlation

- Fraction of variance unexplained

- Genetic correlation

- Goodman and Kruskal’s lambda

- Iconography of correlations

- Illusory correlation

- Interclass correlation

- Intraclass correlation

- Lift (data mining)

- Mean dependence

- Modifiable areal unit problem

- Multiple correlation

- Point-biserial correlation coefficient

- Quadrant count ratio

- Spurious correlation

- Statistical arbitrage

- Subindependence

References[edit]

- ^ Croxton, Frederick Emory; Cowden, Dudley Johnstone; Klein, Sidney (1968) Applied General Statistics, Pitman. ISBN 9780273403159 (page 625)

- ^ Dietrich, Cornelius Frank (1991) Uncertainty, Calibration and Probability: The Statistics of Scientific and Industrial Measurement 2nd Edition, A. Higler. ISBN 9780750300605 (Page 331)

- ^ Aitken, Alexander Craig (1957) Statistical Mathematics 8th Edition. Oliver & Boyd. ISBN 9780050013007 (Page 95)

- ^ a b Rodgers, J. L.; Nicewander, W. A. (1988). «Thirteen ways to look at the correlation coefficient». The American Statistician. 42 (1): 59–66. doi:10.1080/00031305.1988.10475524. JSTOR 2685263.

- ^ Dowdy, S. and Wearden, S. (1983). «Statistics for Research», Wiley. ISBN 0-471-08602-9 pp 230

- ^ Francis, DP; Coats AJ; Gibson D (1999). «How high can a correlation coefficient be?». Int J Cardiol. 69 (2): 185–199. doi:10.1016/S0167-5273(99)00028-5. PMID 10549842.

- ^ a b Yule, G.U and Kendall, M.G. (1950), «An Introduction to the Theory of Statistics», 14th Edition (5th Impression 1968). Charles Griffin & Co. pp 258–270

- ^ Kendall, M. G. (1955) «Rank Correlation Methods», Charles Griffin & Co.

- ^ Mahdavi Damghani B. (2013). «The Non-Misleading Value of Inferred Correlation: An Introduction to the Cointelation Model». Wilmott Magazine. 2013 (67): 50–61. doi:10.1002/wilm.10252.

- ^ Székely, G. J. Rizzo; Bakirov, N. K. (2007). «Measuring and testing independence by correlation of distances». Annals of Statistics. 35 (6): 2769–2794. arXiv:0803.4101. doi:10.1214/009053607000000505. S2CID 5661488.

- ^ Székely, G. J.; Rizzo, M. L. (2009). «Brownian distance covariance». Annals of Applied Statistics. 3 (4): 1233–1303. arXiv:1010.0297. doi:10.1214/09-AOAS312. PMC 2889501. PMID 20574547.

- ^ Lopez-Paz D. and Hennig P. and Schölkopf B. (2013). «The Randomized Dependence Coefficient», «Conference on Neural Information Processing Systems» Reprint

- ^ Thorndike, Robert Ladd (1947). Research problems and techniques (Report No. 3). Washington DC: US Govt. print. off.

- ^ Nikolić, D; Muresan, RC; Feng, W; Singer, W (2012). «Scaled correlation analysis: a better way to compute a cross-correlogram». European Journal of Neuroscience. 35 (5): 1–21. doi:10.1111/j.1460-9568.2011.07987.x. PMID 22324876. S2CID 4694570.

- ^ Higham, Nicholas J. (2002). «Computing the nearest correlation matrix—a problem from finance». IMA Journal of Numerical Analysis. 22 (3): 329–343. CiteSeerX 10.1.1.661.2180. doi:10.1093/imanum/22.3.329.

- ^ «Portfolio Optimizer». portfoliooptimizer.io/. Retrieved 2021-01-30.

- ^ Borsdorf, Rudiger; Higham, Nicholas J.; Raydan, Marcos (2010). «Computing a Nearest Correlation Matrix with Factor Structure» (PDF). SIAM J. Matrix Anal. Appl. 31 (5): 2603–2622. doi:10.1137/090776718.

- ^ Qi, HOUDUO; Sun, DEFENG (2006). «A quadratically convergent Newton method for computing the nearest correlation matrix». SIAM J. Matrix Anal. Appl. 28 (2): 360–385. doi:10.1137/050624509.

- ^ Park, Kun Il (2018). Fundamentals of Probability and Stochastic Processes with Applications to Communications. Springer. ISBN 978-3-319-68074-3.

- ^ Aldrich, John (1995). «Correlations Genuine and Spurious in Pearson and Yule». Statistical Science. 10 (4): 364–376. doi:10.1214/ss/1177009870. JSTOR 2246135.

- ^ Mahdavi Damghani, Babak (2012). «The Misleading Value of Measured Correlation». Wilmott Magazine. 2012 (1): 64–73. doi:10.1002/wilm.10167. S2CID 154550363.

- ^ Anscombe, Francis J. (1973). «Graphs in statistical analysis». The American Statistician. 27 (1): 17–21. doi:10.2307/2682899. JSTOR 2682899.

- ^ Taraldsen, Gunnar (2021). «The Confidence Density for Correlation». Sankhya A. doi:10.1007/s13171-021-00267-y. ISSN 0976-8378. S2CID 244594067.

- ^ Taraldsen, Gunnar (2020). «Confidence in Correlation». doi:10.13140/RG.2.2.23673.49769.

Further reading[edit]

- Cohen, J.; Cohen P.; West, S.G. & Aiken, L.S. (2002). Applied multiple regression/correlation analysis for the behavioral sciences (3rd ed.). Psychology Press. ISBN 978-0-8058-2223-6.

- «Correlation (in statistics)», Encyclopedia of Mathematics, EMS Press, 2001 [1994]

- Oestreicher, J. & D. R. (February 26, 2015). Plague of Equals: A science thriller of international disease, politics and drug discovery. California: Omega Cat Press. p. 408. ISBN 978-0963175540.

External links[edit]

- MathWorld page on the (cross-)correlation coefficient/s of a sample

- Compute significance between two correlations, for the comparison of two correlation values.

- «A MATLAB Toolbox for computing Weighted Correlation Coefficients». Archived from the original on 24 April 2021.

- Proof that the Sample Bivariate Correlation has limits plus or minus 1

- Interactive Flash simulation on the correlation of two normally distributed variables by Juha Puranen.

- Correlation analysis. Biomedical Statistics

- R-Psychologist Correlation visualization of correlation between two numeric variables

Если вы где-то читаете фразу вида «оказалось, что у данных событий корреляция вот такая вот», то примерно в 99,99% случаев, если прямо не оговорено иного, речь идёт о коэффициенте корреляции Пирсона. «Дефолт-корреляция» — это он.

Причём пользуются им далеко не только безграмотные журналисты, но и в целом довольно грамотные учёные. Что, на мой взгляд, весьма странно, ибо область его осмысленного применения сильно уже, чем область его фактического использования.

По этой причине мне хотелось бы рассказать, какими способами при помощи «дефолт-корреляции» можно сделать множество совершенно неправильных, однако весьма наукообразных и кажущихся весьма правдоподобными выводов.

Но для начала о том…

Что такое «коэффициент корреляции Пирсона»?

Вполне понятно, что для несведущих это — особая научная магия, однако довольно обидно, что для многих сведущих дела обстоят аналогично. «Я же биолог, а не математик — зачем мне лезть в эти тонкости?» — обычное дело.

Положим, у нас есть некие два предполагаемых процесса, для каждого из которых мы замеряем какой-то параметр, обычно называемый в данном случае «величиной». В результате у нас появляется набор пар чисел.

Предполагая заодно, что эти процессы не только существуют, но и как-то связаны, мы предполагаем же, что эта связь должна численно проявиться в сделанных нами измерениях. То есть из полученных пар чисел мы каким-то образом можем получить сведения о наличии или отсутствии связи.

Однако связи бывают разной степени жёсткости, поэтому желательно получать не бинарное «да» или «нет», а что-то типа непрерывной по пространству состояний оценки «силы связи».

И вот, встречайте, коэффициент корреляции Пирсона.

Я понимаю, что на этом месте очень многие испугались, что и дальше всё будет столь же непонятным. Какие-то страшные буковки в страшных комбинациях, всё такое.

Признаться, я тоже не особо-то люблю математический вариант записи. Мне «программистский» кажется гораздо более понятным. Поэтому я попытаюсь следовать именно ему.

Есть такое понятие «математическое ожидание величины», для краткости называемое «матожиданием». В простейшем случае его смысл крайне прост: это среднее арифметическое от всех полученных значений.

Получили мы какой-то набор измерений, представленный тут в виде списка

Потом мы просуммировали их все, поделили на количество чисел в этом списке — и вот оно, среднее арифметическое.

Далее мы найдём для каждого числа из списка его отклонение от матожидания.

…и получим, таким образом, список отклонений. Список отклонений каждого из значений от среднего арифметического по всему этому списку.

То же самое можно проделать и с другим списком, в котором находятся измерения второго параметра, измеренного одновременно с первым.

Например, мы у каждого пациента в палате померили температуру. И, кроме того, зафиксировали, сколько таблеток аспирина он сегодня принял. И теперь по вышеуказанной процедуре построим список отклонений температуры каждого пациента от средней температуры пациентов и соответствующий ему список отклонений количества принятых пациентом таблеток аспирина от среднего принятого их количества.

Да, тут уже и так есть суровые подозрения о множестве натяжек, но мы всё-таки не остановимся и предположим, что если температура как-то связана с приёмом аспирина, то должны быть связаны между собой и эти самые отклонения.

Например, если приём аспирина приводит к росту температуры, то мы будем видеть следующее.

Если пациент выпил больше таблеток, чем другие, то его температура отклоняется от средней в бо́льшую сторону.

Если пациент выпил меньше таблеток, чем другие, то его температура отклоняется от средней в меньшую сторону.

То есть оба отклонения — в одну и ту же сторону.

Если мы перемножим попарно все отклонения, то все произведения будут положительными.

И наоборот: если приём аспирина понижает температуру, то все произведения отклонений будут отрицательными.

Иными словами, у нас получилась некая величина, которая обладает чудесным свойством: для прямой связи явлений она положительная, а для обратной — отрицательная.

Однако что с ней будет, если явления не связаны?

Навскидку, с ней будет — «когда как».

Но ведь если явления действительно не связаны, то на большом количестве измерений приблизительно в равной мере должны быть распределены оба варианта: положительное произведение отклонений и отрицательное. Если их просуммировать, то, видимо, получится что-то около нуля. Причём, тем ближе к нулю, чем больше было измерений.

Собственно, вышевведённая функция «матожидание» именно это и делает: суммирует. Потом, правда, ещё делит на количество измерений, но для обнаруженного свойства это не так важно: ведь деление на положительное число не меняет знак результата и не может превратить ноль в не ноль или наоборот.

Поэтому вот он, критерий: ковариация.

Или, если расположить все формулы рядом…

Да, так несколько длиннее, чем в оригинальном определении, но зато и лучше понятно, что происходит.

Теперь, в общем, остался последний момент. Ковариация, увы, может иметь произвольную величину, а потому, для того, чтобы сделать по ней вывод о связи между списками, надо ещё знать максимальное её значение именно для этих величин.

Однако, по счастью, оное можно вычислить в общем виде.

Для этого введём ещё одну интересную величину — выведенную из списка квадратов отклонений от среднего.

Это, как можно видеть, корень из матожидания квадратов отклонений от среднего. Оно так и называется «среднеквадратическое отклонение».

Так вот, можно показать, что ковариация по своей абсолютной величине не превышает произведения среднеквадратических отклонений по этим двум спискам.

Ну а так как среднеквадратическое отклонение по построению всегда положительно, то можно заключить, что

или

В общем, если за меру взаимосвязи взять такую «нормированную величину», то она получится очень удобной и очень универсальной: будет показывать, связаны ли величины между собой, давая для прямой связи единицу, для обратной — минус единицу, а для несвязанных величин — ноль…

…думали они.

Но ага, щаз.

Всё очень удобно и универсально, однако в вышеприведённых рассуждениях есть изрядное количество изъянов, которые — ввиду очевидного удобства и универсальности полученной «меры взаимосвязей» — очень удобно игнорировать, и от этого иметь универсальный способ для поточной генерации совершенно неверных, но зато наукообразных выводов.

Впрочем, надо отметить, что процесса «нормировки» это не касается — со знаменателем всё зашибись, а способ стрельбы себе в ногу кроется в числителе. Да и в самом подходе в целом.

Поэтому, хотя для проформы я тут и привёл полное рассуждение, вскрываемые далее явления вызваны ковариацией и именно на способ её вычисления следует обратить особое внимание.

Выстрел номер один: Ньютон всё наврал

Предположим, некий физик усомнился в законе всемирного тяготения. И решил — в полном соответствии с научным методом — проверить, что тела и правда притягиваются по определённому закону.

Для этого он заказал себе очень точные приборы и сделал экспериментальную установку, в центре которой размещено массивное тело, на любом расстоянии от которого можно размещать другие тела и замерять воздействующую на них силу.

Со всей тщательностью физик измерил силу, действующее на тело, отнесённое от центра на самые разные расстояния. Запротоколировал данные. А потом посчитал корреляцию между координатой изображённого тут зелёным тела и действующей на него силой.

Хм. Ньютон вроде бы утверждал, что сила тяготения однозначно связана с расстоянием между центрами объектов. Почему же мы тут получаем не единицу, а что-то меньшее? Ну ладно, это, быть может, погрешность измерений. Всё равно ведь понятно, что определённо между расстоянием по оси икс и действующей силой есть заметная обратная связь.

На беду, у этого физика были свои личные подозрения об устройстве мира. «Вдруг», — думал он — «миру не всё равно, с какой стороны расположено тело?». Надо попробовать размещать тела не только справа, но и слева.

Правда, прибор для измерения силы умел измерять только её абсолютную величину, но ничего страшного: ведь если есть взаимосвязь между двумя величинами, то между величиной и модулем второй тоже должна быть взаимосвязь.

Поэтому физик провёл второй эксперимент: помещая теперь тело не только справа, но иногда и слева от центра.

В результате, его подозрения оправдались: теперь корреляция координаты с абсолютной величиной силы уже не просто отличалась от единицы или минус единицы…

Она стала нулевой.

Что же тут произошло?

Сейчас, подождите, сначала мы посмотрим на ещё один способ стрельбы в собственные конечности.

Выстрел номер два: хаос энергоснабжения

Однажды физик обнаружил у себя дома удивительный артефакт: электрическую розетку.

Про розетки он слышал, что в них есть электрический ток, которым как раз и питаются электроприборы. А у тока есть напряжение. Которое, вроде бы, в розетках переменное. Так вот, интересно, связано ли это переменное напряжение со временем? Или же, напротив, оно там совершенно хаотичное и меняется как попало?

Для ответа на этот вопрос физик собрал хитрую схему из компьютера и вольтметра, которая через равные промежутки времени измеряет напряжение в сети.

Если связь есть, — рассуждал физик, — то я её таким образом обнаружу. И он был прав: таким образом её действительно можно обнаружить. Причём для этого даже не обязательно быть физиком.

Но на беду и этот физик тоже решил не доверяться интуиции, а вычислить связь автоматически. Для этого он посчитал корреляцию измеренных напряжений с теми моментами времени, когда они были измерены.

Как вы думаете, что в результате получил физик?

Не спешите с ответом…

Не спешите…

Wait…

Wait…

Here it comes…

Физик получил случайную величину от минус до плюс единицы.

В зависимости от того, как встали звёзды, физик мог «выяснить», что напряжение связано со временем прямой или обратной связью, или же, что оно со временем вообще не связано.

Но как?! Как совершенно логичный математический коэффициент может привести к столь абсурдному результату?

Сбитый прицел номер один

Чтобы понять, откуда в мире берётся такая фигня, мы временно, для простоты забудем про знаменатель.

Расположенная в числителе ковариация — это среднее арифметическое произведений отклонений.

Отклонений от чего?

От среднего.

Когда первый физик меряет силу, в зависимости от координаты, слева и справа в симметричных точках у него получаются одинаковые силы. Они отклонены от средней силы совершенно идентично, какой бы эта сила ни была.

Средняя же координата — 0. Отклонения от неё в симметричных точках равны по абсолютной величине, но противоположны по знаку.

Пусть в точке 1 отклонение силы от среднего равно dF1. Тогда в точке −1 будет такое же отклонение dF1. Но вот отклонения в координатах будут уже 1 и −1. Если мы перемножим отклонения, то получим…

| Координата | dx | dF | dx*dF |

|---|---|---|---|

| 1 | 1 | dF1 | dF1 |

| −1 | −1 | dF1 | −dF1 |

С точки зрения ковариации, эти симметричные значения просто взаимно уничтожаются.

Поскольку же физик приблизительно равномерно измерял силы слева и справа, то в среднем все измерения взаимно уничтожились.

Вот как выглядит график произведений отклонений, в зависимости от координаты.

Если случайным образом набрать с него точек, то сумма значений в них будет приблизительно равна нулю. И, следовательно, будет равна нулю ковариация.

И чем больше точек мы возьмём, тем она ближе к нулю. Что наверняка будет убеждать физика, что тут нет никакой ошибки или случайности: чем больше измерений он производит, тем более очевидно, что корреляция — нулевая.

И это при том, что наличие связи между координатой и действующей силой видно невооружённым глазом.

Быть может, ошибка была в том, что физик измерял абсолютную величину силы? Быть может, стоило ему измерить силу с учётом направления, всё получилось бы правильно?

О да, в этом случае корреляция была бы не нулевой, а ранее упомянутыми −0,68. Ведь в этом случае произведения симметричных отклонений не уничтожали бы друг друга.

Только это всё равно был бы ошибочный результат. Просто вывод, сделанный по нему, случайно совпал бы с правильным.

Ведь предположим, что Ньютон действительно наврал, и тела, расположенные справа, притягиваются, но вот расположенные слева — отталкиваются. В этом случае, напротив, игнорирование направления силы дало бы ненулевую корреляцию, а вот его учёт — нулевую.

И в одном из двух вариантов по-прежнему можно было бы сделать вывод об отсутствии взаимосвязи при реальном её наличии.

Причём с правильным совпадал бы вывод, сделанный по тому методу, по которому в другом случае получался бы вывод, не совпадающий с правильным.

Таким образом, в рамках данного метода в обязательном порядке надо сделать выбор между вариантами, заранее зная правильный ответ, — иначе можно выбрать тот вариант, который приводит к ошибке.

То есть это сам метод ошибочен. С его помощью невозможно сделать правильный вывод, не зная его заранее.

Сбитый прицел номер два

Аналогичная история происходит и со вторым физиком: он измеряет процесс, в котором взаимно уничтожаются произведения отклонений от среднего, хотя сам процесс при этом вполне закономерен.

Я для примера взял колебания вокруг нуля, однако это только для наглядности: коэффициент корреляции зависит не от величины, а от её отклонения от среднего, поэтому «без разницы», где расположено это среднее.

Здесь мы тоже наблюдаем симметрию. И эта симметрия с неизбежностью приводит к тому, что на некотором отрезке — кратном двойному периоду колебаний — сумма произведений отклонений взаимно уничтожается. И фактически на корреляцию будет оказывать влияние только тот «хвостик», который останется после последнего обнуления.

Вот как для данного фрагмента будет вести себя корреляция — в зависимости от того момента, когда физик остановил измерения.

Поскольку момент начала и конца измерений зависит только от стечения обстоятельств, физик в реальности высчитывает случайное число, а вовсе не «надёжный показатель связи между явлениями».

Правда, тут выручает то, что одна из величин — время — неограниченно растёт с ростом количества измерений, а вторая величина — напряжение — ограничена определённым диапазоном. В результате, расположенное в знаменателе среднеквадратическое отклонение времени увеличивается до сколь угодно большой величины быстрее, а потому корреляция стремится к нулю с увеличением отрезка времени, на котором проводятся измерения.

Это позволяет уверенно «доказывать» независимость абсолютно любой ограниченной диапазоном величины от времени, а не просто диагностировать наличие или отсутствие связи, в зависимости от того, как звёзды встали.

Хотя, конечно, и тут есть шанс выбрать периодичность замеров, слегка некратную периодичности колебаний, и снова тщательно вычислить случайное число. Например, напряжение в сети колеблется со слегка плавающей частотой: 50 раз в секунду. Поэтому проведение измерений с интуитивно напрашивающейся частотой раз в секунду — серьёзная заявка на успех.

В общем, если физику повезёт, и он замерит много периодов колебаний, не попав при этом в нужную «слегка некратность», он обнаружит на них близкую к нулю корреляцию. После чего сделает ошибочный вывод, что связи между временем и напряжением нет.

Если не повезёт, то результат вообще будет случайным числом, и тут уже, разумеется, никакой ошибки не будет.

Шутка.

В любом случае, вывод ошибочен. Даже если он случайно совпадёт с правильным — ведь ошибочен сам метод его получения.

Но иллюзия о научном обнаружении наличия или отсутствия связи в обоих случаях вполне может сохраниться.

Hold your fire №1 and №2

Первые два примера демонстрируют штуку, которую надо помнить в обязательном порядке: введённая нами «мера взаимосвязи» не универсальна. Сделанные при её построении рассуждения относились только к линейным зависимостям одной величины от другой.

Грубо говоря, это работает только тогда, когда предполагается зависимость…

Если же зависимость иная, то, вообще говоря, коэффициент корреляции может оказаться произвольным.

Да-да, не нулевым, а произвольным.

Ведь даже при очень хорошем случае — при убывании одной величины при возрастании другой — первый физик уже получил странный результат. Ещё до того, как он начал пробовать помещать тело не только справа, но и слева, при наличии совершенно однозначной и непериодической зависимости, полученный им коэффициент корреляции уже заметно отличался от −1.

И дело тут не в погрешности измерений. Дело в том, что даже зависимость

достаточно нелинейна для коэффициента корреляции. Уже на ней результат опасно близок к «хм, возможно, на силу влияет что-то ещё». Да, это, конечно, не −0,1, но всё-таки −0,68 — это и не чистая минус единица. Всё выглядит так, будто бы тут не совсем детерминированная связь.

Так какие же заключения можно сделать, вычислив коэффициент корреляции?

Если она нулевая, значит ли это, что величины не связаны?

Два примера показывают, что нет, нельзя.

А если она ненулевая, значит ли это, что зависимость есть?

Второй пример показывает, что и это тоже совершенно не обязательно: ведь вполне возможно и даже весьма вероятно на, например, периодическом процессе получить случайное число, довольно существенно отличающееся от нуля.

Иными словами, исследователь откуда-то должен знать заранее, что тут либо линейная зависимость, либо вообще никакой, чтобы сделать более-менее правильный вывод.

Но откуда он может это знать до исследований? Только из других исследований. Где анализ делался другими методами. Например, основывался на вдумчивом разглядывании графиков или распределений, формированием на их основе гипотезы о функции, связывающей две величины, и последующей экспериментальной проверке того, что эта функция и правда именно такая, поскольку с её помощью удаётся предсказать значение второй величины, зная первую.

Но если это всё уже проделано, то зачем ему вообще считать корреляцию? У него же уже есть более надёжные результаты.

Может быть, коэффициент корреляции можно использовать как первое приближение? Как оценку связи навскидку?

Хороша же такая оценка, которая при весьма вероятных закономерностях даёт случайное число, и приводит, таким образом, к совершенно разным выводам — в зависимости от расположения звёзд.

То есть в сухом остатке оказывается, что единственное, что можно сделать при помощи корреляции — это вывод об отсутствии одной и той же линейной на всём отрезке взаимосвязи между величинами.

Именно об отсутствии — ведь даже о наличии такой взаимосвязи вывод сделать нельзя (см. «случайное число»).

И именно что линейной на всём отрезке, поскольку при фрагментарно линейной вполне возможно взаимное уничтожение произведений отклонений.

Причём натолкнуться на такое может совсем даже не только усомнившийся в законе всемирного тяготения физик. Ровно так же хлебнуть полную чашу горя может медик, решивший выяснить связь температуры тела пациента с самочувствием пациента. При нормальной температуре — 36,6 °C — самочувствие, видимо, наилучшее. При повышении температуры оно ухудшается. Однако и при понижении температуры оно тоже ухудшается…

Чувствуете схожесть ситуации с экспериментами первого физика? О да, и с корреляцией будет тоже: при симметричности оценок слева и справа от нормальной температуры корреляция окажется близкой к нулю. Из чего медик сможет заключить, что связи между температурой и самочувствием нет.

И ровно то же самое будет с лекарством, у которого есть оптимальная доза приёма: при этой дозе результаты будут наилучшими, но вот при меньшей и при большей они будут хуже, что тоже приведёт к чисто техническому занулению коэффициента корреляции.

И вы думаете, на этом проблемы с коэффициентом кончились?

Ага. Щаз.

Выстрел номер три: неубедительный экстрасенс

Однажды к группе заинтересованных в изучении паранормальных явлений пришёл человек, обладающий удивительной способностью — он абсолютно безошибочно умел угадывать выпавшее на кубиках.

Правда, по воле паранормальных сил эта способность у него была выражена в весьма странной форме: если кто-то собирался бросить четыре кубика, то Космос тут же шептал экстрасенсу сумму выпавшего на них в тридцатой степени. Увы, экстрасенс был безграмотен (он просто слушал голос Космоса), а потому извлекать корень тридцатой степени не умел.

Впрочем, паранормологи этого делать тоже не умели: ни извлекать корень тридцатой степени, ни возводить в тридцатую степень. Однако они предположили, что его предсказания всё равно должны коррелировать с суммой выпавшего на кубиках (которую они считать всё-таки умели) — ведь между числом и его тридцатой степенью имеется однозначная математическая связь.

Не поленившись, паранормологи провели 10 000 испытаний. Не было никаких сомнений в том, что такого вполне достаточно для исключения любых случайностей.

Но результат их разочаровал: предсказания экстрасенса имели корреляцию с суммой выпавшего на кубиках всего 0,2. Такой вшивой корреляции явно недостаточно, чтобы подтвердить экстрасенсорные способности. 0,5 ещё куда ни шло, но вот 0,2…

В результате экстрасенс был изгнан и высмеян.

Сбитый прицел номер три

Я специально придумал этот пример, чтобы развеять сомнения, будто бы «дефолт-корреляция» может не срабатывать только при попытках измерять связь времени и состояния, но вот для неких случайных событий она всегда подходит.

О нет. И данные паранормологи тому примером.

На самом деле они прогнали экстрасенса, который совершенно правильно угадал в 100% случаев. Да-да, он ни разу не ошибся.

Однако проведи они даже миллион испытаний, всё равно корреляция была бы всё столь же низкой. Ибо я не зря сказал о том, что корреляция более-менее корректно отображает только линейную связь между величинами.

Здесь же наблюдался аналог того, что произошло с первым физиком, только в гипертрофированной форме: корреляция была не просто несколько подозрительной, а существенно ниже порогового уровня достоверности.

Случайно угадать все сто тысяч раз тридцатую степень суммы выпавшего на четырёх кубиках столь нереально, что такое вряд ли можно рассматривать всерьёз, но корреляция при этом утверждает, что экстрасенс как бы не угадывал.

Как бы утверждает.

Hold your fire №3

На самом же деле, совершенно не зря в справочниках пишут, что всё это осмыслено только при гауссовом распределении случайных величин. И зря так многие это либо не читают, либо игнорируют в своей практической деятельности.

«Гауссово» распределение подразумевает концентрацию основной массы результатов измерений вокруг некоторой величины (того самого «матожидания» или «среднего»). Причём чем дальше от неё случай, тем меньше раз мы его должны встречать.

Имеющаяся же в формуле корреляции σ — среднеквадратическое отклонение — характеризует в этом случае «ширину» данного колокола.

Негауссовость одного или обоих распределений — залог получения очень низкой корреляции даже при очевидной прямой взаимосвязи величин.

В данном случае сумма выпавшего на четырёх кубиках имела распределение, близкое к гауссову, но вот возведение результата в тридцатую степень убило даже намёк на гауссовость, что не замедлило сказаться на результате.

И не помогли даже 10 000 испытаний.

В реальных же исследованиях испытаний вполне может быть штук 100, например. И негауссовость распределения там может быть существенно менее экстремальной, но всё равно пагубно сказаться на результатах.

Выстрел номер четыре: убедительный экстрасенс

К тем же самым паранормологам через некоторое время пришёл ещё один посетитель. Он тоже имел паранормальную связь с кубиками, но его метод был проще: он бросал один кубик, а потом предлагал экспериментатору бросить второй. Благодаря тому, что в его руках была заключена особая магия, первый бросок кубика мистическим образом влиял на всю ситуацию в целом.

О нет, выпавшее на втором кубике он не брался предсказать, однако утверждал, что первый бросок окажет очень сильное влияние на второй бросок, суть коего влияния он, впрочем, не брался объяснить. Но предлагал просто взять и посчитать корреляцию выпавшего на первом кубике с суммой выпавшего на двух кубиках.

Первые сто испытаний повергли паранормологов в шок и трепет: корреляция действительно оказывалась весьма нехилой: 0,75.

Правда, они всё-таки усомнились, не было ли тут простого везения. Однако, проделав привычные для них 10 000 испытаний, они с удивлением отметили, что корреляция упала, но не так, чтобы очень сильно. Всё-таки 0,7 — это весьма неплохо. Согласно всем справочникам, это уже тянет на термин «высокая корреляция».

Определённо у этого экстрасенса был талант — оставалось только понять, каким способом из его предсказаний можно извлекать сведения о том, что выпадет на втором кубике…

Сбитый прицел номер четыре

…и правильный ответ: никаким. Нет никакого способа предсказать, что именно там выпадет. И даже, внезапно, нет никакого способа предсказать сумму.

Да-да, корреляция — высокая, однако всё, что можно сказать про сумму, это то, что она будет лежать на отрезке от выпавшего на первом кубике плюс один до выпавшего на первом кубике плюс шесть. Что было вполне понятно и безо всяких экстрасенсов.

Но никаких случайных совпадений — корреляция, правда, получится примерно вот такая.

Hold your fire №4

Разумеется, выпавшее на первом кубике влияет на сумму, поскольку оно входит туда как слагаемое. Однако корреляция показала всего лишь линейную связь первого со вторым. Выпавшего на первом кубике и случайной величины, полученной прибавлением к уже выпавшему второй случайной величины.

Но сколь же легко очароваться большим значением коэффициента и сделать вывод, который вовсе из него не следует: первый кубик как-то влияет на второй. Или даже, наоборот: ещё не брошенный второй кубик как-то влияет на первый.

Или хотя бы, что из результата броска первого кубика можно узнать что-то ещё, кроме и так очевидного.

Ах, сколько же раз такого рода эксперименты приводят к восторженным публикациям — причём не только в обычной прессе, но даже и во вполне научной.

Временами ничто не отделяет добросовестного биолога от того, чтобы путём сотен замеров открыть удивительный факт: все муравьи планеты строят муравейники, длина окружности основания которых примерно втрое больше диаметра этого основания.

Кажется, будто бы выполнение некого «научного» ритуала обязательно должно давать правильные результаты, даже если при этом не понимать сути этого ритуала, оправдывая фразами вида «я же паранормолог, а не математик».

Математика как бы работает сама. Ведь она же математика. Математика не обманывает.

И да, математика не обманывает — обманывают её трактовки.

Выстрел номер пять: хороший способ вызвать дождь

Как-то раз антрополог наблюдал за обычным городским жителем (конечно же, с его, этого жителя, согласия). И через некоторое время он заметил удивительную закономерность: если этот житель брал с собой зонт, то в этот день шёл дождь.

Конечно, так случалось не каждый раз: иногда объект наблюдения брал зонт, но дождь не шёл, иногда не брал, но дождь всё равно шёл, — однако слишком часто наличие зонта с наличием дождя и отсутствие зонта с отсутствием дождя случались одновременно.

Антрополог, как настоящий учёный, конечно, не доверился таким «навскидочным» оценкам, а вместо этого стал каждый день тщательно протоколировать свои наблюдения.

Через год он приписал событиям «взят зонт» и «был дождь» число 1, событиям «не взял зонт» и «не было дождя» число 0, и посчитал корреляцию по своим протоколам.

Корреляция была очень высокой: 0,95. Эти два события однозначно были связаны.

Гордый собой антрополог написал статью «Как вызывать дождь», в которой убедительно — по трём с половиной сотням наблюдений — доказывал, что именно вот этот житель управляет дождями по месту своего проживания. При помощи ношения зонта.

К сожалению, эту статью отказались печатать, ссылаясь на то, что как-то это всё неубедительно звучит.

Подумав некоторое время, антрополог пришёл к мысли, что наверно всё наоборот: это дождь управляет взятием зонта этим жителем. Просто данный гражданин способен видеть будущий дождь своим внутренним зрением. И, увидев будущий дождь, берёт с собой зонт — даже если на улице сейчас пока ещё нет никакого дождя. Если, конечно, не забыл с утра внутренним зрением посмотреть в будущее.

Ведь однозначно, столь высокая корреляция не может быть результатом случайности.

К сожалению, эту статью в журнал тоже не взяли, поскольку тамошние скептики не поверили в реальности внутреннего футуристического зрения, несмотря на столь яркие доказательства существования оного.