Критерий Стьюдента для

парных выборок

Гипотеза о среднем. H0: a1 = a2.

(X1,, X2,…, Xn) € N(θ1,θ2), (Y1,, Y2,…, Yn) € N(θ ′1,θ2 ′)

Xi и Yi связаны между собой (пара). Перейдем к разностям di = Xi и Yi, для

разностей гипотеза формулируется так:

H0: d0 = 0.

|

di |

||||||||||

|

n 1 |

||||||||||

|

n |

||||||||||

|

d |

||||||||||

|

T |

. |

|||||||||

|

d |

n di 2 di 2 |

|||||||||

|

S |

||||||||||

|

При |

справедливой |

гипотезе H0 |

T Tn 1

Ошибки первого и второго рода

•Существует два рода ошибок, которые можно сделать при проверке гипотез. Во –первых, можно ошибочно отвергнуть H0

(например, забраковать партию шариков). Вероятность совершить такую ошибку обычно называется вероятностью ошибки

первого рода (альфа). Вторая ошибка, которую можно сделать, –ошибочно не отвергнуть H0 (посчитать, что шарики стандартны), когда на самом деле они нестандартны. Вероятность этой ошибки обычно называется вероятностью ошибки

второго рода (бета).

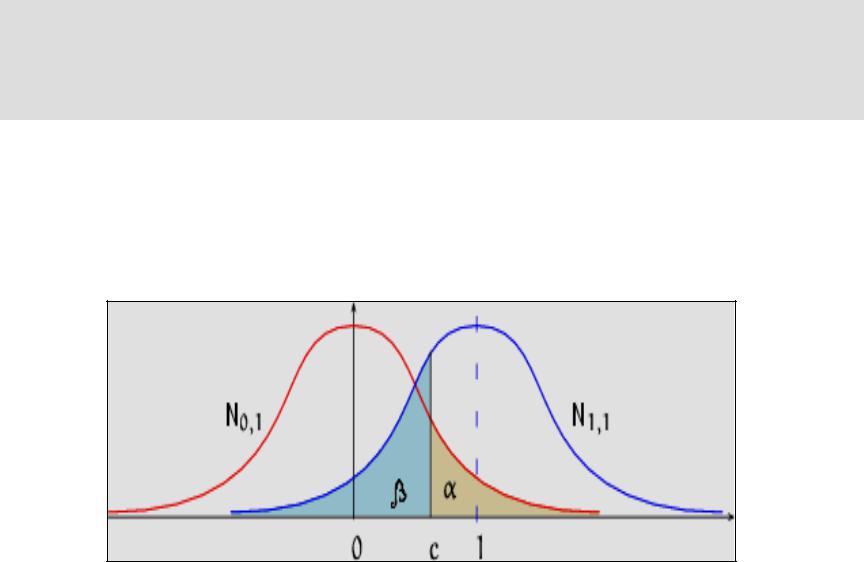

Ошибки первого и второго рода на графике

•Пусть H0: N(0,1)

•H1: N(1,1)

Ошибка первого рода

• Определение. Ошибка первого рода состоит в том, что H0 отвергается, когда она

верна.

Вероятность ошибки 1 –го рода обозначается α,

α = P(T€ V/ H0) (значение статистики Т принадлежит критической области V при условии, что верна H0) .

α – это уровень значимости.

Ошибка второго рода

• Определение. Ошибка второго рода состоит в том, что H0 не отвергается, когда она не верна.

Вероятность ошибки 2 –го рода обозначается

β.

β – это вероятность того, что значение статистики Т не принадлежит критической области V при условии, что верна H1.

Ошибки первого и второго рода

Двусторонняя критическая область

Мощность критерия

• Определение. Мощностью критерия

называется величина М = 1 – β. Мощность

критерия М равна вероятности отвергнуть

H0,

когда она не верна.

М – это вероятность того, что значение статистики Т принадлежит критической области V при условии, что верна H1.

Односторонняя альтернатива. α=0,05; β=0,36, M=1 –β=0,64.

Двусторонняя альтернатива. α=0,05; β=0,48, M=1 –β=0,52.

Соседние файлы в папке Лекция

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

Проверка корректности А/Б тестов

Время прочтения

8 мин

Просмотры 5.5K

Хабр, привет! Сегодня поговорим о том, что такое корректность статистических критериев в контексте А/Б тестирования. Узнаем, как проверить, является критерий корректным или нет. Разберём пример, в котором тест Стьюдента не работает.

Меня зовут Коля, я работаю аналитиком данных в X5 Tech. Мы с Сашей продолжаем писать серию статей по А/Б тестированию, это наша третья статья. Первые две можно посмотреть тут:

-

Стратификация. Как разбиение выборки повышает чувствительность A/Б теста

-

Бутстреп и А/Б тестирование

Корректный статистический критерий

В А/Б тестировании при проверке гипотез с помощью статистических критериев можно совершить одну из двух ошибок:

-

ошибку первого рода – отклонить нулевую гипотезу, когда на самом деле она верна. То есть сказать, что эффект есть, хотя на самом деле его нет;

-

ошибку второго рода – не отклонить нулевую гипотезу, когда на самом деле она неверна. То есть сказать, что эффекта нет, хотя на самом деле он есть.

Совсем не ошибаться нельзя. Чтобы получить на 100% достоверные результаты, нужно бесконечно много данных. На практике получить столько данных затруднительно. Если совсем не ошибаться нельзя, то хотелось бы ошибаться не слишком часто и контролировать вероятности ошибок.

В статистике ошибка первого рода считается более важной. Поэтому обычно фиксируют допустимую вероятность ошибки первого рода, а затем пытаются минимизировать вероятность ошибки второго рода.

Предположим, мы решили, что допустимые вероятности ошибок первого и второго рода равны 0.1 и 0.2 соответственно. Будем называть статистический критерий корректным, если его вероятности ошибок первого и второго рода равны допустимым вероятностям ошибок первого и второго рода соответственно.

Как сделать критерий, в котором вероятности ошибок будут равны допустимым вероятностям ошибок?

Вероятность ошибки первого рода по определению равна уровню значимости критерия. Если уровень значимости положить равным допустимой вероятности ошибки первого рода, то вероятность ошибки первого рода должна стать равной допустимой вероятности ошибки первого рода.

Вероятность ошибки второго рода можно подогнать под желаемое значение, меняя размер групп или снижая дисперсию в данных. Чем больше размер групп и чем ниже дисперсия, тем меньше вероятность ошибки второго рода. Для некоторых гипотез есть готовые формулы оценки размера групп, при которых достигаются заданные вероятности ошибок.

Например, формула оценки необходимого размера групп для гипотезы о равенстве средних:

где и

– допустимые вероятности ошибок первого и второго рода,

– ожидаемый эффект (на сколько изменится среднее),

и

– стандартные отклонения случайных величин в контрольной и экспериментальной группах.

Проверка корректности

Допустим, мы работаем в онлайн-магазине с доставкой. Хотим исследовать, как новый алгоритм ранжирования товаров на сайте влияет на среднюю выручку с покупателя за неделю. Продолжительность эксперимента – одна неделя. Ожидаемый эффект равен +100 рублей. Допустимая вероятность ошибки первого рода равна 0.1, второго рода – 0.2.

Оценим необходимый размер групп по формуле:

import numpy as np

from scipy import stats

alpha = 0.1 # допустимая вероятность ошибки I рода

beta = 0.2 # допустимая вероятность ошибки II рода

mu_control = 2500 # средняя выручка с пользователя в контрольной группе

effect = 100 # ожидаемый размер эффекта

mu_pilot = mu_control + effect # средняя выручка с пользователя в экспериментальной группе

std = 800 # стандартное отклонение

# исторические данные выручки для 10000 клиентов

values = np.random.normal(mu_control, std, 10000)

def estimate_sample_size(effect, std, alpha, beta):

"""Оценка необходимого размер групп."""

t_alpha = stats.norm.ppf(1 - alpha / 2, loc=0, scale=1)

t_beta = stats.norm.ppf(1 - beta, loc=0, scale=1)

var = 2 * std ** 2

sample_size = int((t_alpha + t_beta) ** 2 * var / (effect ** 2))

return sample_size

estimated_std = np.std(values)

sample_size = estimate_sample_size(effect, estimated_std, alpha, beta)

print(f'оценка необходимого размера групп = {sample_size}')оценка необходимого размера групп = 784Чтобы проверить корректность, нужно знать природу случайных величин, с которыми мы работаем. В этом нам помогут исторические данные. Представьте, что мы перенеслись в прошлое на несколько недель назад и запустили эксперимент с таким же дизайном, как мы планировали запустить его сейчас. Дизайн – это совокупность параметров эксперимента, таких как: целевая метрика, допустимые вероятности ошибок первого и второго рода, размеры групп и продолжительность эксперимента, техники снижения дисперсии и т.д.

Так как это было в прошлом, мы знаем, какие покупки совершили пользователи, можем вычислить метрики и оценить значимость отличий. Кроме того, мы знаем, что эффекта на самом деле не было, так как в то время эксперимент на самом деле не запускался. Если значимые отличия были найдены, то мы совершили ошибку первого рода. Иначе получили правильный результат.

Далее нужно повторить эту процедуру с мысленным запуском эксперимента в прошлом на разных группах и временных интервалах много раз, например, 1000.

После этого можно посчитать долю экспериментов, в которых была совершена ошибка. Это будет точечная оценка вероятности ошибки первого рода.

Оценку вероятности ошибки второго рода можно получить аналогичным способом. Единственное отличие состоит в том, что каждый раз нужно искусственно добавлять ожидаемый эффект в данные экспериментальной группы. В этих экспериментах эффект на самом деле есть, так как мы сами его добавили. Если значимых отличий не будет найдено – это ошибка второго рода. Проведя 1000 экспериментов и посчитав долю ошибок второго рода, получим точечную оценку вероятности ошибки второго рода.

Посмотрим, как оценить вероятности ошибок в коде. С помощью численных синтетических А/А и А/Б экспериментов оценим вероятности ошибок и построим доверительные интервалы:

def run_synthetic_experiments(values, sample_size, effect=0, n_iter=10000):

"""Проводим синтетические эксперименты, возвращаем список p-value."""

pvalues = []

for _ in range(n_iter):

a, b = np.random.choice(values, size=(2, sample_size,), replace=False)

b += effect

pvalue = stats.ttest_ind(a, b).pvalue

pvalues.append(pvalue)

return np.array(pvalues)

def print_estimated_errors(pvalues_aa, pvalues_ab, alpha):

"""Оценивает вероятности ошибок."""

estimated_first_type_error = np.mean(pvalues_aa < alpha)

estimated_second_type_error = np.mean(pvalues_ab >= alpha)

ci_first = estimate_ci_bernoulli(estimated_first_type_error, len(pvalues_aa))

ci_second = estimate_ci_bernoulli(estimated_second_type_error, len(pvalues_ab))

print(f'оценка вероятности ошибки I рода = {estimated_first_type_error:0.4f}')

print(f' доверительный интервал = [{ci_first[0]:0.4f}, {ci_first[1]:0.4f}]')

print(f'оценка вероятности ошибки II рода = {estimated_second_type_error:0.4f}')

print(f' доверительный интервал = [{ci_second[0]:0.4f}, {ci_second[1]:0.4f}]')

def estimate_ci_bernoulli(p, n, alpha=0.05):

"""Доверительный интервал для Бернуллиевской случайной величины."""

t = stats.norm.ppf(1 - alpha / 2, loc=0, scale=1)

std_n = np.sqrt(p * (1 - p) / n)

return p - t * std_n, p + t * std_n

pvalues_aa = run_synthetic_experiments(values, sample_size, effect=0)

pvalues_ab = run_synthetic_experiments(values, sample_size, effect=effect)

print_estimated_errors(pvalues_aa, pvalues_ab, alpha)оценка вероятности ошибки I рода = 0.0991

доверительный интервал = [0.0932, 0.1050]

оценка вероятности ошибки II рода = 0.1978

доверительный интервал = [0.1900, 0.2056]Оценки вероятностей ошибок примерно равны 0.1 и 0.2, как и должно быть. Всё верно, тест Стьюдента на этих данных работает корректно.

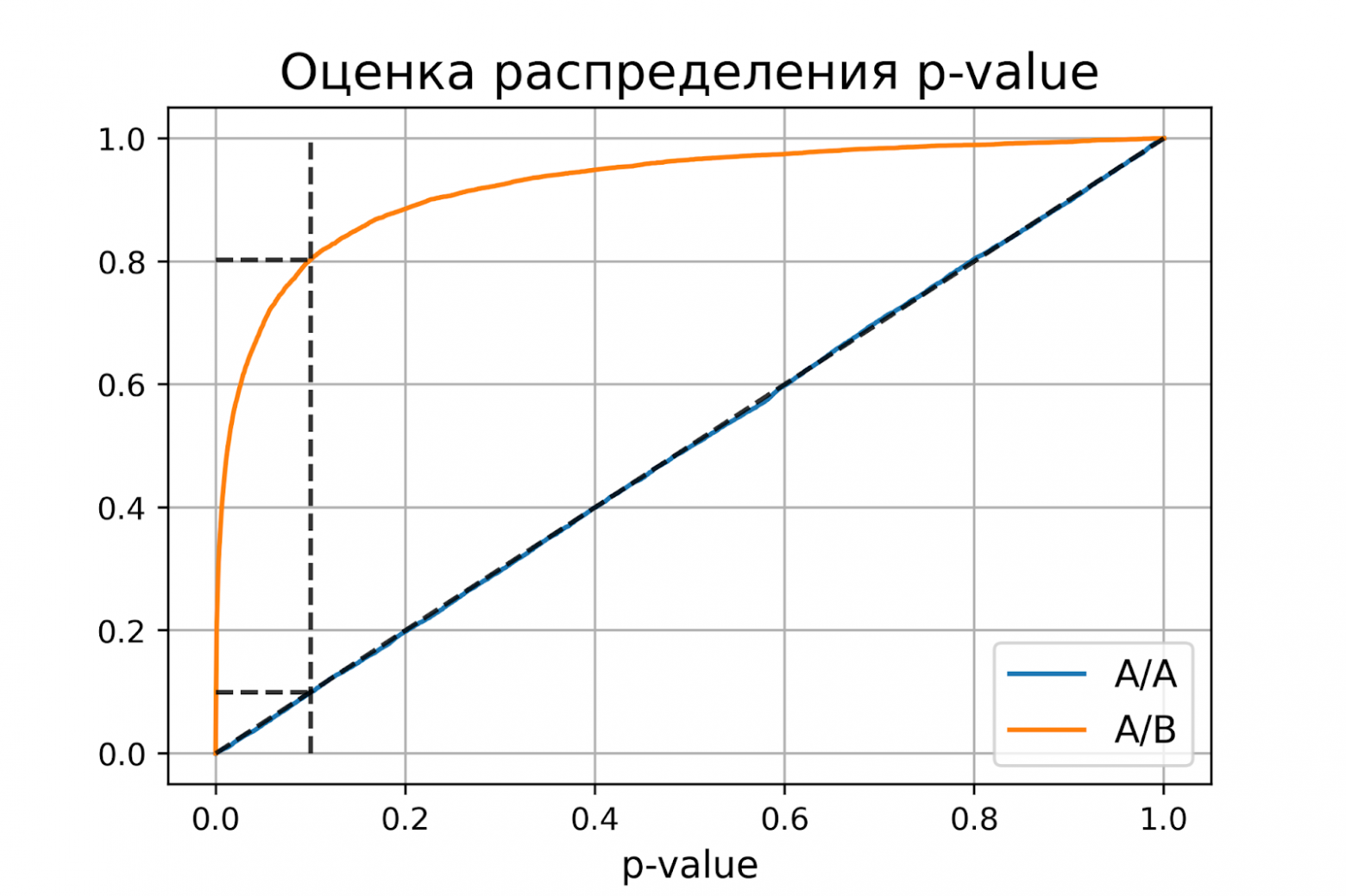

Распределение p-value

Выше рассмотрели случай, когда тест контролирует вероятность ошибки первого рода при фиксированном уровне значимости. Если решим изменить уровень значимости с 0.1 на 0.01, будет ли тест контролировать вероятность ошибки первого рода? Было бы хорошо, если тест контролировал вероятность ошибки первого рода при любом заданном уровне значимости. Формально это можно записать так:

Для любого выполняется

.

Заметим, что в левой части равенства записано выражение для функции распределения p-value. Из равенства следует, что функция распределения p-value в точке X равна X для любого X от 0 до 1. Эта функция распределения является функцией распределения равномерного распределения от 0 до 1. Мы только что показали, что статистический критерий контролирует вероятность ошибки первого рода на заданном уровне для любого уровня значимости тогда и только тогда, когда при верности нулевой гипотезы p-value распределено равномерно от 0 до 1.

При верности нулевой гипотезы p-value должно быть распределено равномерно. А как должно быть распределено p-value при верности альтернативной гипотезы? Из условия для вероятности ошибки второго рода следует, что

.

Получается, график функции распределения p-value при верности альтернативной гипотезы должен проходить через точку , где

и

– допустимые вероятности ошибок конкретного эксперимента.

Проверим, как распределено p-value в численном эксперименте. Построим эмпирические функции распределения p-value:

import matplotlib.pyplot as plt

def plot_pvalue_distribution(pvalues_aa, pvalues_ab, alpha, beta):

"""Рисует графики распределения p-value."""

estimated_first_type_error = np.mean(pvalues_aa < alpha)

estimated_second_type_error = np.mean(pvalues_ab >= alpha)

y_one = estimated_first_type_error

y_two = 1 - estimated_second_type_error

X = np.linspace(0, 1, 1000)

Y_aa = [np.mean(pvalues_aa < x) for x in X]

Y_ab = [np.mean(pvalues_ab < x) for x in X]

plt.plot(X, Y_aa, label='A/A')

plt.plot(X, Y_ab, label='A/B')

plt.plot([alpha, alpha], [0, 1], '--k', alpha=0.8)

plt.plot([0, alpha], [y_one, y_one], '--k', alpha=0.8)

plt.plot([0, alpha], [y_two, y_two], '--k', alpha=0.8)

plt.plot([0, 1], [0, 1], '--k', alpha=0.8)

plt.title('Оценка распределения p-value', size=16)

plt.xlabel('p-value', size=12)

plt.legend(fontsize=12)

plt.grid()

plt.show()

plot_pvalue_distribution(pvalues_aa, pvalues_ab, alpha, beta)P-value для синтетических А/А тестах действительно оказалось распределено равномерно от 0 до 1, а для синтетических А/Б тестов проходит через точку .

Кроме оценок распределений на графике дополнительно построены четыре пунктирные линии:

-

диагональная из точки [0, 0] в точку [1, 1] – это функция распределения равномерного распределения на отрезке от 0 до 1, по ней можно визуально оценивать равномерность распределения p-value;

-

вертикальная линия с

– пороговое значение p-value, по которому определяем отвергать нулевую гипотезу или нет. Проекция на ось ординат точки пересечения вертикальной линии с функцией распределения p-value для А/А тестов – это вероятность ошибки первого рода. Проекция точки пересечения вертикальной линии с функцией распределения p-value для А/Б тестов – это мощность теста (мощность = 1 —

).

-

две горизонтальные линии – проекции на ось ординат точки пересечения вертикальной линии с функцией распределения p-value для А/А и А/Б тестов.

График с оценками распределения p-value для синтетических А/А и А/Б тестов позволяет проверить корректность теста для любого значения уровня значимости.

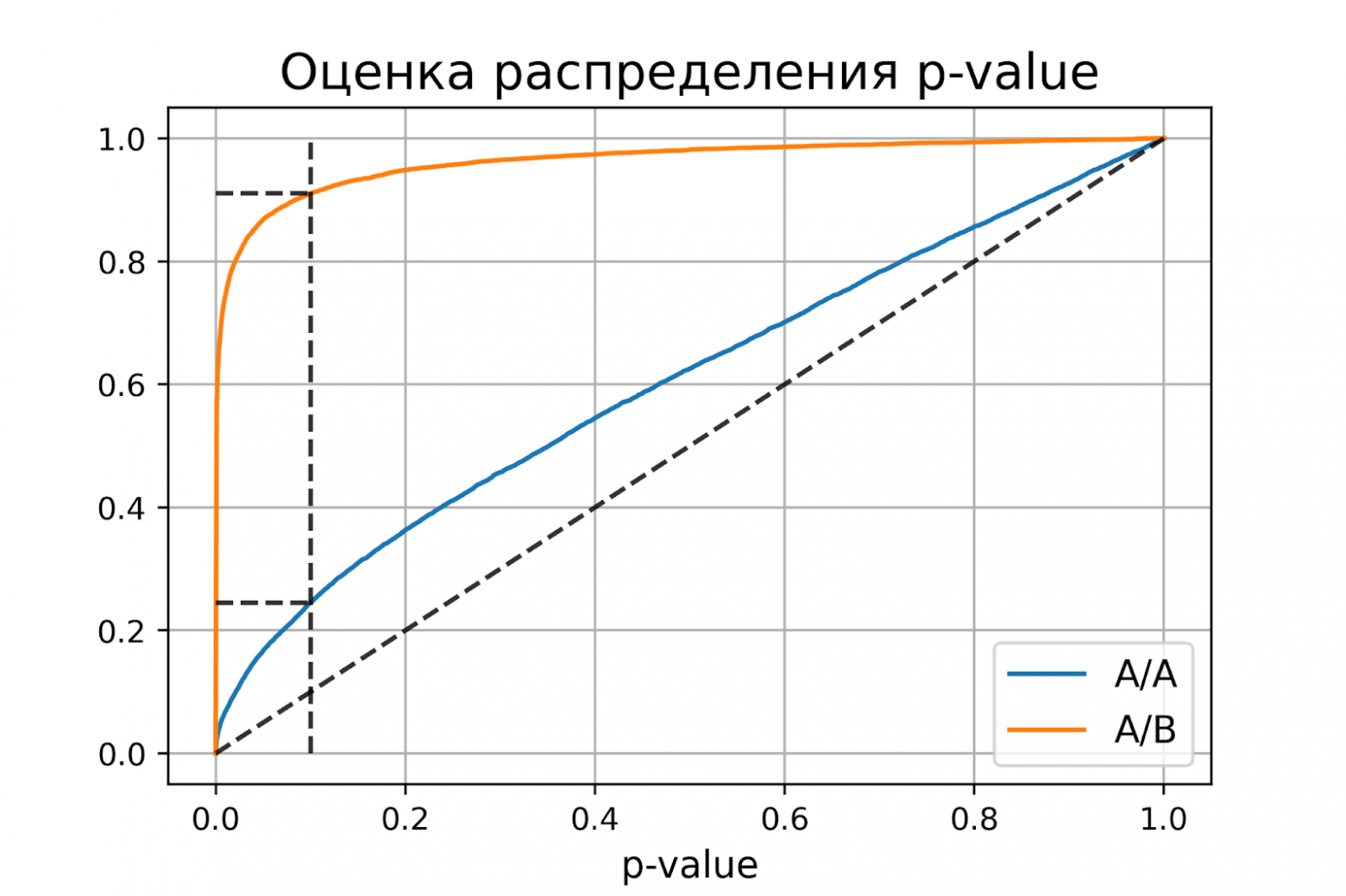

Некорректный критерий

Выше рассмотрели пример, когда тест Стьюдента оказался корректным критерием для случайных данных из нормального распределения. Может быть, все критерии всегда работаю корректно, и нет смысла каждый раз проверять вероятности ошибок?

Покажем, что это не так. Немного изменим рассмотренный ранее пример, чтобы продемонстрировать некорректную работу критерия. Допустим, мы решили увеличить продолжительность эксперимента до 2-х недель. Для каждого пользователя будем вычислять стоимость покупок за первую неделю и стоимость покупок за второю неделю. Полученные стоимости будем передавать в тест Стьюдента для проверки значимости отличий. Положим, что поведение пользователей повторяется от недели к неделе, и стоимости покупок одного пользователя совпадают.

def run_synthetic_experiments_two(values, sample_size, effect=0, n_iter=10000):

"""Проводим синтетические эксперименты на двух неделях."""

pvalues = []

for _ in range(n_iter):

a, b = np.random.choice(values, size=(2, sample_size,), replace=False)

b += effect

# дублируем данные

a = np.hstack((a, a,))

b = np.hstack((b, b,))

pvalue = stats.ttest_ind(a, b).pvalue

pvalues.append(pvalue)

return np.array(pvalues)

pvalues_aa = run_synthetic_experiments_two(values, sample_size)

pvalues_ab = run_synthetic_experiments_two(values, sample_size, effect=effect)

print_estimated_errors(pvalues_aa, pvalues_ab, alpha)

plot_pvalue_distribution(pvalues_aa, pvalues_ab, alpha, beta)оценка вероятности ошибки I рода = 0.2451

доверительный интервал = [0.2367, 0.2535]

оценка вероятности ошибки II рода = 0.0894

доверительный интервал = [0.0838, 0.0950]Получили оценку вероятности ошибки первого рода около 0.25, что сильно больше уровня значимости 0.1. На графике видно, что распределение p-value для синтетических А/А тестов не равномерно, оно отклоняется от диагонали. В этом примере тест Стьюдента работает некорректно, так как данные зависимые (стоимости покупок одного человека зависимы). Если бы мы сразу не догадались про зависимость данных, то оценка вероятностей ошибок помогла бы нам понять, что такой тест некорректен.

Итоги

Мы обсудили, что такое корректность статистического теста, посмотрели, как оценить вероятности ошибок на исторических данных и привели пример некорректной работы критерия.

Таким образом:

-

корректный критерий – это критерий, у которого вероятности ошибок первого и второго рода равны допустимым вероятностям ошибок первого и второго рода соответственно;

-

чтобы критерий контролировал вероятность ошибки первого рода для любого уровня значимости, необходимо и достаточно, чтобы p-value при верности нулевой гипотезы было распределено равномерно от 0 до 1.

Ошибки I и II рода при проверке гипотез, мощность

Общий обзор

Принятие неправильного решения

Мощность и связанные факторы

Проверка множественных гипотез

Общий обзор

Большинство проверяемых гипотез сравнивают между собой группы объектов, которые испытывают влияние различных факторов.

Например, можно сравнить эффективность двух видов лечения, чтобы сократить 5-летнюю смертность от рака молочной железы. Для данного исхода (например, смерть) сравнение, представляющее интерес (например, различные показатели смертности через 5 лет), называют эффектом или, если уместно, эффектом лечения.

Нулевую гипотезу выражают как отсутствие эффекта (например 5-летняя смертность от рака молочной железы одинаковая в двух группах, получающих разное лечение); двусторонняя альтернативная гипотеза будет означать, что различие эффектов не равно нулю.

Критериальная проверка гипотезы дает возможность определить, достаточно ли аргументов, чтобы отвергнуть нулевую гипотезу. Можно принять только одно из двух решений:

- отвергнуть нулевую гипотезу и принять альтернативную гипотезу

- остаться в рамках нулевой гипотезы

Важно: В литературе достаточно часто встречается понятие «принять нулевую гипотезу». Хотелось бы внести ясность, что со статистической точки зрения принять нулевую гипотезу невозможно, т.к. нулевая гипотеза представляет собой достаточно строгое утверждение (например, средние значения в сравниваемых группах равны ).

Поэтому фразу о принятии нулевой гипотезы следует понимать как то, что мы просто остаемся в рамках гипотезы.

Принятие неправильного решения

Возможно неправильное решение, когда отвергают/не отвергают нулевую гипотезу, потому что есть только выборочная информация.

| |

Верная гипотеза | ||

|---|---|---|---|

| H0 | H1 | ||

| Результат применения критерия |

H0 | H0 верно принята | H0 неверно принята (Ошибка второго рода) |

| H1 | H0 неверно отвергнута (Ошибка первого рода) |

H0 верно отвергнута |

Ошибка 1-го рода: нулевую гипотезу отвергают, когда она истинна, и делают вывод, что имеется эффект, когда в действительности его нет. Максимальный шанс (вероятность) допустить ошибку 1-го рода обозначается α (альфа). Это уровень значимости критерия; нулевую гипотезу отвергают, если наше значение p ниже уровня значимости, т. е., если p < α.

Следует принять решение относительно значения а прежде, чем будут собраны данные; обычно назначают условное значение 0,05, хотя можно выбрать более ограничивающее значение, например 0,01.

Шанс допустить ошибку 1-го рода никогда не превысит выбранного уровня значимости, скажем α = 0,05, так как нулевую гипотезу отвергают только тогда, когда p< 0,05. Если обнаружено, что p > 0,05, то нулевую гипотезу не отвергнут и, следовательно, не допустят ошибки 1-го рода.

Ошибка 2-го рода: не отвергают нулевую гипотезу, когда она ложна, и делают вывод, что нет эффекта, тогда как в действительности он существует. Шанс возникновения ошибки 2-го рода обозначается β (бета); а величина (1-β) называется мощностью критерия.

Следовательно, мощность — это вероятность отклонения нулевой гипотезы, когда она ложна, т.е. это шанс (обычно выраженный в процентах) обнаружить реальный эффект лечения в выборке данного объема как статистически значимый.

В идеале хотелось бы, чтобы мощность критерия составляла 100%; однако это невозможно, так как всегда остается шанс, хотя и незначительный, допустить ошибку 2-го рода.

К счастью, известно, какие факторы влияют на мощность и, таким образом, можно контролировать мощность критерия, рассматривая их.

Мощность и связанные факторы

Планируя исследование, необходимо знать мощность предложенного критерия. Очевидно, можно начинать исследование, если есть «хороший» шанс обнаружить уместный эффект, если таковой существует (под «хорошим» мы подразумеваем, что мощность должна быть по крайней мере 70-80%).

Этически безответственно начинать исследование, у которого, скажем, только 40% вероятности обнаружить реальный эффект лечения; это бесполезная трата времени и денежных средств.

Ряд факторов имеют прямое отношение к мощности критерия.

Объем выборки: мощность критерия увеличивается по мере увеличения объема выборки. Это означает, что у большей выборки больше возможностей, чем у незначительной, обнаружить важный эффект, если он существует.

Когда объем выборки небольшой, у критерия может быть недостаточно мощности, чтобы обнаружить отдельный эффект. Эти методы также можно использовать для оценки мощности критерия для точно установленного объема выборки.

Вариабельность наблюдений: мощность увеличивается по мере того, как вариабельность наблюдений уменьшается.

Интересующий исследователя эффект: мощность критерия больше для более высоких эффектов. Критерий проверки гипотез имеет больше шансов обнаружить значительный реальный эффект, чем незначительный.

Уровень значимости: мощность будет больше, если уровень значимости выше (это эквивалентно увеличению допущения ошибки 1-го рода, α, а допущение ошибки 2-го рода, β, уменьшается).

Таким образом, вероятнее всего, исследователь обнаружит реальный эффект, если на стадии планирования решит, что будет рассматривать значение р как значимое, если оно скорее будет меньше 0,05, чем меньше 0,01.

Обратите внимание, что проверка ДИ для интересующего эффекта указывает на то, была ли мощность адекватной. Большой доверительный интервал следует из небольшой выборки и/или набора данных с существенной вариабельностью и указывает на недостаточную мощность.

Проверка множественных гипотез

Часто нужно выполнить критериальную проверку значимости множественных гипотез на наборе данных с многими переменными или существует более двух видов лечения.

Ошибка 1-го рода драматически увеличивается по мере увеличения числа сравнений, что приводит к ложным выводам относительно гипотез. Следовательно, следует проверить только небольшое число гипотез, выбранных для достижения первоначальной цели исследования и точно установленных априорно.

Можно использовать какую-нибудь форму апостериорного уточнения значения р, принимая во внимание число выполненных проверок гипотез.

Например, при подходе Бонферрони (его часто считают довольно консервативным) умножают каждое значение р на число выполненных проверок; тогда любые решения относительно значимости будут основываться на этом уточненном значении р.

Связанные определения:

p-уровень

Альтернативная гипотеза, альтернатива

Альфа-уровень

Бета-уровень

Гипотеза

Двусторонний критерий

Критерий для проверки гипотезы

Критическая область проверки гипотезы

Мощность

Мощность исследования

Мощность статистического критерия

Нулевая гипотеза

Односторонний критерий

Ошибка I рода

Ошибка II рода

Статистика критерия

Эквивалентные статистические критерии

В начало

Содержание портала

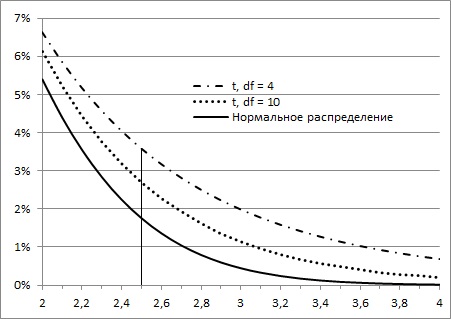

Большинству из нас хорошо знакома колоколообразная кривая нормального распределения. Она отлично работает, когда выборки большие, но занижает значения на «хвостах», когда выборки малые. Для описания статистики малых выборок была разработана t-статистика Стьюдента. Она также симметрична и подчиняется колоколообразному распределению, но дает лучшую оценку для малых выборок. В отличие от нормального распределения t-статистика не одна, а представлена целым семейством распределений. Дополнительный параметр – размер выборки или число степеней свободы.

Рис. 1. Нормальная кривая и кривые t-распределения; df – число степеней свободы (от англ. degrees of freedom); gif-файл создан с помощью бесплатного сервиса ezgif.com, на который меня навела Евгения Крюкова

Скачать заметку в формате Word или pdf, примеры в формате Excel

Подход пивовара

В начале XX века Уильяму Сили Госсету, химику и статистику ирландской пивоваренной компании Guinness, потребовалось установить, какой из двух сортов ячменя дает лучшее пиво с большим выходом.[1] Ранее была разработана статистика нормального распределения, позволяющая находить доверительный интервал на основе случайной выборки, состоящей из не менее чем 30 объектов. К сожалению, у Госсета не было возможности протестировать большое число партий пива, изготовленных из каждого сорта ячменя. Однако он не отказался от своей затеи измерить то, что как будто не поддавалось оценке, и решил вывести новый вид распределения для крайне малых выборок. К 1908 г. Госсет разработал новый эффективный метод, который назвал t-статистикой, и захотел опубликовать результаты своей работы.

Однако у Guinness уже были проблемы с разглашением коммерческой тайны, и служащим компании было запрещено публиковать любую информацию о бизнес-процессах. Госсет понимал значение своей работы. Ему сильнее хотелось рассказать о своей идее, чем добиться немедленного признания. Поэтому он опубликовал статью под псевдонимом Стьюдент. И хотя истинный автор давно известен, практически во всех работах по статистике метод называется t-статистикой Стьюдента.

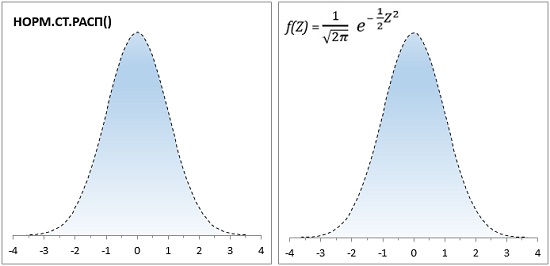

От физических значений к z-статистике

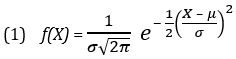

Колоколообразная кривая нормального распределения описывается формулой:

где f(X) – вероятность значения Х; f(X) откладывается по оси ординат; е — основание натурального логарифма; μ — математическое ожидание генеральной совокупности, σ — стандартное отклонение генеральной совокупности, X — произвольное значение непрерывной случайной величины; X откладывается по оси абсцисс; –∞ < X < +∞ (о вычислении μ и σ подробнее см. Определение среднего значения, вариации и формы распределения. Описательные статистики).

Формула (1) довольно сложная, и в докомпьютерную эру статистики использовали заранее рассчитанные таблицы. Поскольку составление таблиц для всего разнообразия Х, μ и σ дело неподъемное, была придумана стандартизация, которая состоит в приведении физических величин к z-единицам, путем простой арифметической подстановки

В этом случае всё многообразие нормальных кривых сводится к единому стандартизованному распределению:

где математическое ожидание (среднее) стандартизованного нормального распределения μ = 0, а стандартное отклонение σ = 1. Фактически, z – это десятичное число, для которого σ = 1, μ = 0.

Сейчас функция в Excel НОРМ.РАСП(x;среднее;стандартное_откл;интегральная) значительно упростила работу с формулой (1). Однако, заложенная традиция сохранилась, и статистики обсуждают особенности распределения, критические границы и т.п. в терминах стандартного нормального распределения (рис. 2). Для последнего в Excel используется функция НОРМ.СТ.РАСП(z;интегральная).

Рис. 2. Формула (3) реализована в Excel с помощью функции НОРМ.СТ.РАСП(); по оси абсцисс – z-единицы, по оси ординат – вероятность.

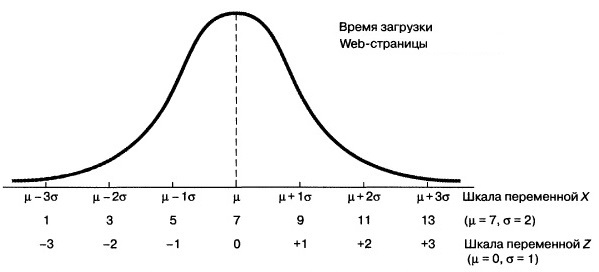

Для перехода от стандартного распределения к физическим величинам нужно применить обратное преобразование:

Допустим вы изучаете время загрузки некой Web-страницы, и выясняете, что оно распределено нормально, причем математическое ожидание равно μ = 7с, а стандартное отклонение σ = 2с. Как показывает рис. 3, каждому значению переменной X соответствует нормированное значение Z, полученное с помощью формулы преобразования (2). Следовательно, время загрузки, равное 9с, на одну стандартную единицу превышает математическое ожидание: Z = (9 – 7) / 2 = +1, а время загрузки равное 1с на три z-единицы (стандартных отклонения) меньше математического ожидания: Z = (1 – 7) / 2 = –3.

Рис. 3. Преобразование физических значений в z-значения для μ = 7, σ = 2

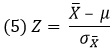

Описанные выше z-единицы используют для индивидуальных оценок, т.е. для измерений, приписываемых отдельным элементам выборки (например, рост каждого ученика школы). Если в качестве точек кривой нормального распределения берутся средние значения выборок (например, средний рост учеников различных классов), используют термин z-значение или z-статистика:[2]

где X̅ – среднее значение выборки (средний рост учеников 5А класса), μ – среднее значение генеральной совокупности (средний рост всех учеников школы), – стандартная ошибка средних (стандартное отклонение среднего роста учеников отдельных классов от среднего роста всех учеников школы). Последняя рассчитывается по формуле:

где σ – стандартная ошибка индивидуальных значений, n – размер выборки (число учеников в классе).

t-значение

Допустим, вы предполагаете, что дизельные двигатели автомобилей определенной модели выбрасывают в атмосферу больше оксида азота, чем заявлено в рекламных объявлениях. Вы знаете, что стандарт устанавливает ограничение на выбросы – не более 0,4 грамма на милю пробега. Вы хотели бы сравнить эмпирически полученные результаты не со средним по генеральной совокупности, а с этим стандартом – 0,4 г/милю. Это целевое значение, а не параметр генеральной совокупности. Вы тестируете пять автомобилей данной модели и измеряете уровень выброса оксида азота в дорожных условиях. Далее вы вычисляете среднее количество выбросов оксида азота для пяти автомобилей и находите стандартное отклонение. Наконец, вы находите величину:

где X̅ – средний уровень выбросов диоксида азота для пяти автомобилей; μ = 0,4 – установленный стандартом граничный уровень выбросов оксида азота;[3] s — стандартное отклонение уровня выбросов оксида азота по результатам для пяти автомобилей.

Это отношение очень похоже на формулу (2) для z-значения, но в действительности это t-значение. z- и t-значения отличаются тем, что для нахождения t-значения используется стандартное отклонение, полученное на основе выборочных результатов s, а не известное значение параметра генеральной совокупности σ. Использование латинской буквы s вместо греческой буквы σ для обозначения стандартного отклонения напоминает о том, что в данном случае значение стандартного отклонения является выборочной оценкой (статистикой), а не известным параметром.

Плотность распределения t-значений рассчитывается не с помощью формулы (3), а существенно сложнее. Я не привожу её здесь, поскольку сейчас в лоб ее никто не считает. Все используют готовые функции в статистических пакетах.

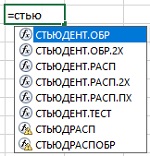

В Excel есть ряд функций, работающих с t-статистикой (рис. 4). Функции, имена которых включают часть РАСП, принимают t-значение в качестве аргумента и возвращают вероятность. Функции, имена которых включают часть ОБР, принимают значение вероятности в качестве аргумента и возвращают t-значение. Две последние функции на рис. 4 устарели и оставлены для обратной совместимости с более ранними версиями Excel.

Рис. 4. Семейство функций в Excel, работающих с t-статистикой Стьюдента

Степени свободы

Кривая t-распределения аналогична стандартной нормальной кривой, но ее форма немного меняется в зависимости от количества наблюдений, использованных для ее построения. В общем случае количество степеней свободы df = n – k, где n — количество наблюдений в выборке, а k — количество статистик, фиксированных для выборки. Например, если мы просто изучаем выборку, то k = 1, так как мы зафиксировали только среднее значение выборки. Если мы изучаем регрессионную зависимость от одной переменной, то k = 2; зафиксированы две статистики: среднее по выборке и наклон регрессионной кривой. Каждая дополнительная независимая переменная в регрессионной зависимости уменьшает число степеней свободы на единицу.

Во все функции Excel, предназначенные для работы с t-распределением, вторым аргументом входит количество степеней свободы df. Этот параметр необходим Excel для того, чтобы правильно вычислить форму кривой плотности t-распределения и вернуть корректное значение вероятности t-значения, заданного с помощью первого аргумента. Так для одного и того же z-значения = t-значению = 2,5 вероятность встретить его зависит от размера выборки (числа степеней свободы; рис. 5).

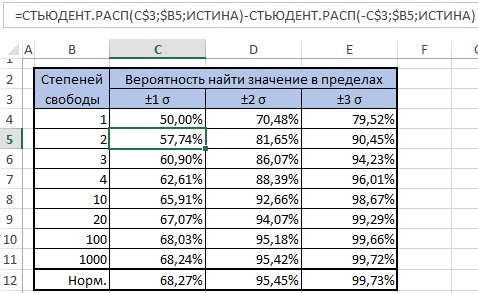

Рис. 5. Вероятность появления z- или t-значения зависит от того, какое распределение используется

То, насколько толстыми или тяжелыми являются хвосты t-распределения можно выразить количественно (рис. 6). Так, например, в пределах одного стандартного отклонение от среднего при нормальном распределении находится 68,27% значений. Для t-распределения с двумя степенями свободы такая вероятность существенно меньше – 57,74%.

Рис. 6. Сравнение нормального и t-распределений

Функции Excel для работы с t-распределением

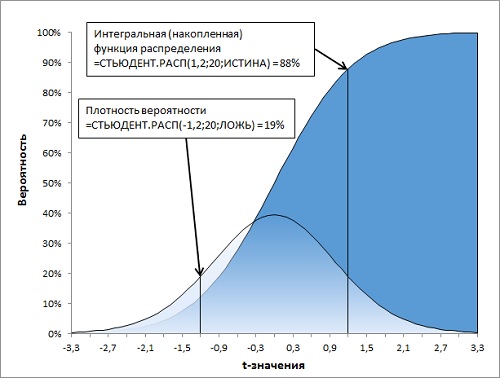

Рассмотрим работу функций Excel подробнее. Функция =СТЬЮДЕНТ.РАСП(t-значение;df;интегральная) возвращает левостороннее t-распределение Стьюдента (рис. 7). t-значение должно быть стандартизовано согласно формуле (7), т.е., выражено в долях стандартного отклонения σ при математическом ожидание генеральной совокупности µ = 0. Последний аргумент функции СТЬЮДЕНТ.РАСП() является логическим значением. Если он равен ЛОЖЬ, возвращается функция плотности распределения, т.е., вероятность для одного t-значения – Р(Х=t). Если он равен ИСТИНА, функция возвращает интегральное (накопленное) значение, т.е., вероятность попасть в интервал от минус бесконечности до t-значения – Р(Х≤t).

Рис. 7. Левостороннее t-распределение Стьюдента, функция Excel СТЬЮДЕНТ.РАСП()

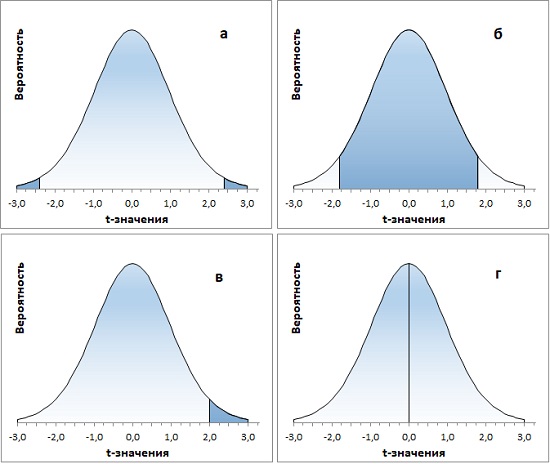

Если функцию СТЬЮДЕНТ.РАСП() дополнить простыми арифметическими действиями, можно решить множество задач, связанных с t-распределением. Некоторые из них представлены ниже (рис. 8; во всех случаях df = 20):

- какова вероятность найти значение за пределами диапазона ±2,4σ от среднего значения Р(|Х|≥2,4)? =СТЬЮДЕНТ.РАСП(-2,4;20;ИСТИНА)*2

- какова вероятность найти значение внутри диапазона ±1,8σ от среднего значения Р(|Х|≤1,8)? =СТЬЮДЕНТ.РАСП(1,8;20;ИСТИНА)-СТЬЮДЕНТ.РАСП(-1,8;20;ИСТИНА) или, учитывая симметричность t-распределения, =(0,5-СТЬЮДЕНТ.РАСП(-1,8;20;ИСТИНА))*2

- какова вероятность найти значение справа от 2σ Р(Х≥2)?

=1-СТЬЮДЕНТ.РАСП(2;20;ИСТИНА) - какова вероятность среднего значения Р(Х=0)?

=СТЬЮДЕНТ.РАСП(0;20;ЛОЖЬ)

Рис. 8. Функция Excel СТЬЮДЕНТ.РАСП() позволяет решать основные задачи с t-распределением

Функция СТЬЮДЕНТ.РАСП.ПХ() возвращает правостороннее t-распределение, причем только интегральное. Т.е., она показывает накопленную вероятность, начиная с правой точки +∞ при движении влево – Р(X≥t).[4] У функции только два аргумента: t-значение и число степеней свободы. Она чуть более удобна, чем СТЬЮДЕНТ.РАСП() в задачах, где нас интересует вероятность обнаружить то или иное значение правого хвоста. Для примера (в) выше (см. также рис. 8в) формула будет такой: =СТЬЮДЕНТ.РАСП.ПХ(2;20).

Функция СТЬЮДЕНТ.РАСП.2Х() возвращает двустороннее t-распределение Стьюдента – P(|X|≥t) или P(X≥t или X≤-t). Как и функция СТЬЮДЕНТ.РАСП.ПХ(), она имеет два аргумента (t-значение и число степеней свободы), и возвращает только интегральное значение. Функция СТЬЮДЕНТ.РАСП.2Х() показывает накопленную вероятность для двух симметричных хвостов. Она чуть более удобна, чем СТЬЮДЕНТ.РАСП() в задачах, где нас интересует вероятность обнаружить два хвоста сразу. При этом задать нужно t-значение правого хвоста (отрицательные t-значения функция не принимает). Для примера (а) выше (см. также рис. 9а) формула будет такой: =СТЬЮДЕНТ.РАСП.2Х(2,4;20).

t-критерий

Одно из важных применений t-статистики связано с ответом на вопрос, насколько выборка характерна для генеральной совокупности? Например, если в генеральной совокупности среднее μ, а в выборке – х̅, какова вероятность, что выборка сделана из этой генеральной совокупности, а не из другой?

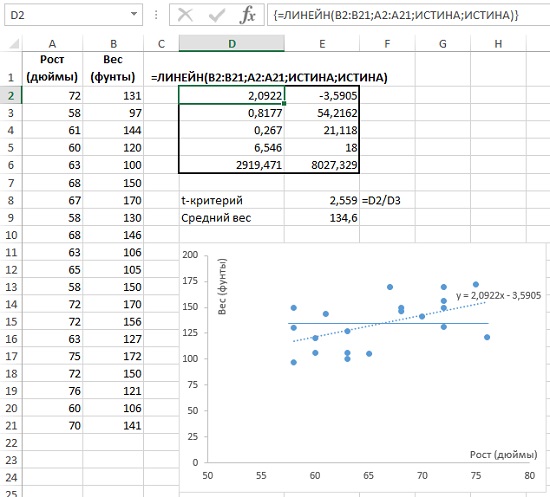

Рассмотрим пример (рис. 9). Исследуется зависимость веса от роста. Функция массива ЛИНЕЙН() (ячейки D2:E6), возвращает, в частности, наклон регрессионной кривой, он же коэффициент регрессии (ячейка D2) и стандартную ошибку коэффициента регрессии (ячейка D3). На рис. 9 данные роста и веса помещены на точечную диаграмму. На ней изображена регрессионная прямая (пунктирная линия; чтобы вывести ее, кликните в области диаграммы правой кнопкой мыши, и выберите опцию Добавить линию тренда…). Выведена также и формула регрессионной кривой y = 2,0922x – 3,5905 (естественно, коэффициент при х равен значению в ячейке D2).

t-критерий параметра = значение параметра, деленное на стандартную ошибку параметра

В нашем случае t-критерий коэффициента регрессии = коэффициент регрессии / стандартная ошибка коэффициента регрессии = 2,0922 / 0,8177 = 2,559 (ячейка Е8).

Рис. 9. Коэффициент регрессии = 2,0922 и t-критерий коэффициента регрессии = 2,559

Допустим, в генеральной совокупности вес не зависит от роста (нулевая гипотеза; на рис. 9 изображена сплошной прямой). Это значит, что коэффициент регрессии генеральной совокупности равен 0. В нашей выборке из 20 человек, мы обнаружили линейную зависимость веса от роста с коэффициентом регрессии (коэффициентом при х) = 2,0922. Если нормировать эту величину на стандартную ошибку, мы получим безразмерную величину = 2,559. Т.е., подсчитанный нами коэффициент регрессии в выборке на 2,559 сигм отстоит от нуля.

Насколько невероятно (или вероятно) получить такое отклонение в выборке, если в генеральной совокупности коэффициент регрессии = 0? Можно ли дать определение того, какое событие можно считать «невероятным». Считать ли его таковым, если оно происходит один раз в серии из 20 испытаний? Или в серии из 100 испытаний? А может быть, из 1000 испытаний? Как правило, событие считают «невероятным», если оно может произойти не чаще, чем в одном случае из двадцати.

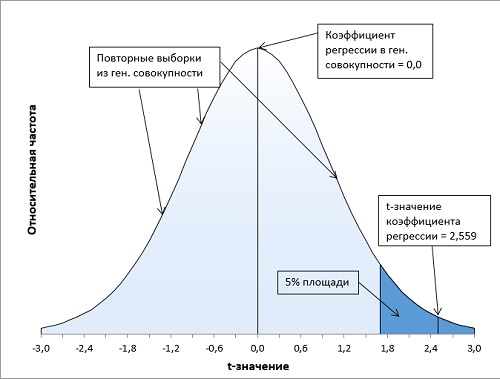

Итак, в качестве нулевой гипотезы можно принять, что вес не зависит от роста. В качестве альтернативной гипотезы мы предположим, что вес положительно коррелирован с ростом (чем больше рост, тем больше вес). Мы отклоним нулевую гипотезу, только если t-значение коэффициента регрессии попадет в правый хвост распределения в область, соответствующую 5% всей площади под кривой (α = 0,05). Это, как раз, произойдет не чаше, чем один раз на двадцать выборок (рис. 10).

Рис. 10. Расположение t-значения коэффициента регрессии (2,559) на кривой t-распределения Стьюдента (df = 18) показывает, что его вероятность около 1% не превышает α-уровень = 5%. Нулевая гипотеза может быть отвергнута. Статистики выборки говорят о зависимости веса от роста.

Расчет t-значения, соответствующего заданному уровню значимости

Проблема выбора «уровня невероятности», т.е. уровня статистической значимости, или α-уровня, десятилетиями будоражила статистиков. Найти ответы на подобные вопросы зачастую очень трудно, и многие исследователи лишь пожимают плечами и выбирают для альфа-уровня одно из общепринятых значений: р < 0,05 или р < 0,01. Почему именно такие значения?

Главная причина — это то, что в течение многих лет исследователи должны были полагаться на справочные таблицы, позволяющие найти такое t-значение, которое можно было бы считать «статистически значимым» на уровне 0,05 или 0,01 (таблиц для других α-значений практически не было). В наше время определение критического значения t-статистики при любом заданном уровне значимости не составляет труда.

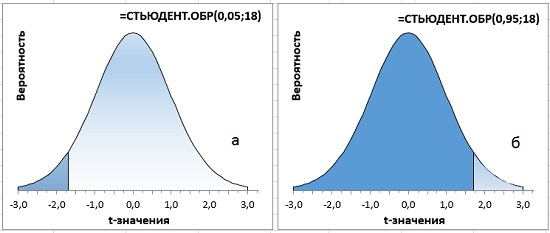

В Excel есть две функции для расчета t-критерия по уровню значимости (вероятности). СТЬЮДЕНТ.ОБР(вероятность;степени_свободы) возвращает левостороннее обратное t-распределение. В качестве первого аргумента функция принимает накопленную вероятность, начиная с –∞. Как правило, используется для односторонних тестов. В случае использования в двустороннем тесте α-значение следует разделить на 2. Например, t-значение для 5%-ного уровня значимости на рис. 10 можно найти с помощью формул =–СТЬЮДЕНТ.ОБР(0,05;18) или =СТЬЮДЕНТ.ОБР(1–0,05;18). В обоих случаях ответ 1,7341. В первом случае СТЬЮДЕНТ.ОБР(0,05;18) возвращает значение –1,7341, соответствующее 5%, накопленным от –∞ до –1,7341 (рис. 11а). Для получения окончательного ответа нужно воспользоваться свойством симметрии кривой распределения, и добавить знак минус перед функцией. Во втором случае СТЬЮДЕНТ.ОБР(1–0,05;18) возвращает значение 1,7341, соответствующее 95%, накопленным от –∞ до 1,7341 (рис. 11б).

Рис. 11. Односторонний t-критерий с уровнем значимости α = 5%

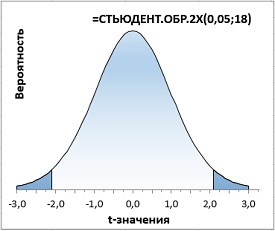

Вторая функция =СТЬЮДЕНТ.ОБР.2Х() используется в двусторонних тестах, когда мы допускаем, что исследуемое значение может отклоняться в обе стороны от среднего. В формулу следует подставить α-уровень значимости, функция сама разобьет его на две части и вернет значение, соответствующее двум симметричным хвостам (рис. 12; сравните с рис. 11а).

Рис. 12. Двусторонний t-критерий с уровнем значимости α = 5%

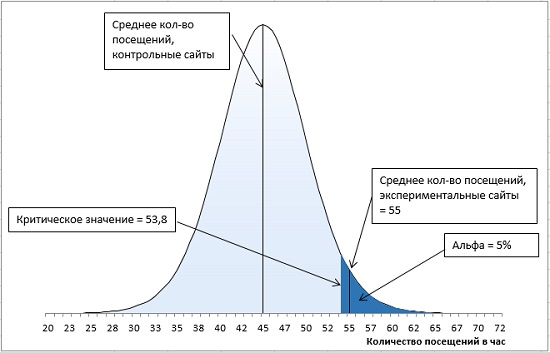

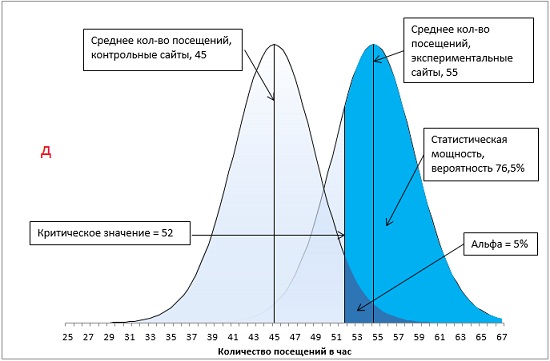

Ошибка первого рода

Предположим, перед вами стоит задача увеличить трафик нескольких веб-сайтов. Вы договариваетесь с владельцем популярного рекламного сайта о том, чтобы на его страницах отображались ссылки на 16 сайтов, случайным образом выбираемых из списка сайтов, контролируемых вашей компанией. Другие ваши 16 сайтов, также выбираемые случайным образом, не будут продвигаться в течение месяца.

Вы намереваетесь сравнить между собой средние показатели посещений сайтов, ссылки на которые специально продвигаются поставщиком рекламных услуг, и остальных сайтов. Вы останавливаете свой выбор на направленной гипотезе с альфа-уровнем 0,05: только если специально продвигаемые сайты характеризуются большим средним количеством посещений и только если различие между двумя группами сайтов настолько велико, что при многократном повторении данного испытания оно может случайно встретиться не чаще, чем в одном случае из 20, вы будете отбрасывать гипотезу о том, что специальное продвижение сайта не влияет на среднее количество его посещений.

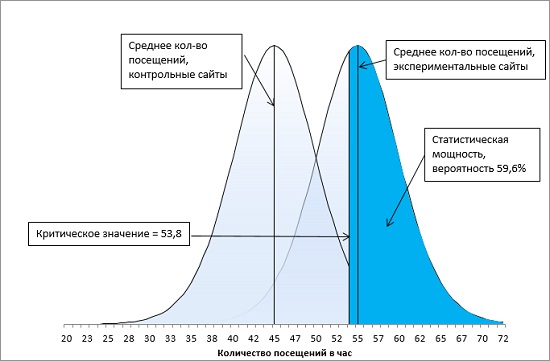

Через месяц вы получаете свои данные и обнаруживаете, что средний показатель для вашей контрольной группы – сайтов, не получающих специального продвижения, – составляет 45 посещений в час, а для продвигаемых сайтов – 55 посещений в час. Стандартная ошибка среднего равна 5.

Итак, у нас имеется контрольная группа из 16 сайтов (df = 15), правосторонний однонаправленный тест с α-уровнем = 0,05. t-значение определяется по формуле =-СТЬЮДЕНТ.ОБР(0,05;15) и равно 1,7531. Критическое значение посещаемости определяется по формуле (4) и равно: t-значение * стандартное отклонение выборки + среднее по выборке = 1,7531 * 5 + 45 = 53,8. Среднее по экспериментальной группе (55) больше критического t-значения (55 > 53,8). Мы можем отвергнуть нулевую и принять альтернативную гипотезу – продвижение сайтов влияет на посещаемость (рис. 13).

Рис. 13. Попадание среднего значения внутрь α-уровня позволяет отвергнуть нулевую гипотезу

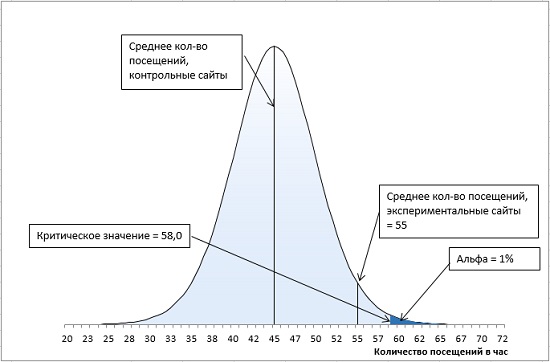

Но, значение альфа-уровня полностью контролируется нами — это наше правило принятия решений. Если бы мы установили для альфа-уровня значение 0,01, мы бы не отвергли нулевую гипотезу (рис. 14). Мы могли бы сказать, что среднее экспериментальной группы происходит из той же генеральной совокупности, что и среднее контрольной группы. Итак, статистическая ошибка I рода: мы отвергаем нулевую гипотезу, когда она верна.

Рис. 14. Для α-уровня = 0,01 среднее экспериментальной группы не позволяет отвергнуть нулевую гипотезу

Что же мешает установить α-уровень достаточно маленьким, и не отвергать нулевую гипотезу, когда она верна? …Ошибка II рода, заключающаяся в том, что мы не принимаем альтернативную гипотезу, хотя она верна.

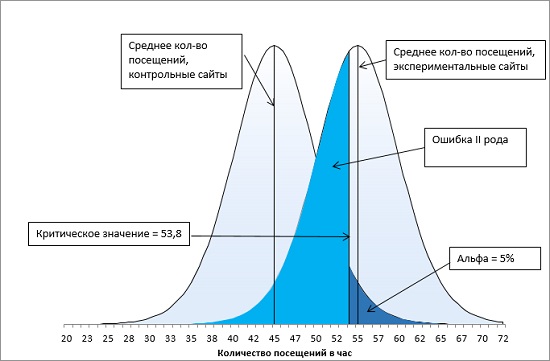

Ошибка второго рода

Представьте, что существуют две генеральные совокупности: одна из них состоит из сайтов, не получающих специального продвижения, вторая — из сайтов, получающих продвижение. Если вы повторите свое месячное исследование сотни или даже тысячи раз, то, возможно, получите две колоколообразные кривые (рис. 15).

Рис. 15. Ошибка второго рода при α-уровне = 0,05

Иногда среднее значение экспериментальной группы будет происходить из правого хвоста левой кривой распределения исключительно из-за выборочной ошибки. Поскольку в данном случае среднее экспериментальной группы превышает среднее контрольной группы более чем на 1,75 стандартной ошибки (попадает в область α-уровня = 0,05), вы должны отвергнуть нулевую гипотезу, даже если обе генеральные совокупности в действительности имеют одно и то же среднее. Такое неверное отбрасывание нулевой гипотезы, когда в действительности она является истинной, мы назвали ошибкой I рода. В терминах рис. 15 ошибка I рода – приписывание среднего результата экспериментальной выборки, равное 55, правой кривой, а не хвосту левой кривой.

Кривая слева представляет генеральную совокупность веб-сайтов, не получающих специального продвижения. На протяжении месяца частота посещений для некоторых из этих сайтов (очень немногих) составит всего 25 посещений в час, тогда как для других, столь же немногочисленных, – 62 посещения в час. Но 90% всех средних показателей выборок лежат в диапазоне 36,2–53,8 посещений в час.

Кривая справа представляет специально продвигаемые сайты. Как правило, показатели для них примерно на 10 посещений в час выше, чем для сайтов, представленных кривой слева. Их общее среднее составляет 55 посещений в час. Однако большая часть этой информации скрыта от вас. У вас отсутствуют данные о генеральной совокупности, и вы располагаете только результатами двух извлеченных вами выборок, но и этого вам будет вполне достаточно.

Рассмотрим правую кривую на рис. 15. Площадь под этой кривой от минимальных до критического значения (равного 53,8) выделена ярко голубым. Она определяет вероятность ошибки II рода. Средние выборок, проистекающие из этой области, мы относим к левой кривой, а не к правой. Для количественной оценки вероятности ошибки II рода найдем t-значение границы для правой кривой по формуле (7):

Вероятность того, что значение относится к правой кривой и лежит в диапазоне t-значений от –∞ до –0,247 определяется формулой =СТЬЮДЕНТ.РАСП(-0,247;15;ИСТИНА) = 0,404. Т.е., при выбранном нами α-уровне = 0,05 с вероятностью 40,4% мы отклоним альтернативную гипотезу, хотя она верна!

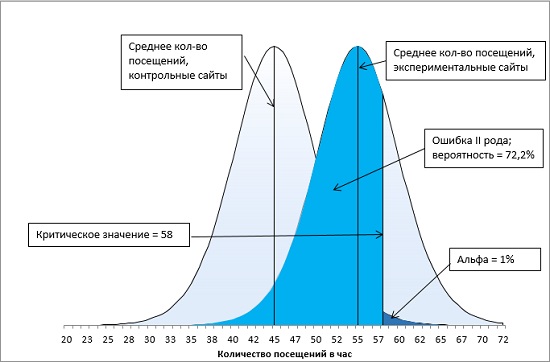

Что произойдет, если мы выберем α-уровень = 0,01, как на рис. 14? Вероятность ошибки II рода увеличится до 72,2% (рис. 16).

Рис. 16. Ошибка второго рода при α-уровне = 0,01

Статистическая мощность

Вероятность, количественно определяющую величину ошибки второго рода, называют β (на рис. 16 β = 72,2%). А вероятность р = (1 – β) – статистической мощностью (рис. 17).

Рис. 17. Статистическая мощность исследования при α-уровне = 0,05

Чем выше статистическая мощность, тем больше вероятность того, что мы отклоним нулевую гипотезу и примем альтернативную гипотезу. На мощность влияют четыре основных фактора:

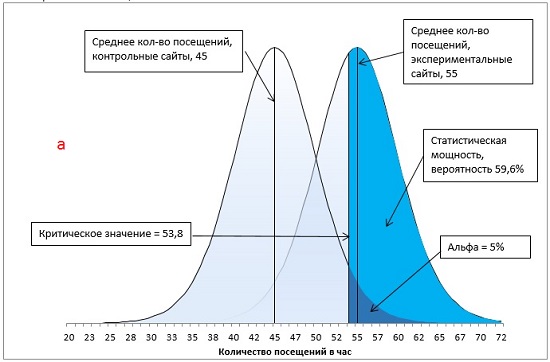

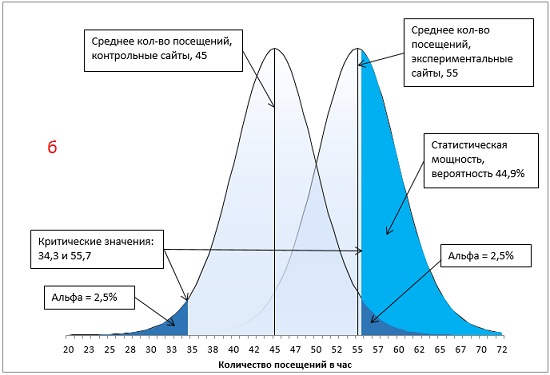

- Тип теста (переход от двунаправленного теста к однонаправленному увеличивает мощность).

- Уровень α, то есть вероятность ошибки I рода: более высокая α увеличивает мощность.

- Разница между средними значениями выборок (мощность выше при большей разнице).

- Стандартная ошибка среднего (чем ниже ошибка, тем мощность выше).

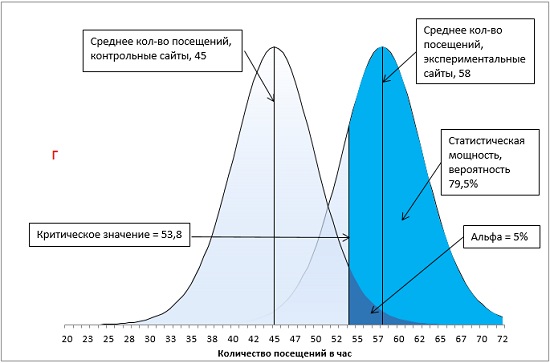

Давайте на нашем примере рассмотрим, как каждый из указанных факторов изменяет мощность, считая, что факторы меняться по одному (рис 18; расчеты и формулы можно найти в файле Excel).

Рис. 18. Методы увеличения статистической мощности: а) базовый вариант; б) ненаправленная гипотеза; в) увеличение α с 0,05 до 0,1; г) увеличение разницы между средними экспериментальной и контрольной групп с 10 до 13 посещений в час; д) увеличение размера групп с 16 до 24 сайтов.

Первый метод повышения статистической мощности связан с подготовкой эксперимента. Если вместо ненаправленной гипотезы (двуххвостовой тест) использовать направленную (однохвостовой тест), вся величина α-уровня отнесется к одному хвосту распределения (сравните рис. 18а и 18б). В результате критическое значение сместится в сторону среднего значения распределения. Чем ближе критическое значение к среднему, тем более вероятно, что вы получите результат, превышающий критическое значение, что увеличивает статистическую мощность тестов. В нашем примере, мощность возрастет с 44,9% до 59,6%.

Второй метод повышения мощности теста предлагает ослабить α-уровень. Например, увеличивая α от 0,05 до 0,10, вы увеличиваете вероятность совершения ошибки I рода, но уменьшаете вероятность совершения ошибки II рода (сравните рис. 18а и 18в). В нашем примере, мощность возросла с 59,6% до 74%.

Оставшиеся два метода повышения статистической мощности основаны на формуле расчета t-статистики:

где t – t-значение для среднего выборки (а не для индивидуального значения), X̅ – среднее значение выборки, μ – среднее значение генеральной совокупности (или среднее значение контрольной выборки), – стандартная ошибка средних по выборкам (а не индивидуальных значений), равная:

где s – стандартная ошибка индивидуальных значений, n – размер выборки.

Для увеличения t-статистики (и, как следствие, статистической мощности) нужно, либо увеличить числитель, либо уменьшить знаменатель в формуле (8). Для увеличения разности X̅ – μ требуется внесение изменений в проведение эксперимента. Как это сделать, непростой вопрос, решаемый в каждом конкретном случае. В нашем примере, увеличение X̅ с 55 до 58 посещений в час при неизменном μ = 45, приведет к росту статистической мощности с 59,6% до 79,5% (рис. 18г).

И, наконец, уменьшение величины знаменателя тестовой статистики в формуле (8), есть не что иное, как уменьшение стандартной ошибки . Одним из способов уменьшения стандартной ошибки является увеличение размера выборки, n. В соответствии с формулой (9), чем больше n, тем меньше . В нашем примере, при неизменной стандартной ошибке индивидуальных значений s, увеличение контрольной и экспериментальной групп с 16 до 24 сайтов приведет к уменьшению с 5 до 4,1 и росту мощности с 59,6% до 76,5% (рис. 18д).

Один из хороших способов познакомиться с влиянием разных факторов на мощность – это поэкспериментировать с графическим калькулятором мощности, например, здесь.

Основные положения заметки

t-статистика Стьюдента используется вместо нормального распределения: а) для малых выборок; б) если стандартное отклонение генеральной совокупности σ не известно.

t-распределение представлено семейством распределений; дополнительный параметр – размер выборки или число степеней свободы.

Число степеней свободы равно размеру выборки минус число фиксированных статистик выборки (среднее, коэффициент регрессии, …)

Чем больше степеней свободы, тем ближе t-распределение к нормальному.

Функции в Excel, имена которых включают часть РАСП, принимают t-значение в качестве аргумента и возвращают вероятность. Функции, имена которых включают часть ОБР, принимают значение вероятности в качестве аргумента и возвращают t-значение.

Для подстановки в функции Excel значения предварительно должны быть стандартизованы.

Ошибка I рода: отбрасывание нулевой гипотезы, когда в действительности она является истинной. Ошибка II рода: не принятие альтернативной гипотезы, хотя она верна. Чем больше ошибка первого рода, тем меньше ошибка второго рода.

Критерий отнесения события к маловероятному является произвольным. Традиционно маловероятным считают событие, происходящее не чаще, чем 1 раз из 20 попыток.

Один из основных методов уменьшения ошибки второго рода – увеличение элементов в выборке.

[1] При написании замети использованы материалы книг: Дуглас Хаббард. Как измерить всё, что угодно, Левин и др. Статистика для менеджеров, Сара Бослаф. Статистика для всех, Конрад Карлберг. Регрессионный анализ в Microsoft Excel.

[2] На самом деле, можно встретить довольно много различных терминов в отношении нормированных значений z. Ориентируйтесь не на названия, а на суть понятий.

[3] Могут высказать справедливое замечание, что не следует обозначать граничный уровень так же, как и математическое ожидание генеральной совокупности µ. Соглашусь, но всё же использую обозначение, поскольку, в иных задачах здесь часто фигурирует именно математическое ожидание генеральной совокупности µ.

[4] Некоторые авторы указывают знак меньше или равно для левостороннего распределения Р(Х≤t), и больше для правостороннего Р(X>t). Однако, для t=0 значения СТЬЮДЕНТ.РАСП(0;df;ИСТИНА) = СТЬЮДЕНТ.РАСП.ПХ(0;df) = 0,5 для любого значения df. На мой взгляд, Excel при интегральном расчете трактует границу, как исчезающе малую. Поэтому, нет разницы, использовать знак ≥ или >.

Т-критерий Стьюдента (t-тест) простым языком

Сегодня мы говорим о t-критерии. Т-критерий наиболее популярный статистический тест в биомедицинских исследованиях. Также его называют парный Т-критерий Стьюдента, t-test, two-sample unpaired t-test. Однако, при использовании этого статистического инструмента допускается достаточно много ошибок. Сегодня в этой статье мы постараемся разобраться, как избежать ошибок применения t-критерия Стьюдента, как интерпретировать его результаты и как рассчитывать t-критерий самостоятельно. Об этом обо всем читайте далее.

При описании любого статистического критерия, будь то t-критерий Стьюдента, либо какой-либо еще, нужно вспомнить о том, как же вообще используются статистические критерии. Для того, чтобы понять, как используется любой критерий, нужно перейти к нескольким достаточно логичным для понимания этапам:

Этапы статистического вывода (statistic inference)

- Первый из них – это вопрос, который мы хотим изучить с помощью статистических методов. То есть первый этап: что изучаем? И какие у нас есть предположения относительно результата? Этот этап называется этап статистических гипотез.

- Второй этап – нужно определиться с тем, какие у нас есть в реальности данные для того, чтобы ответить на первый вопрос. Этот этап – тип данных.

- Третий этап состоит в том, чтобы выбрать корректный для применения в данной ситуации статистический критерий.

- Четвертый этап это логичный этап применения интерпретации любой формулы, какие результаты мы получили.

- Пятый этап это создание, синтез выводов относительно первого, второго, третьего, четвертого, пятого этапа, то есть что же получили и что же это в реальности значит.

Предлагаю долго не ходить вокруг да около и посмотреть применение t-критерия Стьюдента на реальном примере.

Видео-версия статьи

Пример использования т-критерия Стьюдента

А пример будет достаточно простой: мне интересно, стали ли люди выше за последние 100 лет. Для этого нужно подобрать некоторые данные. Я обнаружил интересную информацию в достаточно известной статье The Guardian (Tall story’s men and women have grown taller over last century, Study Shows (The Guardian, July 2016), которая сравнивает средний возраст человека в разных странах в 1914 году и в аналогичных странах в 2014 году.

Там приведены данные практически по всем государствам. Однако, я взял лишь 5 стран для простоты вычислений: это Россия, Германия, Китай, США и ЮАР, соответственно 1914 год и 2014 год.

Общее количество наблюдений – 5 в 1914 году в группе 1914 года и общее значение также 5 в 2014 году. Будем думать опять же для простоты, что эти данные сопоставимы, и с ними можно работать.

Дальше нужно выбрать критерии – критерии, по которым мы будем давать ответ. Равны ли средние по росту в 1914 году x̅1914 и в 2014 году x̅2014. Я считаю, что нет. Поэтому моя гипотеза это то, что они не равны (x̅1914≠x̅2014). Соответственно альтернативная гипотеза моему предположению, так называемая нулевая гипотеза (нулевая гипотеза консервативна, обратная вашей, часто говорит об отсутствии статистически значимых связей/зависимостей) будет говорить о том, что они между собой на самом деле равны (x̅1914=x̅2014), то есть о том, что все эти находки случайны, и я, по сути, не прав.

Теперь нужно дать какой-то аргументированный ответ. Даем его с помощью статистического критерия. Соответственно теперь наступает самое важное: как выбрать статистический критерий? Я думаю, это будет темой отдельной статьи. Для корректности использования t-критерия Стьюдента лишь скажу, что нужно, чтобы:

Условия применения статистического критерия т-теста (критерия Стьюдента)

— данные распределялись по закону нормального распределения;

— данные были количественными;

— и это две независимые между собой выборки (независимые это значит, что в этих группах разные люди, а никак, например, до и после применения препарата у одной группы, люди должны быть разными, тогда группы являются несвязанными, либо независимыми), этот аспект стоит учитывать для выбора вида т-критерия Стьюдента, так как для парных выборок существует свой парный т-критерий (paired t-test).

В итоге Мы определились с тем, что это будет t-критерий Стьюдента.

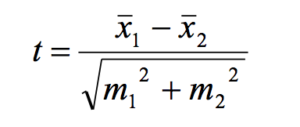

Формула t-критерия Стьюдента достаточно простая. Она гласит о том, что в числителе у нас разница средних, в знаменателе у нас корень квадратный суммы ошибок репрезентативности по этим группам:

Ошибки репрезентативности были подробно объяснены мною в статье по доверительным интервалам. Поэтому я рекомендую вам ознакомиться с ней, чтобы лучше разобраться, что такое ошибки репрезентативности, что такое выборка, как она соотносится с генеральной совокупностью.

Для того, чтобы не тратить время, я в принципе все уже рассчитал по каждой из групп: средняя (x̅) ,стандартное отклонение (SD) и ошибка репрезентативности (mr).

Давайте остановимся на том, что же значат эти значения:

— средняя (x̅) это среднеарифметическое по 5 наблюдениям в каждой группе;

— если совсем упрощать значение стандартного отклонения (SD), то можно сказать, что оно представляет собой обобщенную среднюю отклонения каждого значения от среднего (стандартное отклонение показывает, насколько широко значения рассеяны (разбросаны) относительно средней). И дальше мы находим нечто среднее отклонений каждого варианта в группе от среднего;

— и ошибка репрезентативности она тоже находится достаточно просто: это как раз наше отклонение от средней некоторое стандартизованное, поэтому стандартное отклонение на размер выборки (mr=).

Итак, продолжаем. В ходе подстановки каждого значения в нашу формулу, мы находим, что t-критерий Стьюдента равен 3,78. Однако, я думаю, пока тем, кто не знаком со статистическими критериями, это мало о чем говорит.

Итак, теперь настает четвертый этап вопрос интерпретации. Ранее мы получили значение t-критерия в 3,78. Однако, что же это значит? Стоит отметить, что результаты статистических критериев и вообще их интерпретация не говорит о точном «да», либо «нет» в выводе, то есть рост отличается, либо рост не отличается. Всегда это вопрос определенной доли вероятности – доли вероятности ошибиться при констатации положительного результата (речь об ошибке первого рода (I type error, Alpha)). То есть, например, если мы скажем, что средний рост в начале ХХ и в начале XXI века отличаются с долей ошибкой меньше 5 %. Как раз эта величина в 5 % и фиксируется как достаточная для большинства биомедицинских исследований, помните, р больше, либо меньше 0,05.

Итак, как нам перейти от нашей t к р вероятности? Это сделать достаточно просто, стоит лишь воспользоваться табличными значениями t для определенных степеней свободы. Теперь вопрос: как найти эти степени свободы? Но это сделать достаточно просто. Для того, чтобы обнаружить степени свободы для наших групп, нужно лишь сложить количество наблюдений 5 и 5 в нашем случае и вычесть 2. В нашем случае степень свободы равна 8.

Итак, t=3,78, степень свободы равна 8. Переходим в табличное значение и получаем р вероятность – вероятность равна 0,005. То есть вероятность того, что мы ошибаемся при констатации факта различия роста ранее и сейчас, крайне мала – это 0,005 %, не 5 %, а 0,005 %. То есть мы можем говорить с высокой долей достоверности того, что наш рост сейчас в XXI веке и 100 лет назад отличаются.

Вот то, что касается расчета t-критерия Стьюдента и его интерпретации.

На этом наш разговор о t-критерии Стьюдента закончен. Спасибо, что ознакомились с этой статьей. Я очень надеюсь на вашу обратную связь. Пожалуйста, подписывайтесь на наш сайте, ставьте лайки, предлагайте свои темы для следующих выпусков. Спасибо большое за поддержку. С вами был Кирилл Мильчаков. Пока, до новых встреч!

Если Вам понравилась статья и оказалась полезной, Вы можете поделиться ею с коллегами и друзьями в социальных сетях: