Временные ряды в эконометрических исследованиях

Большинство

эконометрических моделей строится как

динамические эконометрические модели.

Это означает, что моделирование

причинно-следственных связей между

переменными осуществляется во времени,

а исходные данные представлены в форме

временных рядов.

Временной ряд хt

(t=1;n)

– ряд значений какого-либо показателя

за несколько последовательных промежутков

времени.

Каждый временной

ряд хt

складывается

из следующих основных составляющих

(компонентов):

1) Тенденции,

характеризующей общее направление

динамики изучаемого явления. Аналитически

тенденция выражается некоторой функцией

времени, называемой трендом (Т).

2) Циклической или

периодической составляющей, характеризующей

циклические или периодические колебания

изучаемого явления. Колебания представляют

собой отклонения фактических уровней

ряда от тренда. Объем продаж некоторых

товаров подвержен сезонным колебаниям.

Сезонные

колебания

(S)

–

периодические колебания, которые имеют

определенный и постоянный период равный

годовому промежутку. Конъюнктурные

колебания (К)

связаны с большими экономическими

циклами, период таких колебаний –

несколько лет.

3) Случайной

составляющей, которая является результатом

воздействия множества случайных факторов

(Е).

Тогда уровень ряда

можно представить как функцию от этих

составляющих (компонентов):

=f(T,

K, S, E).

В зависимости от

взаимосвязи между составляющими может

быть построена либо аддитивная модель:

=T+K+S+E,

либо мультипликативная модель:=T·K·S·E

ряда динамики.

Для определения

состава компонентов (структуры временного

ряда) в

модели временного ряда строят

автокорреляционную функцию.

Автокорреляция

– корреляционная

связь между последовательными уровнями

одного и того же ряда динамики (сдвинутыми

на определенный промежуток времени L

— лаг). То есть, автокорреляция — это связь

между рядом: x1,

x2,

… xn-l

и рядом x1+l,

x2+l,

…,xn,

где L—

положительное целое число. Автокорреляция

может быть измерена коэффициентом

автокорреляции:

,

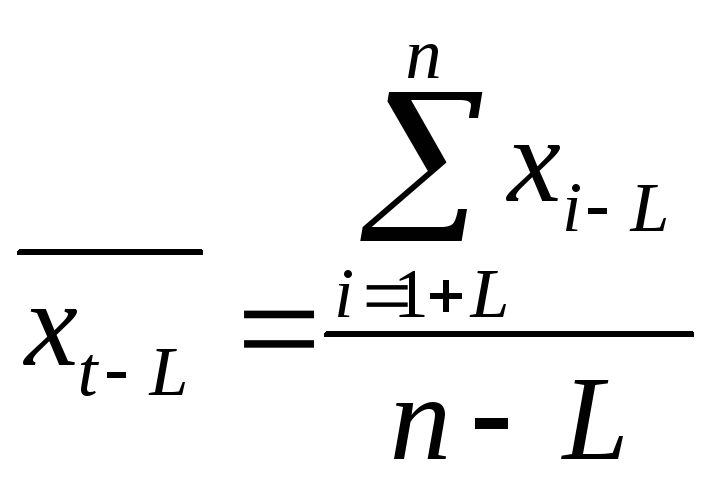

где

ряда (x1+L,

x2+L,…,

xn

),

ряда (x1,

x2,…,

xn-L

),

t

, t-L

– средние квадратические отклонения,

для рядов (x1+L,

x2+L,…,

xn

) и (x1,

x2,…,

xn-L

) соответственно.

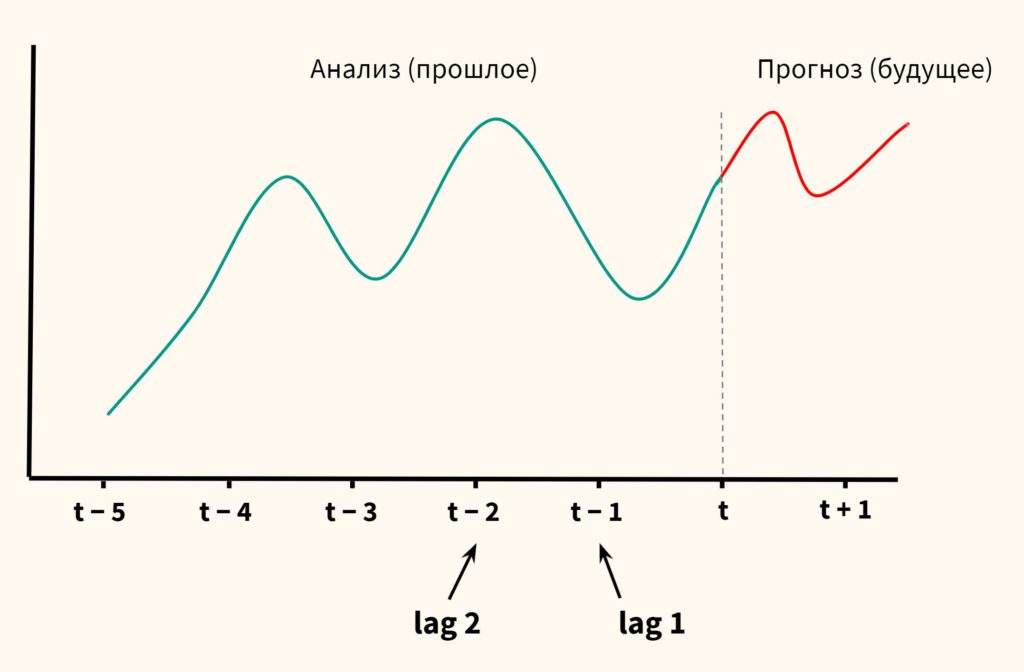

Лаг (сдвиг во

времени) определяет порядок коэффициента

автокорреляции. Если L=1,

то имеем коэффициент автокорреляции

1-ого порядка rt,t-1,

если L=2,

то коэффициент автокорреляции 2-ого

порядка

rt,t-2

и т.д.

Следует учитывать, что с увеличением

лага на единицу, число пар значений, по

которым рассчитывается коэффициент

автокорреляции уменьшается на 1. Поэтому

обычно рекомендуют максимальный порядок

коэффициента автокорреляции равный

n/4.

Рассчитав несколько

коэффициентов автокорреляции, можно

определить лаг (L),

при котором автокорреляция (rt,t-L)

наиболее высокая, выявив тем самым

структуру

временного ряда.

Если наиболее высоким оказывается

значение rt,t-1,

то исследуемый ряд содержит только

тенденцию. Если наиболее высоким оказался

rt,t-L,

то ряд содержит колебания периодом L.

Если ни один из rt,t-L

не является

значимым, можно сделать одно из двух

предположений:

— либо ряд не

содержит тенденции и циклических

колебаний, а его уровень определяется

только случайной компонентой;

— либо ряд содержит

сильную нелинейную тенденцию, для

выявления которой нужно провести

дополнительный анализ.

Последовательность

коэффициентов автокорреляции 1, 2 и т.д.

порядков называют автокорреляционной

функцией временного ряда. График

зависимости значений коэффициентов

автокорреляции от величины лага (порядка

коэффициента автокорреляции) называют

коррелограммой.

Для выявления

закономерных колебаний внутри года при

выполнении контрольной работы

рекомендуется рассчитывать не меньше

4-х уровней коэффициентов автокорреляции.

Рассмотрим на

примере как построить коррелограмму,

чтобы определяется структуру временного

ряда.

Пусть нам даны

поквартальные данные

об объеме выпуска некоторого товара

некоторой фирмой –х

(усл.ед.) за 3 года:

|

1993 |

1994 |

1995 |

|||||||||

|

1 |

2 |

3 |

4 |

1 |

2 |

3 |

4 |

1 |

2 |

3 |

4 |

|

410 |

560 |

715 |

500 |

520 |

740 |

975 |

670 |

705 |

950 |

1200 |

900 |

Чтобы построить

коррелогорамму для нашего примера,

исходный ряд динамики дополним рядами

из уровней этого ряда, сдвинутыми во

времени (таблица 6).

Таблица 6

|

t |

1 |

2 |

3 |

4 |

5 |

6 |

7 |

8 |

9 |

10 |

11 |

12 |

|

|

хt |

— |

560 |

715 |

500 |

520 |

740 |

975 |

670 |

705 |

950 |

1200 |

900 |

rt,t-1=0,537 |

|

xt-1 |

— |

410 |

560 |

715 |

500 |

520 |

740 |

975 |

670 |

705 |

950 |

1200 |

|

|

хt |

— |

— |

715 |

500 |

520 |

740 |

975 |

670 |

705 |

950 |

1200 |

900 |

rt,t-2=0,085 |

|

хt-2 |

— |

— |

410 |

560 |

715 |

500 |

520 |

740 |

975 |

670 |

705 |

950 |

|

|

хt |

— |

— |

— |

500 |

520 |

740 |

975 |

670 |

705 |

950 |

1200 |

900 |

rt,t-3=0,445 |

|

хt-3 |

— |

— |

— |

410 |

560 |

715 |

500 |

520 |

740 |

975 |

670 |

705 |

|

|

хt |

— |

— |

— |

— |

520 |

740 |

975 |

670 |

705 |

950 |

1200 |

900 |

rt,t-4=0,990 |

|

хt-4 |

— |

— |

— |

— |

410 |

560 |

715 |

500 |

520 |

740 |

975 |

670 |

|

|

хt |

— |

— |

— |

— |

— |

740 |

975 |

670 |

705 |

950 |

1200 |

900 |

rt,t-5=0,294 |

|

хt-5 |

— |

— |

— |

— |

— |

410 |

560 |

715 |

500 |

520 |

740 |

975 |

Рассчитаем

коэффициенты корреляции:

1-ого порядка для

рядов хt

и хt-1,

2-ого порядка для

рядов хt

и хt-2,

3-его порядка для

рядов хt

и хt-3,

4-ого порядка для

рядов хt

и хt-4,

5-ого порядка для

рядов хt

и хt-5

Результаты

расчетов представлены в таблице 7.

Таблица 7

|

Лаг |

rt,t-L |

Коррелограмма |

|

1 |

0,537 |

**** |

|

2 |

0,085 |

* |

|

3 |

0,445 |

*** |

|

4 |

0,990 |

***** |

|

5 |

0,294 |

** |

Вывод: в данном

ряду динамики имеется тенденция (т.к.

rt,t-1=0,537

→1) и периодические колебания с периодом

(L)

равным 4, т.е. имеют место сезонные

колебания (т.к. rt,t-4=0,99

→1).

Построение

модели временного ряда с сезонными

колебаниями (аддитивная модель).

Процесс построения

модели временного ряда (х),

содержащего n

уровней

некоторого показателя за Z

лет, с L

сезонными колебаниями включает следующие

шаги:

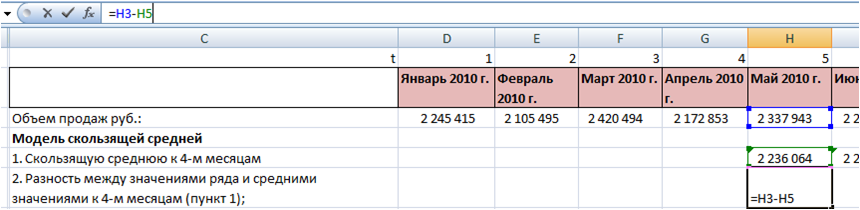

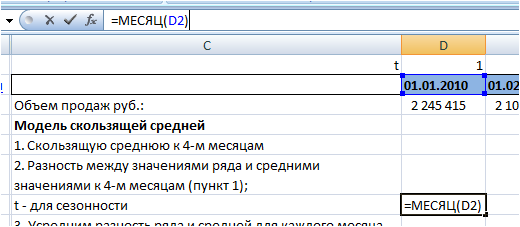

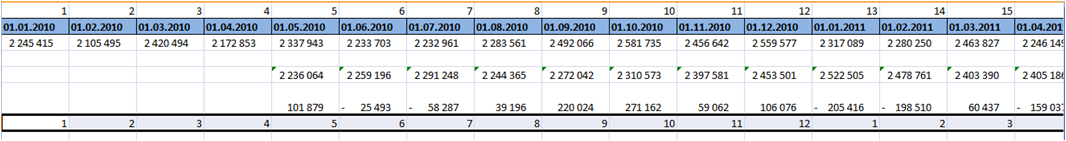

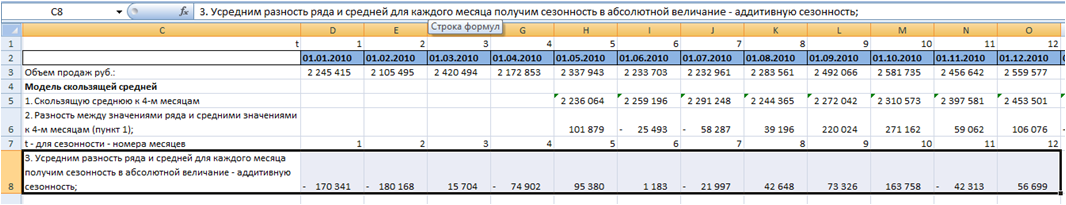

1) Выравнивание

исходного ряда методом скользящей

средней

(хc).

Произведем выравнивание исходного ряда

взятого из примера, рассмотренного

выше, методом скользящей средней с

периодом усреднения равным 3. Результаты

представлены в таблице 9 (столбец 4).

2) Расчет

значений сезонной составляющей

Si,

i=1;L,

где L–

число сезонов в году. Для нашего примера

L=4

(сезоны — кварталы).

Расчет значений

сезонных составляющих осуществляется

после устранения тенденции из исходных

уровней ряда: x

—

xc

(столбец 5,

таблица 9). Для дальнейшего расчета Si

построим отдельную таблицу. Строки

данной таблицы соответствуют сезонам,

столбцы — годам. В теле таблицы находятся

значения: x

—

xc.

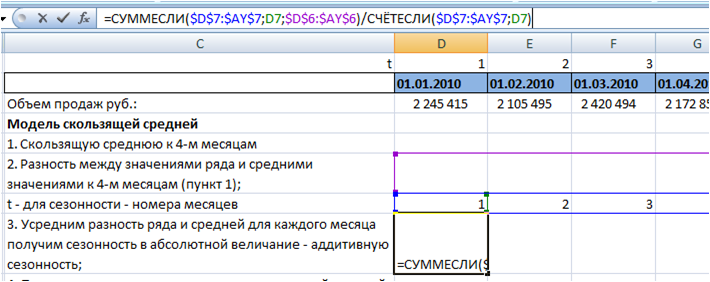

По этим данным рассчитываются средние

оценки сезонных составляющих каждой

строке (Sci).

Если сумма всех средних оценок равна

нулю (),

то данные средние и будут окончательными

значениями сезонных составляющих

(Si=Sci).

Если их сумма не равна нулю, то

рассчитываются скорректированные

значения сезонных составляющих вычитанием

из средней оценки величины равной

отношению суммы средних оценок к их

общему числу (

Для нашего примера расчет значений Si

представлен в таблице 8.

Таблица 8

|

Номер |

Год |

Год |

Год |

Средняя |

Скорректированная |

|

1 |

— |

-66,67 |

-70,00 |

-68,33 |

-67,15 |

|

2 |

-1,67 |

-5,00 |

-1,67 |

-2,78 |

-1,60 |

|

3 |

123,33 |

180,00 |

183,33 |

162,22 |

163,40 |

|

4 |

-78,33 |

-113,33 |

— |

-95,83 |

-94,66 |

|

Итого |

-4,72 |

0 |

3) Устранение

влияния сезонной составляющей из

исходного ряда динамики :

xS

= x—Si.

Результаты расчета xS

для нашего примера представлены в

столбце 6 таблицы 9.

4) Аналитическое

выравнивание уровней

xS

(построение тренда):

.

Расчет параметров

при аналитическом выравнивании чаще

всего производится с помощью метода

наименьших квадратов (МНК). При этом

поиск параметров для линейного уравнения

тренда можно упростить, если отсчет

времени производить так, чтобы сумма

показателей времени изучаемого ряда

динамики была равна нулю. Для этого

вводится новая условная переменная

времени ty,

такая, что ty

=0. Уравнение тренда при этом будет

следующим:

.

При нечетном числе

уровней ряда динамики для получения

ty=0

уровень, находящийся в середине ряда,

принимается за условное начало отсчета

времени (периоду или моменту времени,

соответствующему данному уровню

присваивается нулевое значение). Даты

времени, расположенные левее этого

уровня, обозначаются натуральными

числами со знаком минус (-1 –2 –3 …), а

даты времени, расположенные правее

этого уровня – натуральными числами

со знаком плюс (1 2 3 …).

Если число уровней

ряда четное, периоды времени левой

половины ряда (до середины) нумеруются

–1, -3, -5 и т.д. А периоды правой половины

— +1, +3, +5 и.т.д. При этом ty

будет равна 0.

Система нормальных

уравнений (соответствующих МНК)

преобразуется к виду:

Отсюда параметры

уравнения рассчитываются по формулам:

Интерпретация

параметров линейного уравнения тренда

:

—

уровень ряда за период времени tу=0;

—

средний абсолютный прирост уровня ряда

за единичный промежуток времени.

В нашем примере

четное число уровней ряда: n=12. Следовательно,

условная переменная времени для 6-ого

элемента ряда будет равна –1, а для 7-ого

+1. Значения переменной iy

содержатся во 2-ом столбце таблицы 9.

Параметры линейного

тренда будут:

=14257,5/572=24,93;

=8845/12=737,08.

Это значит, что с каждым кварталом объем

выпуска товара в среднем увеличивается

на 2∙28,7 усл.ед. А средний за период с

1993 по 1995гг объем выпуска составил 738,75

усл.ед.

Рассчитаем значения

трендовой компоненты по формуле

(столбец 7

таблицы 9).

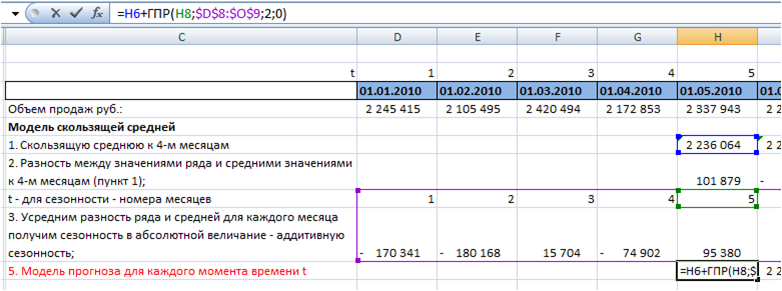

5) Учет сезонной

составляющей в выровненных уровнях

ряда (=T+S).

Результаты расчета для нашего примера

представлены в столбце 8 таблицы 9.

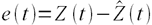

6) Расчет абсолютной

ошибки

временного ряда (Е=x—)

осуществляется для оценки качества

полученной модели. Результаты расчета

для нашего примера представлены в

столбце 9 таблицы 9.

Таблица 9

|

T |

tу |

x |

xc |

x- |

xs |

T |

|

E |

|

1 |

2 |

3 |

4 |

5 |

6 |

7 |

8 |

9 |

|

1 |

-11 |

410 |

— |

— |

477,15 |

462,90 |

395,75 |

14,25 |

|

2 |

-9 |

560 |

561,67 |

-1,67 |

561,60 |

512,75 |

511,15 |

48,85 |

|

3 |

-7 |

715 |

591,67 |

123,33 |

551,60 |

562,60 |

726,00 |

-11,01 |

|

4 |

-5 |

500 |

578,33 |

-78,33 |

594,65 |

612,45 |

517,80 |

-17,80 |

|

5 |

-3 |

520 |

586,67 |

-66,67 |

587,15 |

662,31 |

595,15 |

-75,15 |

|

6 |

-1 |

740 |

745,00 |

-5,00 |

741,60 |

712,16 |

710,56 |

29,44 |

|

7 |

1 |

975 |

795,00 |

180,00 |

811,60 |

762,00 |

925,41 |

49,59 |

|

8 |

3 |

670 |

783,33 |

-113,33 |

764,65 |

811,86 |

717,21 |

-47,21 |

|

9 |

5 |

705 |

775,00 |

-70,00 |

772,15 |

861,71 |

794,56 |

-89,56 |

|

10 |

7 |

950 |

951,67 |

-1,67 |

951,60 |

911,56 |

909,97 |

40,03 |

|

11 |

9 |

1200 |

1016,67 |

183,33 |

1036,60 |

961,41 |

1124,82 |

75,18 |

|

12 |

11 |

900 |

— |

— |

994,65 |

1011,27 |

916,61 |

-16,61 |

|

Итого |

8845 |

8845,00 |

8845,00 |

8845,00 |

16,61 |

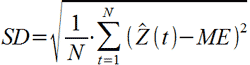

Значимость

параметров линейного уравнения тренда

(Т)

определяется на основе t-критерия

Стьюдента также как и в линейном парном

регрессионном анализе.

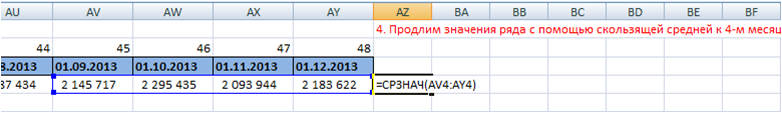

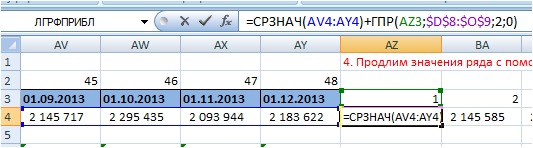

Прогнозирование

по аддитивной модели.

Пусть требуется

дать прогноз уровня временного ряда на

период (n+1).

Точечный прогноз значения уровня

временного ряда хn+1

в аддитивной модели есть сумма трендовой

компоненты и сезонной компоненты

(соответствующей i–ому

сезону прогноза):

=Tn+1+Si.

Для построения

доверительного интервала прогноза

нужно рассчитать среднюю ошибку прогноза:

р

=

где h—

число параметров в уравнении тренда;

typ

– значение условной переменной времени

для периода прогнозирования.

Затем рассчитаем

предельную ошибку прогноза: р

=ta·р,

где ta—

коэффициент доверия, определяемый по

таблицам Стьюдента по уровню значимости

α и числу степеней свободы равным (n—h).

Окончательно

получим: (-р;

+р).

Задание №

4

На

основе данных, приведенных в таблице

10 и соответствующих Вашему варианту

(таблица 11), постройте модель временного

ряда. Для этого требуется:

-

Построить

коррелограмму и определить имеет ли

ряд тенденцию и сезонные колебания. -

Провести сглаживание

ряда скользящей средней и рассчитать

значения сезонной составляющей. -

Построить уравнения

тренда и сделать выводы. -

На основе полученной

модели сделать прогноз на следующие

два квартала с учетом выявленной

сезонности.

Таблица 10

Основные показатели

развития производственной фирмы

за период с 2002 по

2007 гг. (по сопоставимой оценке)

|

N |

Год |

Квартал |

Объем |

Среднегодовая |

Среднегодовая |

Дебиторская |

Среднегодовая |

Балансовая руб. |

Чистая руб. |

|

А |

Б |

В |

1 |

2 |

3 |

4 |

5 |

6 |

7 |

|

1 |

2002 |

1 |

1065 |

1062 |

713 |

25 |

837 |

94 |

36 |

|

2 |

2 |

851 |

682 |

507 |

27 |

685 |

78 |

27 |

|

|

3 |

3 |

531 |

726 |

361 |

34 |

837 |

87 |

22 |

|

|

4 |

4 |

922 |

1153 |

557 |

44 |

1161 |

75 |

29 |

|

|

5 |

2003 |

1 |

1095 |

1213 |

607 |

42 |

1151 |

84 |

34 |

|

6 |

2 |

986 |

898 |

598 |

39 |

822 |

63 |

28 |

|

|

7 |

3 |

822 |

794 |

368 |

48 |

1383 |

86 |

30 |

|

|

8 |

4 |

1137 |

1441 |

646 |

60 |

884 |

82 |

35 |

|

|

9 |

2004 |

1 |

1301 |

1600 |

693 |

63 |

1309 |

78 |

40 |

|

10 |

2 |

1038 |

967 |

718 |

40 |

1028 |

72 |

33 |

|

|

11 |

3 |

780 |

1246 |

363 |

48 |

1771 |

84 |

33 |

|

|

12 |

4 |

1435 |

1458 |

639 |

71 |

1310 |

102 |

40 |

|

|

13 |

2005 |

1 |

1593 |

1412 |

708 |

87 |

1372 |

112 |

36 |

|

14 |

2 |

1658 |

891 |

614 |

65 |

1272 |

92 |

27 |

|

|

15 |

3 |

1363 |

1061 |

348 |

67 |

1821 |

99 |

30 |

|

|

16 |

4 |

1737 |

1287 |

636 |

76 |

1571 |

113 |

36 |

|

|

17 |

2006 |

1 |

1719 |

1635 |

825 |

101 |

1758 |

95 |

36 |

|

18 |

2 |

1521 |

1166 |

622 |

84 |

1505 |

79 |

28 |

|

|

19 |

3 |

1049 |

1230 |

514 |

73 |

2109 |

112 |

28 |

|

|

20 |

4 |

1790 |

1514 |

703 |

93 |

1787 |

116 |

28 |

|

|

21 |

2007 |

1 |

2016 |

1642 |

797 |

96 |

2197 |

90 |

39 |

Таблица 11

Номера наблюдений

и показатель,

соответствующие

варианту контрольной работы

|

Номер |

Номер |

Номер |

Номер |

Номер |

Номер |

Номер |

Номер |

|

1 |

2 |

3 |

4 |

5 |

6 |

7 |

8 |

|

1 |

1 |

12 |

1 |

51 |

1 |

12 |

6 |

|

2 |

2 |

13 |

1 |

52 |

2 |

13 |

6 |

|

3 |

3 |

14 |

1 |

53 |

3 |

14 |

6 |

|

4 |

4 |

15 |

1 |

54 |

4 |

15 |

6 |

|

5 |

5 |

16 |

1 |

55 |

5 |

16 |

6 |

|

6 |

6 |

17 |

1 |

56 |

6 |

17 |

6 |

|

7 |

7 |

18 |

1 |

57 |

7 |

18 |

6 |

|

8 |

8 |

19 |

1 |

58 |

8 |

19 |

6 |

|

9 |

9 |

20 |

1 |

59 |

9 |

20 |

6 |

|

10 |

10 |

21 |

1 |

60 |

10 |

21 |

6 |

|

11 |

1 |

12 |

2 |

61 |

1 |

12 |

7 |

|

12 |

2 |

13 |

2 |

62 |

2 |

13 |

7 |

|

13 |

3 |

14 |

2 |

63 |

3 |

14 |

7 |

|

14 |

4 |

15 |

2 |

64 |

4 |

15 |

7 |

|

15 |

5 |

16 |

2 |

65 |

5 |

16 |

7 |

|

16 |

6 |

17 |

2 |

66 |

6 |

17 |

7 |

|

17 |

7 |

18 |

2 |

67 |

7 |

18 |

7 |

|

18 |

8 |

19 |

2 |

68 |

8 |

19 |

7 |

|

19 |

9 |

20 |

2 |

69 |

9 |

20 |

7 |

|

20 |

10 |

21 |

2 |

70 |

10 |

21 |

7 |

|

21 |

1 |

12 |

3 |

71 |

1 |

12 |

1 |

|

22 |

2 |

13 |

3 |

72 |

2 |

13 |

2 |

|

23 |

3 |

14 |

3 |

73 |

3 |

14 |

3 |

|

24 |

4 |

15 |

3 |

74 |

4 |

15 |

4 |

|

25 |

5 |

16 |

3 |

75 |

5 |

16 |

5 |

|

26 |

6 |

17 |

3 |

76 |

6 |

17 |

6 |

|

27 |

7 |

18 |

3 |

77 |

7 |

18 |

7 |

|

28 |

8 |

19 |

3 |

78 |

8 |

19 |

1 |

|

29 |

9 |

20 |

3 |

79 |

9 |

20 |

2 |

|

30 |

10 |

21 |

3 |

80 |

10 |

21 |

3 |

|

31 |

1 |

12 |

4 |

81 |

1 |

12 |

4 |

|

32 |

2 |

13 |

4 |

82 |

2 |

13 |

5 |

|

33 |

3 |

14 |

4 |

83 |

3 |

14 |

6 |

|

34 |

4 |

15 |

4 |

84 |

4 |

15 |

7 |

|

35 |

5 |

16 |

4 |

85 |

5 |

16 |

1 |

|

36 |

6 |

17 |

4 |

86 |

6 |

17 |

2 |

Окончание табл.

11

|

1 |

2 |

3 |

4 |

5 |

6 |

7 |

8 |

|

37 |

7 |

18 |

4 |

87 |

7 |

18 |

3 |

|

38 |

8 |

19 |

4 |

88 |

8 |

19 |

4 |

|

39 |

9 |

20 |

4 |

89 |

9 |

20 |

5 |

|

40 |

10 |

21 |

4 |

90 |

10 |

21 |

6 |

|

41 |

1 |

12 |

5 |

91 |

1 |

12 |

7 |

|

42 |

2 |

13 |

5 |

92 |

2 |

13 |

1 |

|

43 |

3 |

14 |

5 |

93 |

3 |

14 |

2 |

|

44 |

4 |

15 |

5 |

94 |

4 |

15 |

3 |

|

45 |

5 |

16 |

5 |

95 |

5 |

16 |

4 |

|

46 |

6 |

17 |

5 |

96 |

6 |

17 |

5 |

|

47 |

7 |

18 |

5 |

97 |

7 |

18 |

6 |

|

48 |

8 |

19 |

5 |

98 |

8 |

19 |

7 |

|

49 |

9 |

20 |

5 |

99 |

9 |

20 |

1 |

|

50 |

10 |

21 |

5 |

0 |

10 |

21 |

2 |

Соседние файлы в папке Эконометрика (Задание)

- #

13.02.2015139.26 Кб67_318_эконометрика.xls

- #

- #

- #

13.02.201512.54 Mб12Практикум по эконометрике — Елисеева И.И..pdf

Анализ временных рядов

- Общее введение

- Две основные цели

- Идентификация модели

временных рядов- Систематическая

составляющая и случайный шум - Два общих типа компонент

временных рядов - Анализ тренда

- Анализ сезонности

- Систематическая

- АРПСС (Бокс и Дженкинс) и

автокорреляции- Общее введение

- Два основных процесса

- Модель АРПСС

- Идентификация

- Оценивание параметров

- Оценивание модели

- Прерванные временные ряды

- Экспоненциальное

сглаживание- Общее введение

- Простое экспоненциальное

сглаживание - Выбор лучшего значения

параметра a (альфа) - Индексы качества подгонки

- Сезонная и несезонная модели

с трендом или без тренда

- Сезонная декомпозиция (метод

Census I)- Общее введение

- Вычисления

- Сезонная корректировка X-11

(метод Census II)- Сезонная корректировка:

основные идеи и термины - Метод Census II

- Таблицы результатов

корректировки X-11 - Подробное описание всех

таблиц результатов, вычисляемых в методе X-11

- Сезонная корректировка:

- Анализ распределенных лагов

- Общая цель

- Общая модель

- Распределенный лаг Алмона

- Одномерный анализ Фурье

- Кросс-спектральный анализ

- Общее введение

- Основные понятия и принципы

- Результаты для каждой

переменной - Кросс-периодограмма,

кросс-плотность, квадратурная плотность и

кросс-амплитуда - Квадрат когерентности,

усиление и фазовый сдвиг - Как создавались данные для

примера

- Спектральный анализ —

Основные понятия и принципы- Частота и период

- Общая структура модели

- Простой пример

- Периодограмма

- Проблема рассеяния

- Добавление констант во

временной ряд (пэддинг) - Косинус-сглаживание

- Окна данных и оценки

спектральной плотности - Подготовка данных к анализу

- Результаты для случая, когда в

ряде отсутствует периодичность

- Быстрое преобразование Фурье

- Общее введение

- Вычисление БПФ во временных

рядах

В следующих разделах мы вначале представим

обзор методов, используемых для идентификации

моделей временных рядов (таких как сглаживание,

подгонка и автокорреляции). Затем опишем общий

класс моделей, которые могут быть использованы

для описания рядов и построения прогнозов

(модели авторегрессии и скользящего среднего).

Наконец, расскажем о некоторых простых, но часто

используемых методах, основанных на линейной

регрессии. За дальнейшей информацией обратитесь

к соответствующим разделам.

Общее введение

Вначале дадим краткий обзор методов анализа

данных, представленных в виде временных рядов,

т.е. в виде последовательностей измерений,

упорядоченных в неслучайные моменты времени. В

отличие от анализа случайных выборок, анализ

временных рядов основывается на предположении,

что последовательные значения в файле данных

наблюдаются через равные промежутки времени

(тогда как в других методах нам не важна и часто

не интересна привязка наблюдений ко времени).

Подробное обсуждение этих методов можно найти

в следующих работах: Anderson (1976), Бокс и Дженкинс

(1976), Kendall (1984), Kendall and Ord (1990), Montgomery, Johnson, and Gardiner (1990),

Pankratz (1983), Shumway (1988), Vandaele (1983), Walker (1991), Wei (1989).

Две основные цели

Существуют две основные цели анализа временных

рядов: (1) определение природы ряда и (2)

прогнозирование (предсказание будущих значений

временного ряда по настоящим и прошлым

значениям). Обе эти цели требуют, чтобы модель

ряда была идентифицирована и, более или менее,

формально описана. Как только модель определена,

вы можете с ее помощью интерпретировать

рассматриваемые данные (например, использовать в

вашей теории для понимания сезонного изменения

цен на товары, если занимаетесь экономикой). Не

обращая внимания на глубину понимания и

справедливость теории, вы можете

экстраполировать затем ряд на основе найденной

модели, т.е. предсказать его будущие значения.

Идентификация модели временных

рядов

- Систематическая

составляющая и случайный шум - Два общих типа компонент

временных рядов - Анализ тренда

- Анализ сезонности

За более полной информацией о простых

автокорреляциях (обсуждаемых в этом разделе) и

других автокорреляциях, см. Anderson (1976), Box and Jenkins

(1976), Kendall (1984), Pankratz (1983), and Vandaele (1983). См. также:

- АРПСС (Бокс и Дженкинс) и

автокорреляции - Прерванные временные ряды

- Экспоненциальное

сглаживание - Сезонная декомпозиция (метод

Census I) - Сезонная корректировка X-11

(метод Census II) - Таблицы результатов

корректировки X-11 - Анализ распределенных лагов

- Одномерный анализ Фурье

- Кросс-спектральный анализ

- Основные понятия и принципы

- Быстрое преобразование Фурье

Систематическая составляющая и

случайный шум

Как и большинство других видов анализа, анализ

временных рядов предполагает, что данные

содержат систематическую составляющую (обычно

включающую несколько компонент) и случайный шум

(ошибку), который затрудняет обнаружение

регулярных компонент. Большинство методов

исследования временных рядов включает различные

способы фильтрации шума, позволяющие увидеть

регулярную составляющую более отчетливо.

Два общих типа компонент

временных рядов

Большинство регулярных составляющих временных

рядов принадлежит к двум классам: они являются

либо трендом, либо сезонной составляющей. Тренд

представляет собой общую систематическую

линейную или нелинейную компоненту, которая

может изменяться во времени. Сезонная

составляющая — это периодически повторяющаяся

компонента. Оба эти вида регулярных компонент

часто присутствуют в ряде одновременно.

Например, продажи компании могут возрастать из

года в год, но они также содержат сезонную

составляющую (как правило, 25% годовых продаж

приходится на декабрь и только 4% на август).

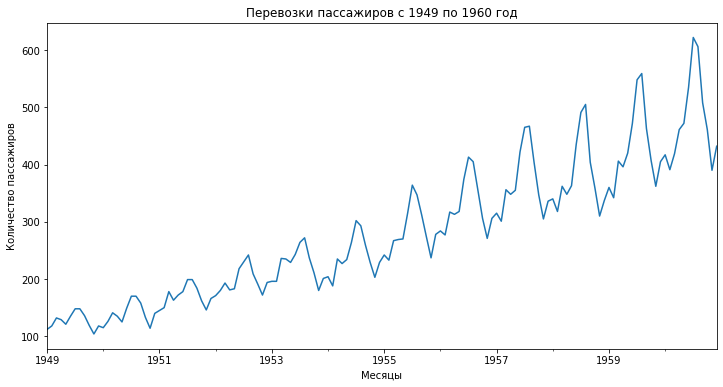

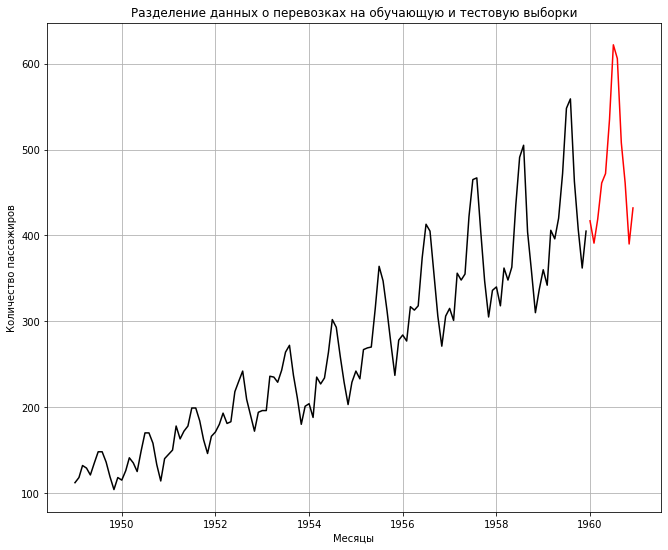

Эту общую модель можно понять на

«классическом» ряде — Ряд G (Бокс и

Дженкинс, 1976, стр. 531), представляющем месячные

международные авиаперевозки (в тысячах) в

течение 12 лет с 1949 по 1960 (см. файл Series_g.sta).

График месячных перевозок ясно показывает почти

линейный тренд, т.е. имеется устойчивый рост

перевозок из года в год (примерно в 4 раза больше

пассажиров перевезено в 1960 году, чем в 1949). В то же

время характер месячных перевозок повторяется,

они имеют почти один и тот же характер в каждом

годовом периоде (например, перевозок больше в

отпускные периоды, чем в другие месяцы). Этот

пример показывает довольно определенный тип

модели временного ряда, в которой амплитуда

сезонных изменений увеличивается вместе с

трендом. Такого рода модели называются моделями

с мультипликативной сезонностью.

Анализ тренда

Не существует «автоматического» способа

обнаружения тренда в временном ряде. Однако если

тренд является монотонным (устойчиво возрастает

или устойчиво убывает), то анализировать такой

ряд обычно нетрудно. Если временные ряды

содержат значительную ошибку, то первым шагом

выделения тренда является сглаживание.

Сглаживание. Сглаживание всегда включает

некоторый способ локального усреднения данных,

при котором несистематические компоненты

взаимно погашают друг друга. Самый общий метод

сглаживания — скользящее среднее, в котором

каждый член ряда заменяется простым или

взвешенным средним n соседних членов, где n

— ширина «окна» (см. Бокс и Дженкинс, 1976; Velleman

and Hoaglin, 1981). Вместо среднего можно использовать

медиану значений, попавших в окно. Основное

преимущество медианного сглаживания, в

сравнении со сглаживанием скользящим средним,

состоит в том, что результаты становятся более

устойчивыми к выбросам (имеющимся внутри окна).

Таким образом, если в данных имеются выбросы

(связанные, например, с ошибками измерений), то

сглаживание медианой обычно приводит к более

гладким или, по крайней мере, более

«надежным» кривым, по сравнению со

скользящим средним с тем же самым окном. Основной

недостаток медианного сглаживания в том, что при

отсутствии явных выбросов, он приводит к более

«зубчатым» кривым (чем сглаживание

скользящим средним) и не позволяет использовать

веса.

Относительно реже, когда ошибка измерения

очень большая, используется метод сглаживания

методом наименьших квадратов, взвешенных

относительно расстояния или метод отрицательного

экспоненциально взвешенного сглаживания. Все

эти методы отфильтровывают шум и преобразуют

данные в относительно гладкую кривую (см.

соответствующие разделы, где каждый из этих

методов описан более подробно). Ряды с

относительно небольшим количеством наблюдений и

систематическим расположением точек могут быть

сглажены с помощью бикубических сплайнов.

Подгонка функции. Многие монотонные

временные ряды можно хорошо приблизить линейной

функцией. Если же имеется явная монотонная

нелинейная компонента, то данные вначале следует

преобразовать, чтобы устранить нелинейность.

Обычно для этого используют логарифмическое,

экспоненциальное или (менее часто)

полиномиальное преобразование данных.

Анализ сезонности

Периодическая и сезонная зависимость

(сезонность) представляет собой другой общий тип

компонент временного ряда. Это понятие было

проиллюстрировано ранее на примере

авиаперевозок пассажиров. Можно легко видеть,

что каждое наблюдение очень похоже на соседнее;

дополнительно, имеется повторяющаяся сезонная

составляющая, это означает, что каждое

наблюдение также похоже на наблюдение, имевшееся

в том же самом месяце год назад. В общем,

периодическая зависимость может быть формально

определена как корреляционная зависимость

порядка k между каждым i-м элементом ряда и

(i-k)-м элементом (Kendall, 1976). Ее можно измерить с

помощью автокорреляции (т.е. корреляции между

самими членами ряда); k обычно называют лагом

(иногда используют эквивалентные термины:

сдвиг, запаздывание). Если ошибка измерения не

слишком большая, то сезонность можно определить

визуально, рассматривая поведение членов ряда

через каждые k временных единиц.

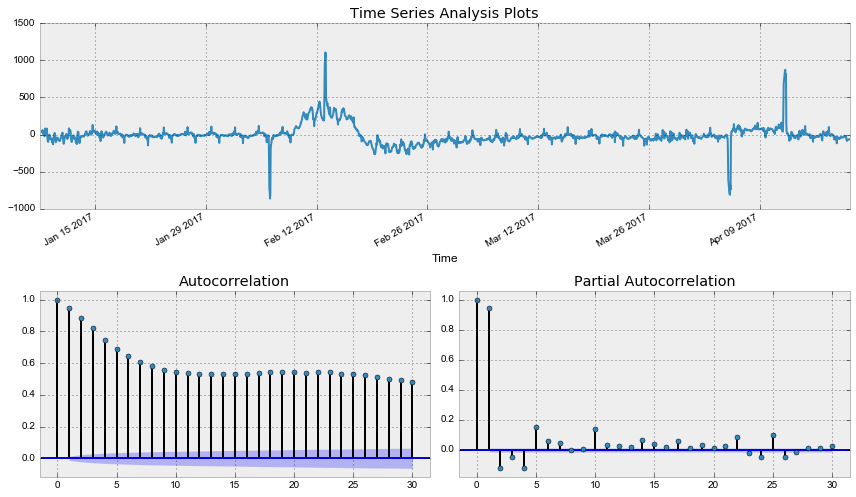

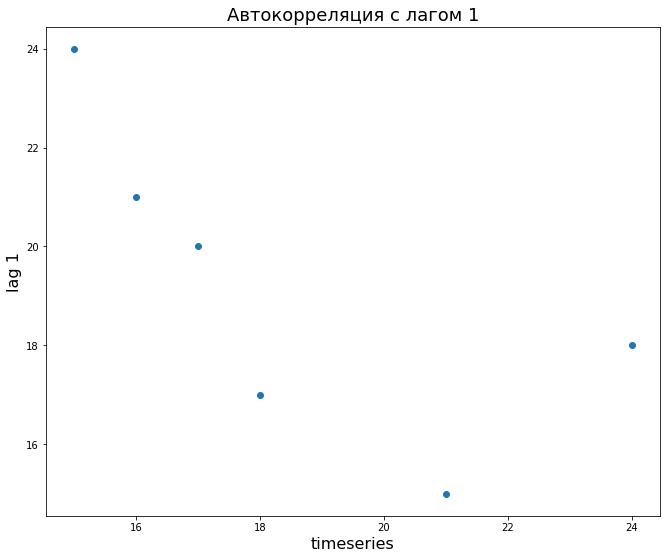

Автокорреляционная коррелограмма. Сезонные

составляющие временного ряда могут быть найдены

с помощью коррелограммы. Коррелограмма

(автокоррелограмма) показывает численно и

графически автокорреляционную функцию (AКФ),

иными словами коэффициенты автокорреляции (и их

стандартные ошибки) для последовательности

лагов из определенного диапазона (например, от 1

до 30). На коррелограмме обычно отмечается

диапазон в размере двух стандартных ошибок на

каждом лаге, однако обычно величина

автокорреляции более интересна, чем ее

надежность, потому что интерес в основном

представляют очень сильные (а, следовательно,

высоко значимые) автокорреляции (см. Элементарные

понятия статистики).

Исследование коррелограмм. При изучении

коррелограмм следует помнить, что

автокорреляции последовательных лагов

формально зависимы между собой. Рассмотрим

следующий пример. Если первый член ряда тесно

связан со вторым, а второй с третьим, то первый

элемент должен также каким-то образом зависеть

от третьего и т.д. Это приводит к тому, что

периодическая зависимость может существенно

измениться после удаления автокорреляций

первого порядка, т.е. после взятия разности с

лагом 1).

Частные автокорреляции. Другой полезный

метод исследования периодичности состоит в

исследовании частной автокорреляционной

функции (ЧАКФ), представляющей собой

углубление понятия обычной автокорреляционной

функции. В ЧАКФ устраняется зависимость между

промежуточными наблюдениями (наблюдениями внутри

лага). Другими словами, частная автокорреляция на

данном лаге аналогична обычной автокорреляции,

за исключением того, что при вычислении из нее

удаляется влияние автокорреляций с меньшими

лагами (см. Бокс и Дженкинс, 1976; см. также McDowall,

McCleary, Meidinger, and Hay, 1980). На лаге 1 (когда нет

промежуточных элементов внутри лага), частная

автокорреляция равна, очевидно, обычной

автокорреляции. На самом деле, частная

автокорреляция дает более «чистую» картину

периодических зависимостей.

Удаление периодической зависимости. Как

отмечалось выше, периодическая составляющая для

данного лага k может быть удалена взятием

разности соответствующего порядка. Это означает,

что из каждого i-го элемента ряда вычитается (i-k)-й

элемент. Имеются два довода в пользу таких

преобразований.

Во-первых, таким образом можно определить

скрытые периодические составляющие ряда.

Напомним, что автокорреляции на

последовательных лагах зависимы. Поэтому

удаление некоторых автокорреляций изменит

другие автокорреляции, которые, возможно,

подавляли их, и сделает некоторые другие

сезонные составляющие более заметными.

Во-вторых, удаление сезонных составляющих

делает ряд стационарным,

что необходимо для применения АРПСС

и других методов, например, спектрального

анализа.

АРПСС

- Общее введение

- Два основных процесса

- Модель АРПСС

- Идентификация

- Оценивание параметров

- Оценивание модели

Дополнительная информация о методах Анализа

временных рядов дана также в следующих

разделах:

- Идентификация модели

временных рядов - Прерванные временные ряды

- Экспоненциальное

сглаживание - Сезонная декомпозиция (метод

Census I) - Сезонная корректировка X-11

(метод Census II) - Таблицы результатов

корректировки X-11 - Анализ распределенных лагов

- Одномерный анализ Фурье

- Кросс-спектральный анализ

- Основные понятия и принципы

- Быстрое преобразование Фурье

Общее введение

Процедуры оценки параметров и прогнозирования,

описанные в разделе Идентификация

модели временных рядов, предполагают, что

математическая модель процесса известна. В

реальных данных часто нет отчетливо выраженных

регулярных составляющих. Отдельные наблюдения

содержат значительную ошибку, тогда как вы

хотите не только выделить регулярные компоненты,

но также построить прогноз. Методология АРПСС,

разработанная Боксом и Дженкинсом (1976), позволяет

это сделать. Данный метод чрезвычайно популярен

во многих приложениях, и практика подтвердила

его мощность и гибкость (Hoff, 1983; Pankratz, 1983; Vandaele, 1983).

Однако из-за мощности и гибкости, АРПСС — сложный

метод. Его не так просто использовать, и

требуется большая практика, чтобы овладеть им.

Хотя часто он дает удовлетворительные

результаты, они зависят от квалификации

пользователя (Bails and Peppers, 1982). Следующие разделы

познакомят вас с его основными идеями. Для

интересующихся кратким, рассчитанным на

применение, (нематематическим) введением в АРПСС,

рекомендуем книгу McCleary, Meidinger, and Hay (1980).

Два основных процесса

Процесс авторегрессии. Большинство

временных рядов содержат элементы, которые

последовательно зависят друг от друга. Такую

зависимость можно выразить следующим

уравнением:

xt =

+ 1*x(t-1) +

2*x(t-2) +

3*x(t-3) + … +

Здесь:

—

константа (свободный член),

1,

2,

3

— параметры авторегрессии.

Вы видите, что каждое наблюдение есть сумма

случайной компоненты (случайное воздействие, ) и линейной

комбинации предыдущих наблюдений.

Требование стационарности. Заметим, что

процесс авторегрессии будет стационарным

только, если его параметры лежат в определенном

диапазоне. Например, если имеется только один

параметр, то он должен находиться в интервале -1<<+1. В противном случае,

предыдущие значения будут накапливаться и

значения последующих xt могут быть

неограниченными, следовательно, ряд не будет стационарным.

Если имеется несколько параметров

авторегрессии, то можно определить аналогичные

условия, обеспечивающие стационарность (см.

например, Бокс и Дженкинс, 1976; Montgomery, 1990).

Процесс скользящего среднего. В отличие от

процесса авторегрессии, в процессе скользящего

среднего каждый элемент ряда подвержен

суммарному воздействию предыдущих ошибок. В

общем виде это можно записать следующим образом:

xt = µ + t —

1*

(t-1) —

2*

(t-2) —

3*

(t-3) — …

Здесь:

µ —

константа,

1,

2,

3 —

параметры скользящего среднего.

Другими словами, текущее наблюдение ряда

представляет собой сумму случайной компоненты

(случайное воздействие, ) в данный момент и линейной

комбинации случайных воздействий в предыдущие

моменты времени.

Обратимость. Не вдаваясь в детали, отметим,

что существует «двойственность» между

процессами скользящего среднего и авторегрессии

(см. например, Бокс и Дженкинс, 1976; Montgomery, Johnson, and

Gardiner, 1990). Это означает, что приведенное выше

уравнение скользящего среднего можно переписать

(обратить) в виде уравнения авторегрессии

(неограниченного порядка), и наоборот. Это так

называемое свойство обратимости. Имеются

условия, аналогичные приведенным выше условиям стационарности,

обеспечивающие обратимость модели.

Модель АРПСС

Модель авторегрессии и скользящего среднего. Общая

модель, предложенная Боксом и Дженкинсом (1976)

включает как параметры авторегрессии, так и

параметры скользящего среднего. Именно, имеется

три типа параметров модели: параметры

авторегрессии (p), порядок разности (d), параметры

скользящего среднего (q). В обозначениях Бокса

и Дженкинса модель записывается как АРПСС (p, d, q).

Например, модель (0, 1, 2) содержит 0

(нуль) параметров авторегрессии (p) и 2

параметра скользящего среднего (q), которые

вычисляются для ряда после взятия разности с

лагом 1.

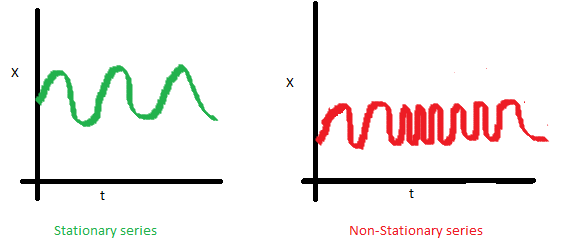

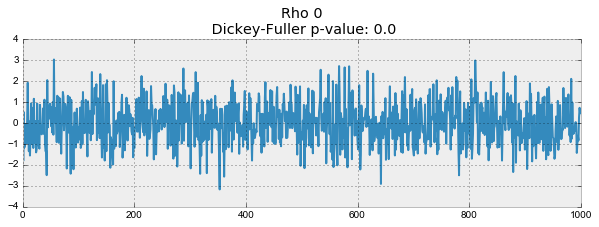

Идентификация. Как отмечено ранее, для

модели АРПСС необходимо, чтобы ряд был стационарным,

это означает, что его среднее постоянно, а

выборочные дисперсия и автокорреляция не

меняются во времени. Поэтому обычно необходимо

брать разности ряда до тех пор, пока он не станет

стационарным

(часто также применяют логарифмическое

преобразование для стабилизации дисперсии).

Число разностей, которые были взяты, чтобы

достичь стационарности, определяются параметром

d (см. предыдущий раздел). Для того чтобы

определить необходимый порядок разности, нужно

исследовать график ряда и автокоррелограмму.

Сильные изменения уровня (сильные скачки вверх

или вниз) обычно требуют взятия несезонной

разности первого порядка (лаг=1). Сильные

изменения наклона требуют взятия разности

второго порядка. Сезонная составляющая требует

взятия соответствующей сезонной разности (см.

ниже). Если имеется медленное убывание

выборочных коэффициентов автокорреляции в

зависимости от лага, обычно берут разность

первого порядка. Однако следует помнить, что для

некоторых временных рядов нужно брать разности

небольшого порядка или вовсе не брать их.

Заметим, что чрезмерное количество взятых

разностей приводит к менее стабильным оценкам

коэффициентов.

На этом этапе (который обычно называют идентификацией

порядка модели, см. ниже) вы также должны

решить, как много параметров авторегрессии (p)

и скользящего среднего (q) должно

присутствовать в эффективной и экономной модели

процесса. (Экономность модели означает, что в

ней имеется наименьшее число параметров и

наибольшее число степеней свободы среди всех

моделей, которые подгоняются к данным). На

практике очень редко бывает, что число

параметров p или q больше 2 (см. ниже более

полное обсуждение).

Оценивание и прогноз. Следующий, после

идентификации, шаг (Оценивание) состоит в

оценивании параметров модели (для чего

используются процедуры минимизации функции

потерь, см. ниже; более подробная информация о

процедурах минимизации дана в разделе Нелинейное оценивание).

Полученные оценки параметров используются на

последнем этапе (Прогноз) для того, чтобы

вычислить новые значения ряда и построить

доверительный интервал для прогноза. Процесс

оценивания проводится по преобразованным данным

(подвергнутым применению разностного оператора).

До построения прогноза нужно выполнить обратную

операцию (интегрировать данные). Таким

образом, прогноз методологии будет сравниваться

с соответствующими исходными данными. На

интегрирование данных указывает буква П в

общем названии модели (АРПСС = Авторегрессионное

Проинтегрированное Скользящее Среднее).

Константа в моделях АРПСС. Дополнительно

модели АРПСС могут содержать константу,

интерпретация которой зависит от подгоняемой

модели. Именно, если (1) в модели нет параметров

авторегрессии, то константа есть среднее значение ряда, если (2)

параметры авторегрессии имеются, то константа

представляет собой свободный член. Если бралась

разность ряда, то константа представляет собой

среднее или свободный член преобразованного

ряда. Например, если бралась первая разность

(разность первого порядка), а параметров

авторегрессии в модели нет, то константа

представляет собой среднее значение

преобразованного ряда и, следовательно, коэффициент

наклона линейного тренда исходного.

Идентификация

Число оцениваемых параметров. Конечно, до

того, как начать оценивание, вам необходимо

решить, какой тип модели будет подбираться к

данным, и какое количество параметров

присутствует в модели, иными словами, нужно

идентифицировать модель АРПСС. Основными

инструментами идентификации порядка модели

являются графики, автокорреляционная функция

(АКФ), частная автокорреляционная функция (ЧАКФ).

Это решение не является простым и требуется

основательно поэкспериментировать с

альтернативными моделями. Тем не менее,

большинство встречающихся на практике временных

рядов можно с достаточной степенью точности

аппроксимировать одной из 5 основных моделей (см.

ниже), которые можно идентифицировать по виду

автокорреляционной (АКФ) и частной

автокорреляционной функции (ЧАКФ). Ниже дается

список этих моделей, основанный на рекомендациях

Pankratz (1983); дополнительные практические советы

даны в Hoff (1983), McCleary and Hay (1980), McDowall, McCleary, Meidinger, and Hay

(1980), and Vandaele (1983). Отметим, что число параметров

каждого вида невелико (меньше 2), поэтому нетрудно

проверить альтернативные модели.

- Один параметр (p): АКФ — экспоненциально

убывает; ЧАКФ — имеет резко выделяющееся значение

для лага 1, нет корреляций на других лагах. - Два параметра авторегрессии (p): АКФ имеет

форму синусоиды или экспоненциально убывает;

ЧАКФ имеет резко выделяющиеся значения на лагах 1,

2, нет корреляций на других лагах. - Один параметр скользящего среднего (q): АКФ

имеет резко выделяющееся значение на лаге 1,

нет корреляций на других лагах. ЧАКФ

экспоненциально убывает. - Два параметра скользящего среднего (q): АКФ

имеет резко выделяющиеся значения на лагах 1, 2,

нет корреляций на других лагах. ЧАКФ имеет форму

синусоиды или экспоненциально убывает. - Один параметр авторегрессии (p) и один параметр

скользящего среднего (q): АКФ экспоненциально

убывает с лага 1; ЧАКФ — экспоненциально

убывает с лага 1.

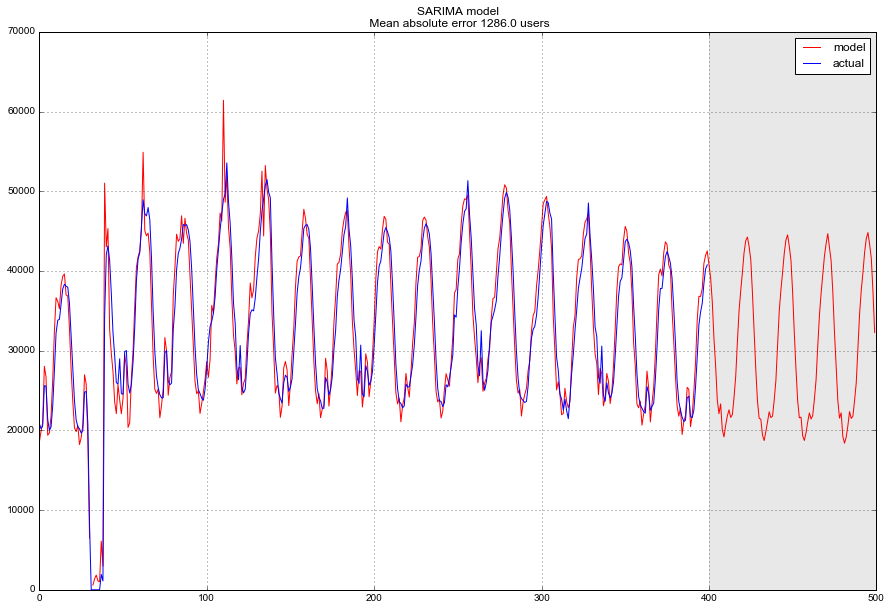

Сезонные модели. Мультипликативная сезонная

АРПСС представляет естественное развитие и

обобщение обычной модели АРПСС на ряды, в которых

имеется периодическая сезонная компонента. В

дополнении к несезонным параметрам, в модель

вводятся сезонные параметры для определенного

лага (устанавливаемого на этапе идентификации

порядка модели). Аналогично параметрам простой

модели АРПСС, эти параметры называются: сезонная

авторегрессия (ps), сезонная разность (ds) и

сезонное скользящее среднее (qs). Таким

образом, полная сезонная АРПСС может быть

записана как АРПСС (p,d,q)(ps,ds,qs).

Например, модель (0,1,2)(0,1,1) включает 0

регулярных параметров авторегрессии, 2

регулярных параметра скользящего среднего и 1

параметр сезонного скользящего среднего. Эти

параметры вычисляются для рядов, получаемых

после взятия одной разности с лагом 1 и далее

сезонной разности. Сезонный лаг, используемый

для сезонных параметров, определяется на этапе

идентификации порядка модели.

Общие рекомендации относительно выбора

обычных параметров (с помощью АКФ и ЧАКФ)

полностью применимы к сезонным моделям. Основное

отличие состоит в том, что в сезонных рядах АКФ и

ЧАКФ имеют существенные значения на лагах,

кратных сезонному лагу (в дополнении к

характерному поведению этих функций,

описывающих регулярную (несезонную) компоненту

АРПСС).

Оценивание параметров

Существуют различные методы оценивания

параметров, которые дают очень похожие оценки, но

для данной модели одни оценки могут быть более

эффективны, а другие менее эффективны. В общем, во

время оценивания порядка модели используется

так называемый квазиньютоновский алгоритм

максимизации правдоподобия (вероятности)

наблюдения значений ряда по значениям

параметров (см. Нелинейное

оценивание). Практически это требует

вычисления (условных) сумм квадратов (SS)

остатков модели. Имеются различные способы

вычисления суммы квадратов остатков SS; вы

можете выбрать: (1) приближенный метод

максимального правдоподобия МакЛеода и Сейлза

(1983), (2) приближенный метод максимального

правдоподобия с итерациями назад, (3)точный метод

максимального правдоподобия по Meларду (1984).

Сравнение методов. В общем, все методы дают

очень похожие результаты. Также все методы

показали примерно одинаковую эффективность на

реальных данных. Однако метод 1 (см. выше) —

самый быстрый, и им можно пользоваться для

исследования очень длинных рядов (например,

содержащих более 30,000 наблюдений). Метод Меларда

(номер 3) может оказаться неэффективным, если

оцениваются параметры сезонной модели с большим

сезонным лагом (например, 365 дней). С другой

стороны, вы можете использовать вначале

приближенный метод максимального правдоподобия

(для того, чтобы найти прикидочные оценки

параметров), а затем точный метод; обычно

требуется только несколько итераций точного

метода (номер 3, выше), чтобы получить

окончательные оценки.

Стандартные ошибки оценок. Для всех оценок

параметров вычисляются так называемые асимптотические

стандартные ошибки, для вычисления которых

используется матрица частных производных

второго порядка, аппроксимируемая конечными

разностями (см. также раздел Нелинейное

оценивание).

Штраф. Процедура оценивания минимизирует

(условную) сумму квадратов остатков модели. Если

модель не является адекватной, может случиться

так, что оценки параметров на каком-то шаге

станут неприемлемыми — очень большими (например,

не удовлетворяют условию стационарности). В

таком случае, SS будет приписано очень большое

значение (штрафное значение). Обычно это

«заставляет» итерационный процесс удалить

параметры из недопустимой области. Однако в

некоторых случаях и эта стратегия может

оказаться неудачной, и вы все равно увидите на

экране (во время процедуры оценивания) очень

большие значения SS на серии итераций. В таких

случаях следует с осторожностью оценивать

пригодность модели. Если модель содержит много

параметров и, возможно, имеется интервенция (см.

ниже), то следует несколько раз испытать процесс

оценивания с различными начальными. Если модель

содержит много параметров и, возможно,

интервенцию (см. ниже), вам следует повторить

процедуру с различными начальными значениями

параметров.

Оценивание модели

Оценки параметров. Если значения

вычисляемой t статистики не значимы,

соответствующие параметры в большинстве случаев

удаляются из модели без ущерба подгонки.

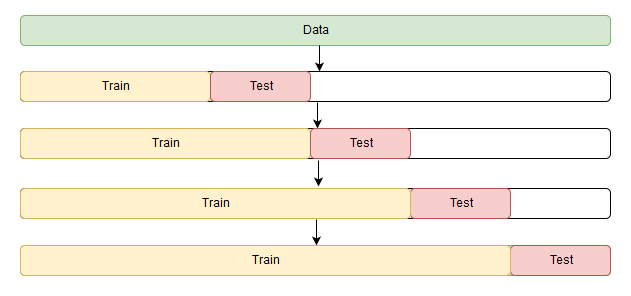

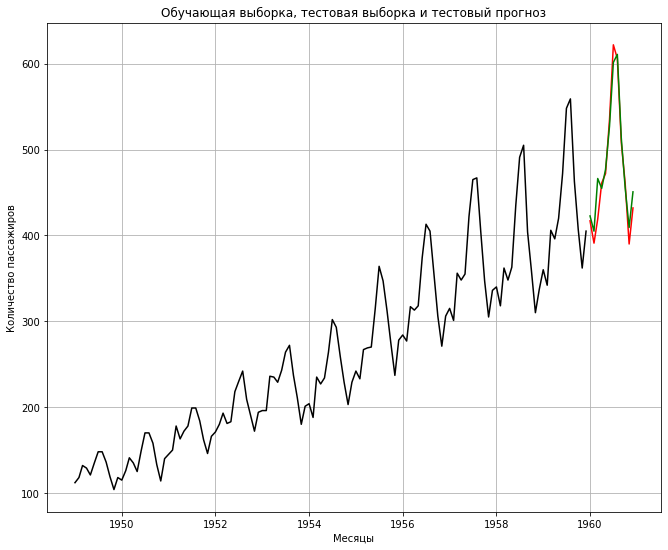

Другой критерий качества. Другой обычной

мерой надежности модели является сравнение

прогноза, построенного по урезанному ряду с

«известными (исходными) данными».

Однако качественная модель должна не только

давать достаточно точный прогноз, но быть

экономной и иметь независимые остатки,

содержащие только шум без систематических

компонент (в частности, АКФ остатков не должна

иметь какой-либо периодичности). Поэтому

необходим всесторонний анализ остатков. Хорошей

проверкой модели являются: (a) график остатков и

изучение их трендов, (b) проверка АКФ остатков (на

графике АКФ обычно отчетливо видна

периодичность).

Анализ остатков. Если остатки

систематически распределены (например,

отрицательны в первой части ряда и примерно

равны нуля во второй) или включают некоторую

периодическую компоненту, то это

свидетельствует о неадекватности модели. Анализ

остатков чрезвычайно важен и необходим при

анализе временных рядов. Процедура оценивания

предполагает, что остатки не коррелированы и

нормально распределены.

Ограничения. Следует напомнить, что модель

АРПСС является подходящей только для рядов,

которые являются стационарными

(среднее, дисперсия и автокорреляция примерно

постоянны во времени); для нестационарных рядов

следует брать разности. Рекомендуется иметь, как

минимум, 50 наблюдений в файле исходных данных.

Также предполагается, что параметры модели

постоянны, т.е. не меняются во времени.

Прерванные временные ряды

Обычный вопрос, возникающий при анализе

временных рядов, состоит в следующем,

воздействует или нет внешнее событие на

последовательность наблюдений. Например,

привела ли новая экономическая политика к росту

экономики, как обещалось; изменил ли новый закон

интенсивность преступлений и т.д. В общем, нужно

оценивать воздействия одного или нескольких

дискретных событий на значения ряда. Этот вид

анализа прерванных временных рядов подробно

описан в книге McDowall, McCleary, Meidinger, and Hay (1980).

Различают следующие три типа воздействий: (1)

устойчивое скачкообразное, (2) устойчивое

постепенное, (3) скачкообразное временное. См.

также следующие разделы:

- Идентификация модели

временных рядов - АРПСС

- Экспоненциальное

сглаживание - Сезонная декомпозиция (метод

Census I) - Сезонная корректировка X-11

(метод Census II) - Таблицы результатов

корректировки X-11 - Анализ распределенных лагов

- Одномерный анализ Фурье

- Кросс-спектральный анализ

- Основные понятия и принципы

- Быстрое преобразование Фурье

Экспоненциальное сглаживание

- Общее введение

- Простое экспоненциальное

сглаживание - Выбор лучшего значения

параметра a (альфа) - Индексы качества подгонки

- Сезонная и несезонная модели

с трендом или без тренда

См. также:

- Идентификация модели

временных рядов - АРПСС (Бокс и Дженкинс) и

автокорреляции - Прерванные временные ряды

- Сезонная декомпозиция (метод

Census I) - Сезонная корректировка X-11

(метод Census II) - Таблицы результатов

корректировки X-11 - Анализ распределенных лагов

- Одномерный анализ Фурье

- Кросс-спектральный анализ

- Основные понятия и принципы

- Быстрое преобразование Фурье

Общее введение

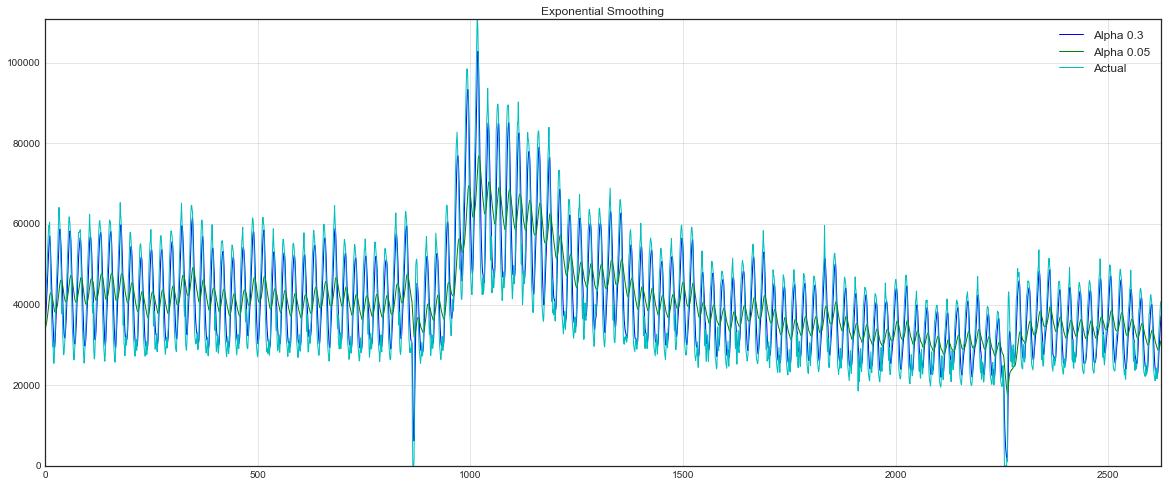

Экспоненциальное сглаживание — это очень

популярный метод прогнозирования многих

временных рядов. Исторически метод был

независимо открыт Броуном и Холтом. Броун служил

на флоте США во время второй мировой войны, где

занимался обнаружением подводных лодок и

системами наведения. Позже он применил открытый

им метод для прогнозирования спроса на запасные

части. Свои идеи он описал в книге, вышедшей в

свет в 1959 году. Исследования Холта были

поддержаны Департаментом военно-морского флота

США. Независимо друг от друга, Броун и Холт

открыли экспоненциальное сглаживание для

процессов с постоянным трендом, с линейным

трендом и для рядов с сезонной составляющей.

Gardner (1985), предложил «единую» классификацию

методов экспоненциального сглаживания.

Превосходное введение в эти методы можно найти в

книгах Makridakis, Wheelwright, and McGee (1983), Makridakis and Wheelwright (1989),

Montgomery, Johnson, and Gardiner (1990).

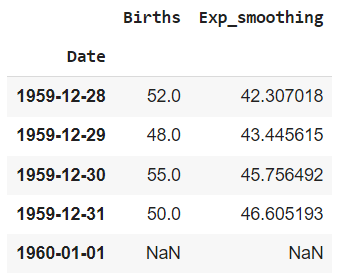

Простое экспоненциальное

сглаживание

Простая и прагматически ясная модель

временного ряда имеет следующий вид: Xt = b + t, где b —

константа и

(эпсилон) — случайная ошибка. Константа b относительно

стабильна на каждом временном интервале, но

может также медленно изменяться со временем.

Один из интуитивно ясных способов выделения b

состоит в том, чтобы использовать сглаживание

скользящим средним, в котором последним

наблюдениям приписываются большие веса, чем

предпоследним, предпоследним большие веса, чем

пред-предпоследним и т.д. Простое

экспоненциальное именно так и устроено. Здесь

более старым наблюдениям приписываются

экспоненциально убывающие веса, при этом, в

отличие от скользящего среднего, учитываются все

предшествующие наблюдения ряда, а не те, что

попали в определенное окно. Точная формула

простого экспоненциального сглаживания имеет

следующий вид:

St = *Xt + (1-

)*St-1

Когда эта формула применяется рекурсивно, то

каждое новое сглаженное значение (которое

является также прогнозом) вычисляется как

взвешенное среднее текущего наблюдения и

сглаженного ряда. Очевидно, результат

сглаживания зависит от параметра (альфа). Если

равно 1, то

предыдущие наблюдения полностью игнорируются.

Если равно 0, то

игнорируются текущие наблюдения. Значения между 0, 1 дают

промежуточные результаты.

Эмпирические исследования Makridakis и др. (1982;

Makridakis, 1983) показали, что весьма часто простое

экспоненциальное сглаживание дает достаточно

точный прогноз.

Выбор лучшего значения

параметра (альфа)

Gardner (1985) обсуждает различные теоретические и

эмпирические аргументы в пользу выбора

определенного параметра сглаживания. Очевидно,

из формулы, приведенной выше, следует, что должно попадать в интервал между 0

(нулем) и 1 (хотя Brenner et al., 1968, для дальнейшего

применения анализа АРПСС считают, что 0<<2). Gardner (1985)

сообщает, что на практике обычно рекомендуется

брать меньше .30.

Однако в исследовании Makridakis et al., (1982), большее .30, часто

дает лучший прогноз. После обзора литературы,

Gardner (1985) приходит к выводу, что лучше оценивать

оптимально по данным

(см. ниже), чем просто «гадать» или

использовать искусственные рекомендации.

Оценивание лучшего значения с помощью данных. На

практике параметр сглаживания часто ищется с поиском

на сетке. Возможные значения параметра

разбиваются сеткой с определенным шагом.

Например, рассматривается сетка значений от = 0.1 до

= 0.9, с шагом 0.1.

Затем выбирается ,

для которого сумма квадратов (или средних

квадратов) остатков (наблюдаемые значения минус

прогнозы на шаг вперед) является минимальной.

Индексы качества подгонки

Самый прямой способ оценки прогноза,

полученного на основе определенного значения — построить график

наблюдаемых значений и прогнозов на один шаг

вперед. Этот график включает в себя также остатки

(отложенные на правой оси Y). Из графика ясно

видно, на каких участках прогноз лучше или хуже.

Такая визуальная проверка точности прогноза

часто дает наилучшие результаты. Имеются также

другие меры ошибки, которые можно использовать

для определения оптимального параметра (см. Makridakis, Wheelwright, and McGee,

1983):

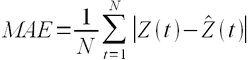

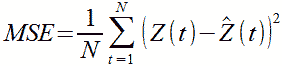

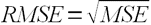

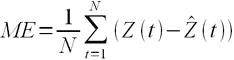

Средняя ошибка. Средняя ошибка (СО)

вычисляется простым усреднением ошибок на

каждом шаге. Очевидным недостатком этой меры

является то, что положительные и отрицательные

ошибки аннулируют друг друга, поэтому она не

является хорошим индикатором качества прогноза.

Средняя абсолютная ошибка. Средняя

абсолютная ошибка (САО) вычисляется как среднее абсолютных

ошибок. Если она равна 0 (нулю), то имеем

совершенную подгонку (прогноз). В сравнении со

средней квадратической ошибкой, эта мера

«не придает слишком большого значения»

выбросам.

Сумма квадратов ошибок (SSE),

среднеквадратическая ошибка. Эти величины

вычисляются как сумма (или среднее) квадратов

ошибок. Это наиболее часто используемые индексы

качества подгонки.

Относительная ошибка (ОО). Во всех

предыдущих мерах использовались действительные

значения ошибок. Представляется естественным

выразить индексы качества подгонки в терминах относительных

ошибок. Например, при прогнозе месячных продаж,

которые могут сильно флуктуировать (например, по

сезонам) из месяца в месяц, вы можете быть вполне

удовлетворены прогнозом, если он имеет точность

?10%. Иными словами, при прогнозировании

абсолютная ошибка может быть не так интересна

как относительная. Чтобы учесть относительную

ошибку, было предложено несколько различных

индексов (см. Makridakis, Wheelwright, and McGee, 1983). В первом

относительная ошибка вычисляется как:

ООt = 100*(Xt — Ft )/Xt

где Xt — наблюдаемое

значение в момент времени t, и Ft — прогноз (сглаженное

значение).

Средняя относительная ошибка (СОО).

Это значение вычисляется как среднее

относительных ошибок.

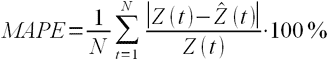

Средняя абсолютная относительная ошибка

(САОО). Как и в случае с обычной средней

ошибкой отрицательные и положительные

относительные ошибки будут подавлять друг друга.

Поэтому для оценки качества подгонки в целом (для

всего ряда) лучше использовать среднюю абсолютную

относительную ошибку. Часто эта мера более

выразительная, чем среднеквадратическая ошибка.

Например, знание того, что точность прогноза ±5%,

полезно само по себе, в то время как значение 30.8

для средней квадратической ошибки не может быть

так просто проинтерпретировано.

Автоматический поиск лучшего параметра.

Для минимизации средней квадратической ошибки,

средней абсолютной ошибки или средней

абсолютной относительной ошибки используется

квази-ньютоновская процедура (та же, что и в АРПСС). В большинстве случаев

эта процедура более эффективна, чем обычный

перебор на сетке (особенно, если параметров

сглаживания несколько), и оптимальное значение можно быстро

найти.

Первое сглаженное значение S0.

Если вы взгляните снова на формулу простого

экспоненциального сглаживания, то увидите, что

следует иметь значение S0 для

вычисления первого сглаженного значения

(прогноза). В зависимости от выбора параметра (в частности, если

близко к 0), начальное

значение сглаженного процесса может оказать

существенное воздействие на прогноз для многих

последующих наблюдений. Как и в других

рекомендациях по применению экспоненциального

сглаживания, рекомендуется брать начальное

значение, дающее наилучший прогноз. С другой

стороны, влияние выбора уменьшается с длиной

ряда и становится некритичным при большом числе

наблюдений.

Сезонная и несезонная модели с

трендом или без тренда

В дополнение к простому экспоненциальному

сглаживанию, были предложены более сложные

модели, включающие сезонную компоненту и

трендом. Общая идея таких моделей состоит в том,

что прогнозы вычисляются не только по предыдущим

наблюдениям (как в простом экспоненциальном

сглаживании), но и с некоторыми задержками, что

позволяет независимо оценить тренд и сезонную

составляющую. Gardner (1985) обсудил различные модели в

терминах сезонности (отсутствует, аддитивная

сезонность, мультипликативная) и тренда

(отсутствует, линейный тренд, экспоненциальный,

демпфированный).

Аддитивная и мультипликативная

сезонность. Многие временные ряды имеют

сезонные компоненты. Например, продажи игрушек

имеют пики в ноябре, декабре и, возможно, летом,

когда дети находятся на отдыхе. Эта

периодичность имеет место каждый год. Однако

относительный размер продаж может слегка

изменяться из года в год. Таким образом, имеет

смысл независимо экспоненциально сгладить

сезонную компоненту с дополнительным

параметром, обычно обозначаемым как (дельта). Сезонные

компоненты, по природе своей, могут быть

аддитивными или мультипликативными. Например, в

течение декабря продажи определенного вида

игрушек увеличиваются на 1 миллион долларов

каждый год. Для того чтобы учесть сезонное

колебание, вы можете добавить в прогноз на каждый

декабрь 1 миллион долларов (сверх

соответствующего годового среднего). В этом

случае сезонность — аддитивная. Альтернативно,

пусть в декабре продажи увеличились на 40%, т.е. в 1.4

раза. Тогда, если общие продажи малы, то

абсолютное (в долларах) увеличение продаж в

декабре тоже относительно мало (процент роста

константа). Если в целом продажи большие, то

абсолютное (в долларах) увеличение продаж будет

пропорционально больше. Снова, в этом случае

продажи увеличатся в определенное число раз, и

сезонность будет мультипликативной (в данном

случае мультипликативная сезонная составляющая

была бы равна 1.4). На графике различие между двумя

видами сезонности состоит в том, что в аддитивной

модели сезонные флуктуации не зависят от

значений ряда, тогда как в мультипликативной

модели величина сезонных флуктуаций зависит от

значений временного ряда.

Параметр сезонного сглаживания . В общем, прогноз

на один шаг вперед вычисляется следующим образом

(для моделей без тренда; для моделей с линейным и

экспоненциальным трендом, тренд добавляется; см.

ниже):

Аддитивная модель:

Прогнозt = St + It-p

Мультипликативная модель:

Прогнозt = St*It-p

В этой формуле St

обозначает (простое) экспоненциально сглаженное

значение ряда в момент t, и It-p обозначает сглаженный

сезонный фактор в момент t

минус p (p —

длина сезона). Таким образом, в сравнении с

простым экспоненциальным сглаживанием, прогноз

«улучшается» добавлением или умножением

сезонной компоненты. Эта компонента оценивается

независимо с помощью простого экспоненциального

сглаживания следующим образом:

Аддитивная модель:

It = It-p + *(1-

)*et

Мультипликативная модель:

It = It-p + *(1-

)*et/St

Обратите внимание, что предсказанная сезонная

компонента в момент t

вычисляется, как соответствующая компонента на

последнем сезонном цикле плюс ошибка (et,

наблюдаемое минус прогнозируемое значение в

момент t). Ясно, что параметр принимает значения

между 0 и 1. Если он равен нулю, то сезонная

составляющая на следующем цикле та же, что и на

предыдущем. Если

равен 1, то сезонная составляющая

«максимально» меняется на каждом шаге из-за

соответствующей ошибки (множитель (1-) не

рассматривается из-за краткости введения). В

большинстве случаев, когда сезонность

присутствует, оптимальное значение лежит между 0 и 1.

Линейный, экспоненциальный,

демпфированный тренд. Возвращаясь к примеру

с игрушками, мы можем увидеть наличие линейного

тренда (например, каждый год продажи

увеличивались на 1 миллион), экспоненциального

(например, каждый год продажи возрастают в 1.3

раза) или демпфированного тренда (в первом году

продажи возросли на 1 миллион долларов; во втором

увеличение составило только 80% по сравнению с

предыдущим, т.е. на $800,000; в следующем году вновь

увеличение было только на 80%, т.е. на $800,000 * .8 = $640,000

и т.д.). Каждый тип тренда по-своему проявляется в

данных. В целом изменение тренда — медленное в

течение времени, и опять (как и сезонную

компоненту) имеет смысл экспоненциально

сгладить его с отдельным параметром

[обозначаемым (гамма)

— для линейного и экспоненциального тренда, (фи) — для

демпфированного тренда].

Параметры сглаживания (линейный и экспоненциальный тренд) и

(демпфированный тренд). Аналогично

сезонной компоненте компонента тренда

включается в процесс экспоненциального

сглаживания. Сглаживание ее производится в

каждый момент времени независимо от других

компонент с соответствующими параметрами. Если равно 0, то тренд

постоянен для всех значений временного ряда (и

для всех прогнозов). Если равно 1, то тренд «максимально»

определяется ошибками наблюдений. Параметр учитывает, как сильно

изменяется тренд, т.е. как быстро он

«демпфируется» или, наоборот, возрастает.

Сезонная декомпозиция (метод Census I)

- Общее введение

- Вычисления

См. также:

- Идентификация модели

временных рядов - АРПСС (Бокс и Дженкинс) и

автокорреляции - Прерванные временные ряды

- Экспоненциальное

сглаживание - Сезонная корректировка X-11

(метод Census II) - Таблицы результатов

корректировки X-11 - Анализ распределенных лагов

- Одномерный анализ Фурье

- Кросс-спектральный анализ

- Основные понятия и принципы

- Быстрое преобразование Фурье

Общее введение

Предположим, что у вас имеются ежемесячные

данные о пассажиропотоке на международных

авиалиниях за 12 лет (см. Бокс и Дженкинс, 1976). Если

изобразить эти данные на графике, то будет хорошо

видно, что (1) объем пассажиропотока имеет во

времени возрастающий линейный тренд, и (2) в ряде

имеется ежегодно повторяющаяся закономерность — сезонность

(большинство перевозок приходится на летние

месяцы, кроме того, имеется пик меньшей высоты в

районе декабрьских каникул). Цель сезонной

декомпозиции и корректировки как раз и состоит в

том, чтобы отделить эти компоненты, то есть

разложить ряд на составляющую тренда, сезонную

компоненту и оставшуюся нерегулярную

составляющую. «Классический» прием,

позволяющий выполнить такую декомпозицию,

известен как метод Census I. Этот метод

описывается и обсуждается в работах Makridakis,

Wheelwright, and McGee (1983) и Makridakis and Wheelwright (1989).

Общая модель. Основная идея сезонной

декомпозиции проста. В общем случае временной

ряд типа того, который описан выше, можно

представить себе состоящим из четырех различных

компонент: (1) сезонной компоненты (обозначается St,

где t обозначает момент времени), (2) тренда (Tt),

(3) циклической компоненты (Ct) и (4)

случайной, нерегулярной компоненты или

флуктуации (It). Разница между

циклической и сезонной компонентой состоит в

том, что последняя имеет регулярную (сезонную)

периодичность, тогда как циклические факторы

обычно имеют более длительный эффект, который к

тому же меняется от цикла к циклу. В методе Census I

тренд и циклическую компоненту обычно

объединяют в одну тренд-циклическую компоненту

(TCt). Конкретные функциональные

взаимосвязи между этими компонентами могут

иметь самый разный вид. Однако, можно выделить

два основных способа, с помощью которых они могут

взаимодействовать: аддитивно и мультипликативно:

Аддитивная модель:

Xt = TCt + St + It

Мультипликативная модель:

Xt = Tt*Ct*St*It

Здесь Xt обозначает

значение временного ряда в момент времени t. Если имеются какие-то априорные сведения

о циклических факторах, влияющих на ряд

(например, циклы деловой конъюнктуры), то можно

использовать оценки для различных компонент для

составления прогноза будущих значений ряда.

(Однако для прогнозирования предпочтительнее экспоненциальное

сглаживание, позволяющее учитывать сезонную

составляющую и тренд.)

Аддитивная и мультипликативная

сезонность. Рассмотрим на примере различие

между аддитивной и мультипликативной сезонными

компонентами. График объема продаж детских

игрушек, вероятно, будет иметь ежегодный пик в

ноябре-декабре, и другой — существенно меньший по

высоте — в летние месяцы, приходящийся на

каникулы. Такая сезонная закономерность будет

повторяться каждый год. По своей природе

сезонная компонента может быть аддитивной или

мультипликативной. Так, например, каждый год

объем продаж некоторой конкретной игрушки может

увеличиваться в декабре на 3 миллиона долларов.

Поэтому вы можете учесть эти сезонные изменения, прибавляя

к своему прогнозу на декабрь 3 миллиона. Здесь

мы имеем аддитивную сезонность. Может

получиться иначе. В декабре объем продаж

некоторой игрушки может увеличиваться на 40%, то

есть умножаться на множитель 1.4. Это значит,

например, что если средний объем продаж этой

игрушки невелик, то абсолютное (в денежном

выражении) увеличение этого объема в декабре

также будет относительно небольшим (но в

процентном исчислении оно будет постоянным);

если же игрушка продается хорошо, то и абсолютный

(в долларах) рост объема продаж будет

значительным. Здесь опять, объем продаж

возрастает в число раз, равное определенному множителю,

а сезонная компонента, по своей природе,

мультипликативная компонента (в данном случае

равная 1.4). Если перейти к графикам временных

рядов, то различие между этими двумя видами

сезонности будет проявляться так: в аддитивном

случае ряд будет иметь постоянные сезонные

колебания, величина которых не зависит от общего

уровня значений ряда; в мультипликативном случае

величина сезонных колебаний будет меняться в

зависимости от общего уровня значений ряда.

Аддитивный и мультипликативный тренд-цикл. Рассмотренный

пример можно расширить, чтобы проиллюстрировать

понятия аддитивной и мультипликативной

тренд-циклических компонент. В случае с

игрушками, тренд «моды» может привести к

устойчивому росту продаж (например, это может

быть общий тренд в сторону игрушек

образовательной направленности). Как и сезонная